実装詳細

実装詳細 大規模言語モデル【Transformer:実装詳細B-5】

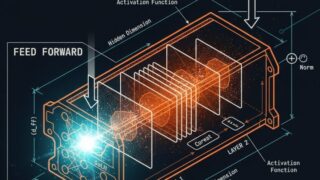

残差接続と層正規化の詳細実装12層以上の深いTransformerを安定して訓練するには、残差接続(Skip Connection) と 層正規化(Layer Normalization) が不可欠です。本記事では、これらの技術がなぜ必要で...

実装詳細

実装詳細  実装詳細

実装詳細  実装詳細

実装詳細  実装詳細

実装詳細  実装詳細

実装詳細  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論