実装詳細

実装詳細 大規模言語モデル【Transformer:実装詳細B-3】

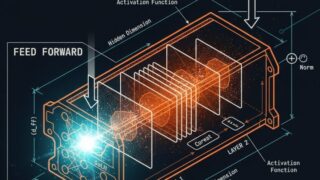

Causal Maskingと並列学習:訓練と推論の効率化前回はMulti-Head Attentionの計算フローを学びました。今回は、テキスト生成に不可欠なCausal Maskの実装と、訓練・推論の違いを解説します。因果的マスク(Ca...

実装詳細

実装詳細  実装詳細

実装詳細  実装詳細

実装詳細  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論  基礎理論

基礎理論  論文

論文  論文

論文