【今回の主な内容】時系列データから言語理解まで、Transformerの可能性を探る

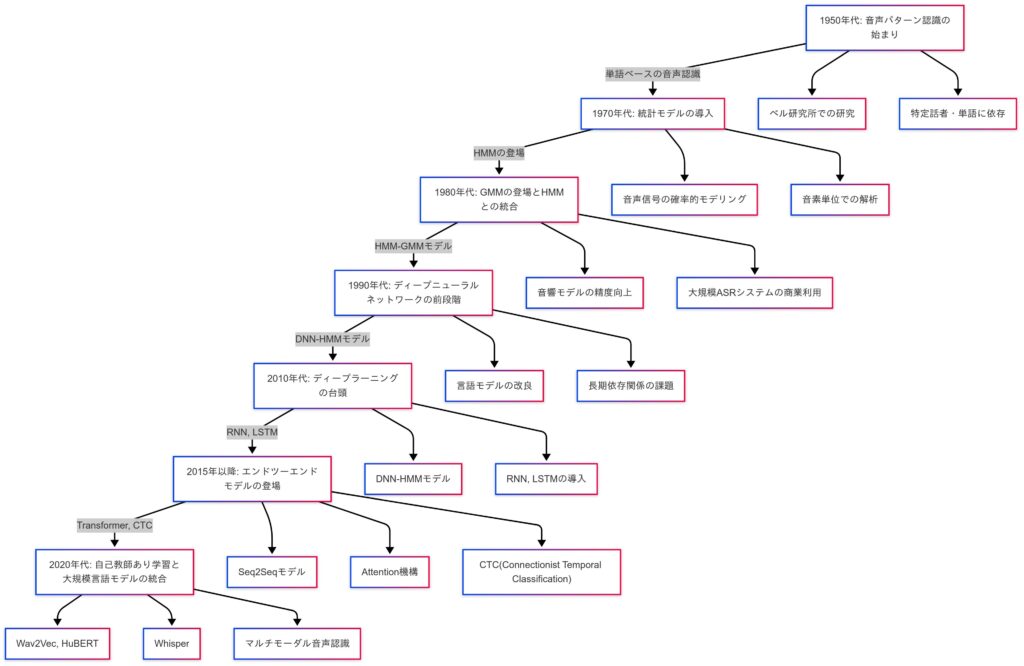

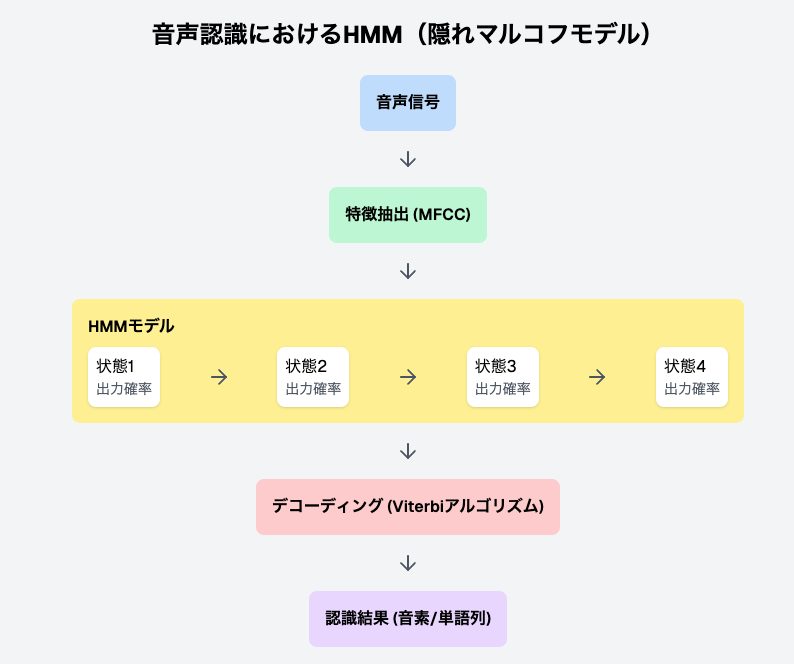

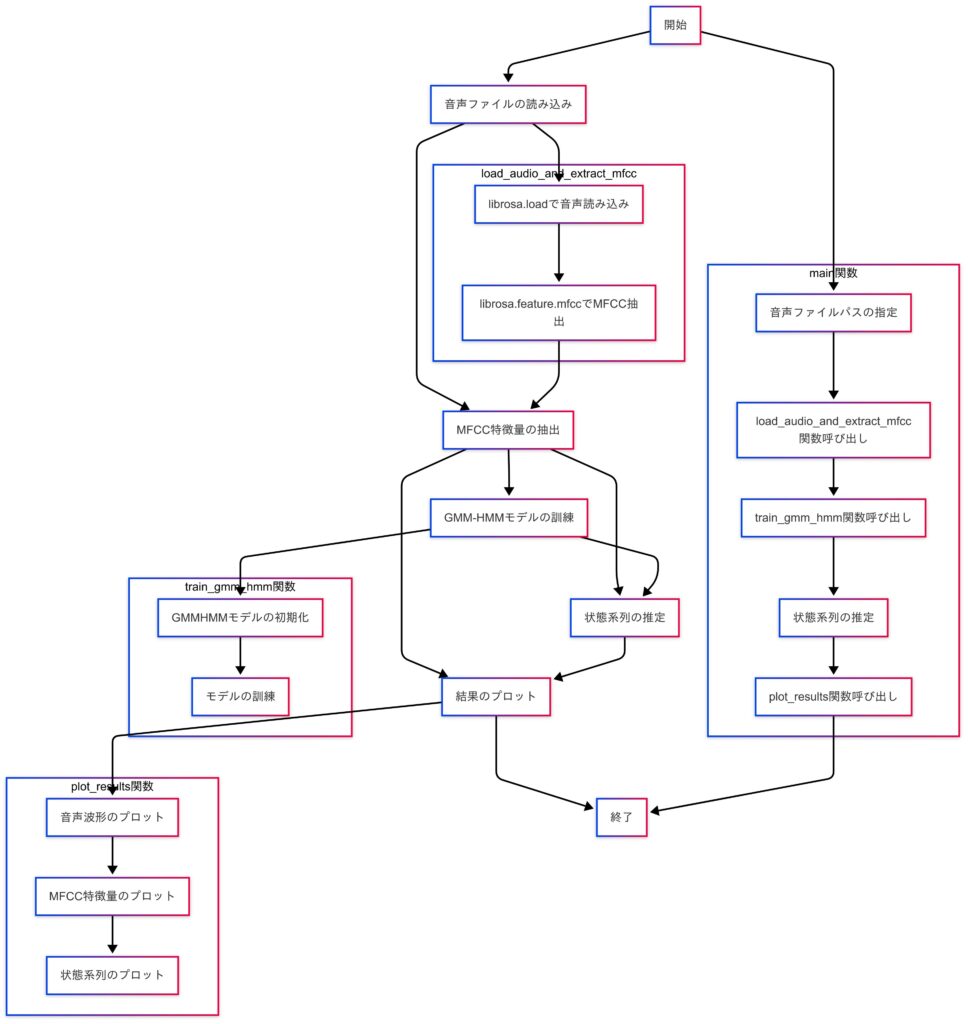

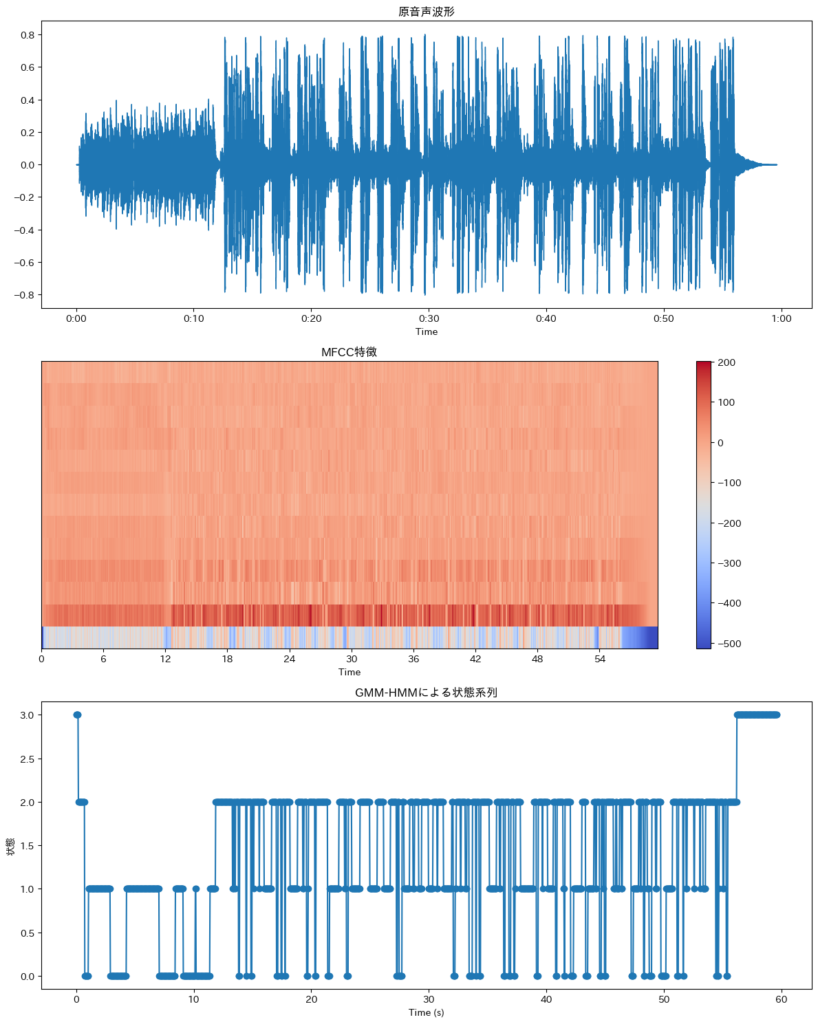

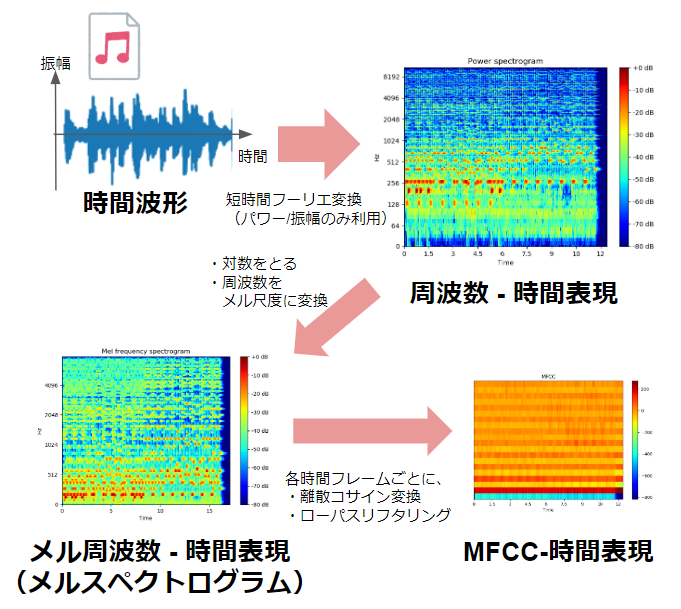

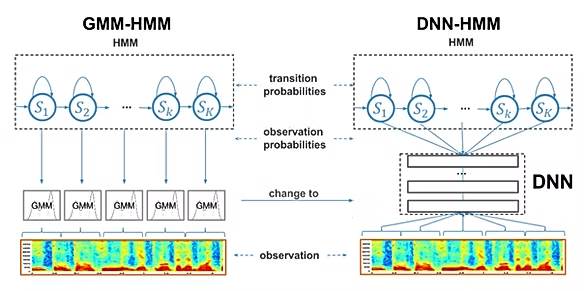

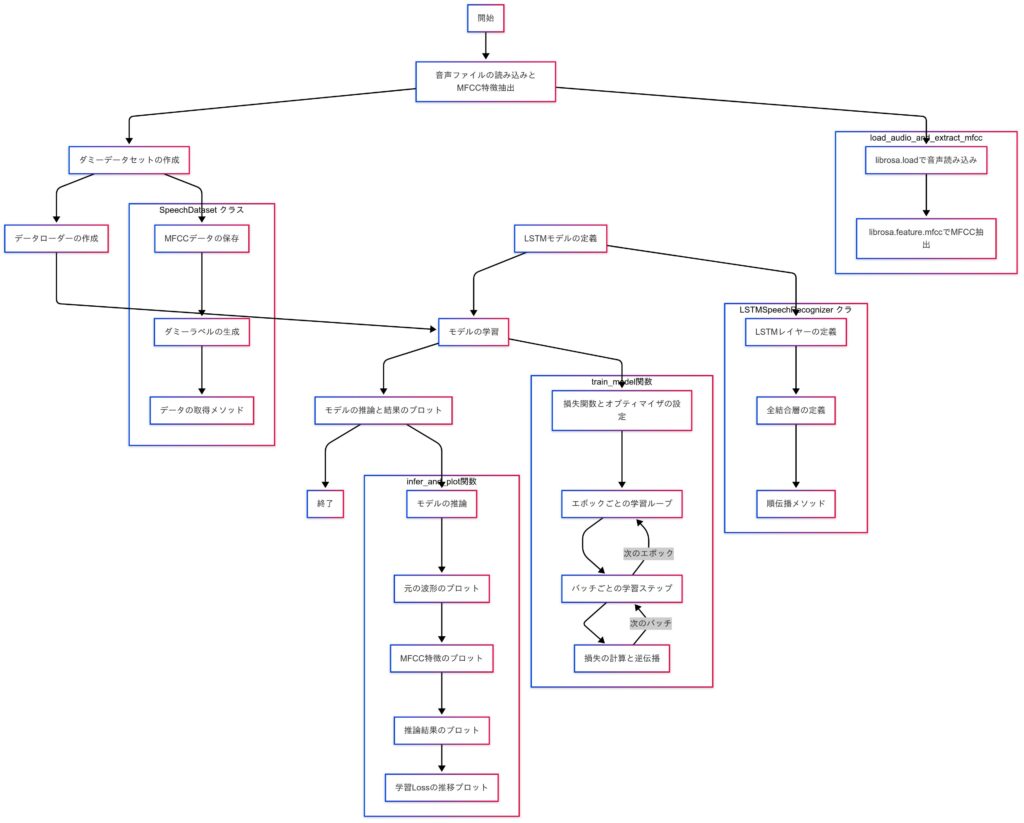

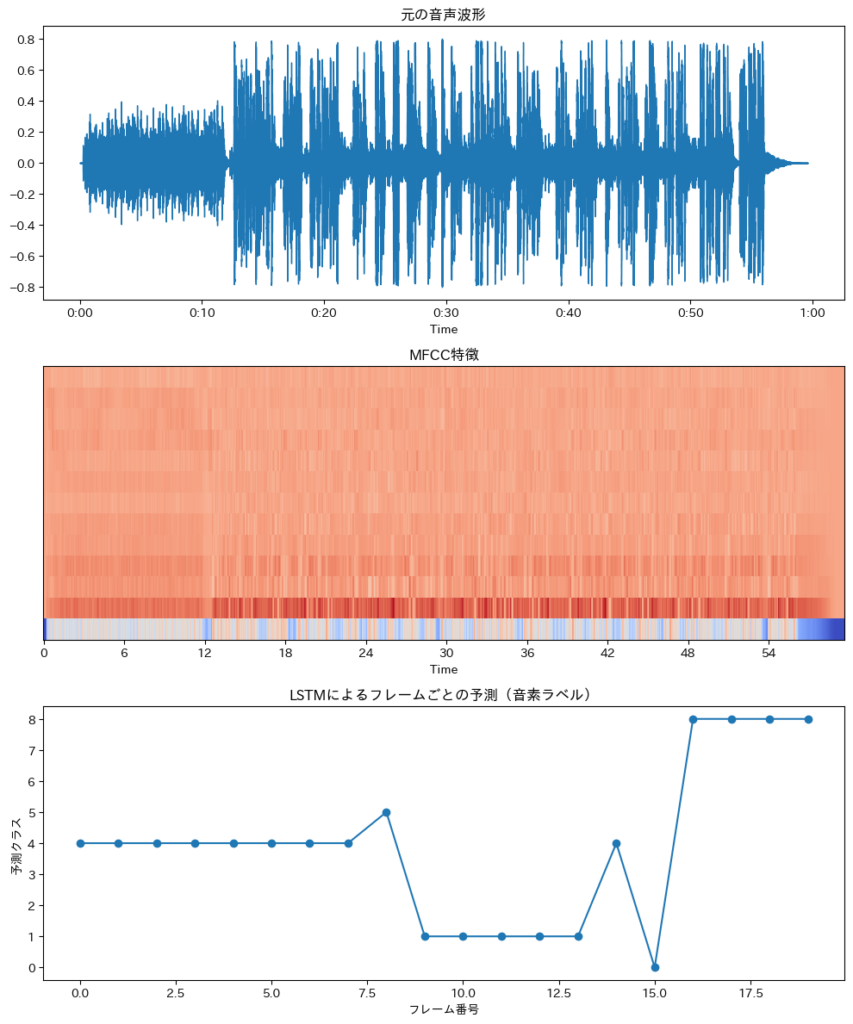

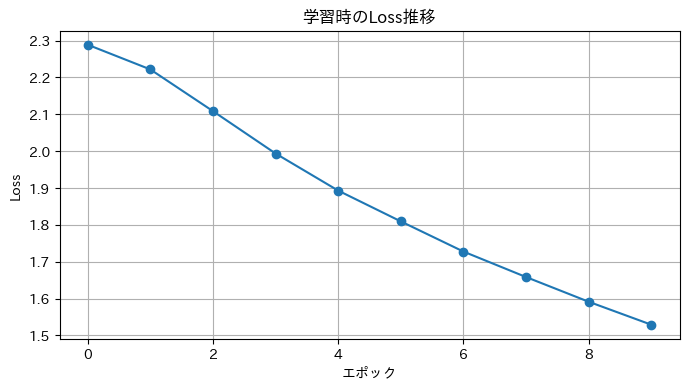

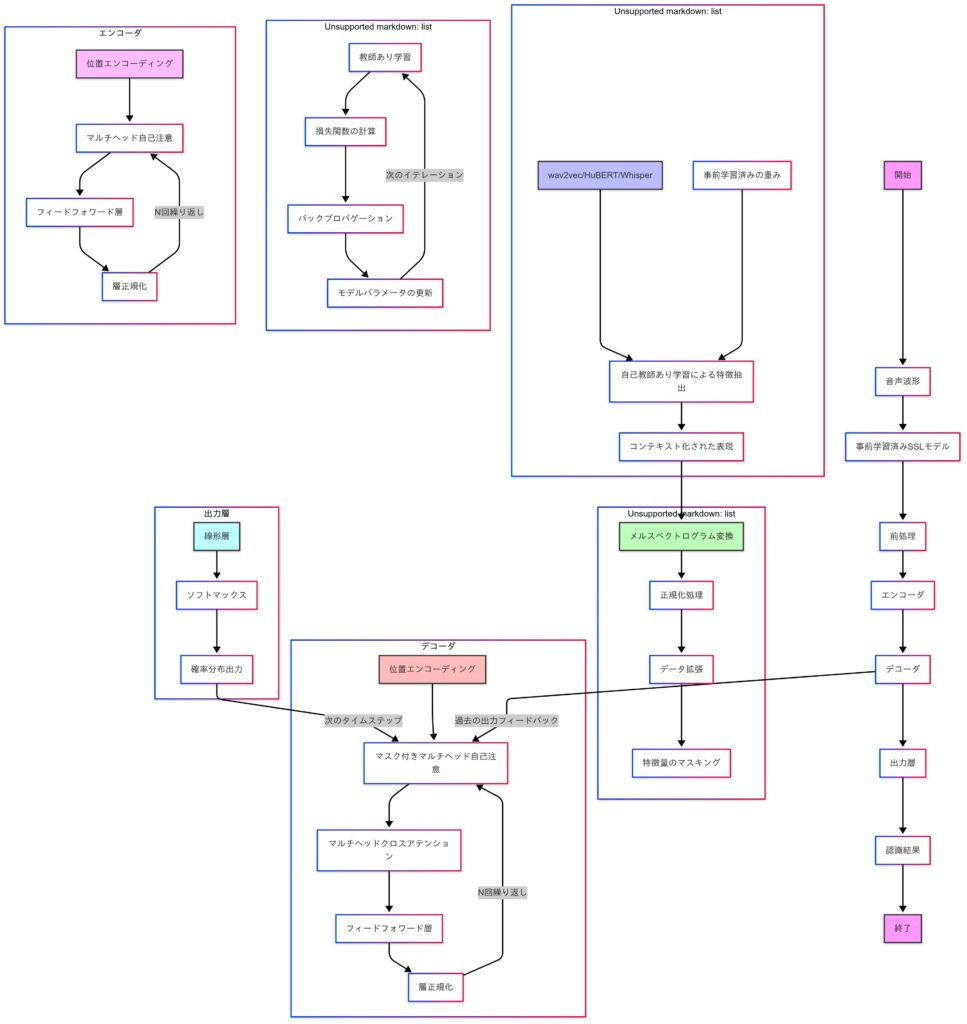

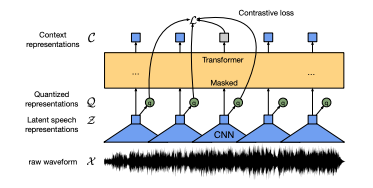

今回のテーマは自然言語処理、時系列データ解析、音声認識における技術進化の流れと、Transformerモデルの登場が果たした革新について解説します。まず、自然言語処理(NLP)の進化として、RNNやSeq2Seq、Attention機構からTransformerへの移行を説明し、BERTやGPTシリーズを具体例に応用を紹介します。その後、時系列データ解析では、RNN系の課題を克服したTransformerの強みを解説し、株価予測や異常検知などの実践例を提示します。最後に、音声認識の分野において、RNN系からSpeech-TransformerやWav2Vec 2.0への進化を示し、ラベル付けが困難な音声データへの対応策を紹介します。各章で実装例を挙げ、理論と実践の結びつきを強調します。

今回の学習目標

- 自然言語処理(NLP)の進化を理解する

- RNN、Seq2Seq、Attention機構、Transformerモデルの歴史的な流れを学び、技術進化の背景を理解します。

- NLPにおけるTransformerの革新性と具体的な応用例(BERT、GPTなど)を把握します。

- 時系列データ解析におけるTransformerの応用を学ぶ

- 時系列データの課題(長期依存関係、ノイズ、非線形パターン)と、それに対するRNN/LSTMおよびTransformerのアプローチを理解します。

- 株価予測や異常検知などの応用例を通じて、時系列データにおけるTransformerの有用性を学びます。

- 音声認識分野におけるTransformerの役割を学ぶ

- RNN系モデルからTransformer系モデルへの移行理由と、Speech-TransformerやWav2Vec 2.0などの具体的な応用事例を学びます。

学習ゴール

- 技術的な背景を説明できる

- NLPや時系列データ解析、音声認識におけるTransformerモデルの意義や進化の流れを自分の言葉で説明できるようになる。

- 応用分野での知識を活用できる

- Transformerが異なる分野(自然言語処理、時系列データ解析、音声認識)でどのように使われているかを理解し、それぞれの課題解決方法を提案できるようになる。

- 基本的な実装スキルを身に付ける

- NLPタスク(例: 文生成)、時系列予測(例: 株価予測)、音声認識(例: 音声特徴量学習)のTransformerモデルを実装し、動作を確認できる。

- 次の学習ステップを明確にする

- NLPにおけるBERTやGPTシリーズの詳細、時系列解析でのTemporal Fusion Transformer、音声認識でのWhisperモデルなど、次に学ぶべき技術やリソースを特定できる。

第10回(前編)の振り返り

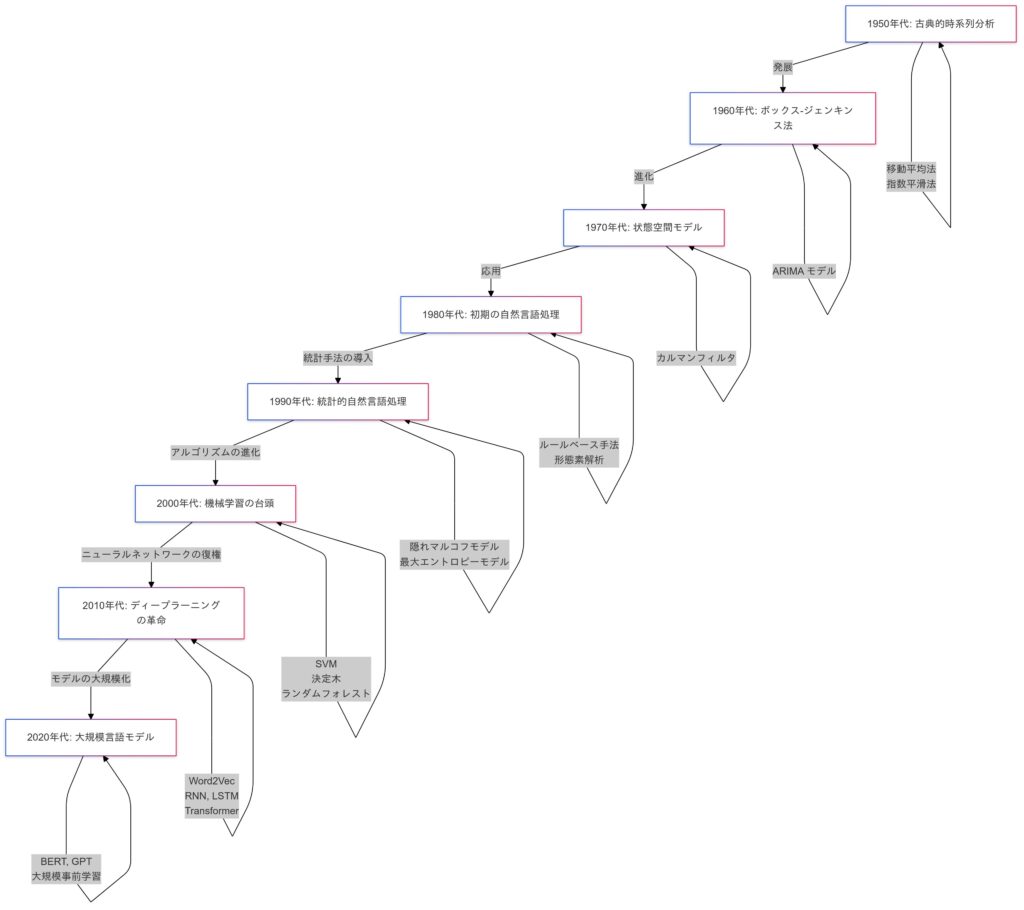

時系列データを扱うアルゴリズムの歴史は、ディープラーニング以前から続く進化の軌跡を持っていますが、ディープラーニングの登場により、新たな可能性が開かれました。前回のブログでは、この流れの中でも特に重要なRNN、LSTM、GRUといった時系列モデルに焦点を当て、これらが時系列データ解析にどのような革新をもたらしたかを学びました。

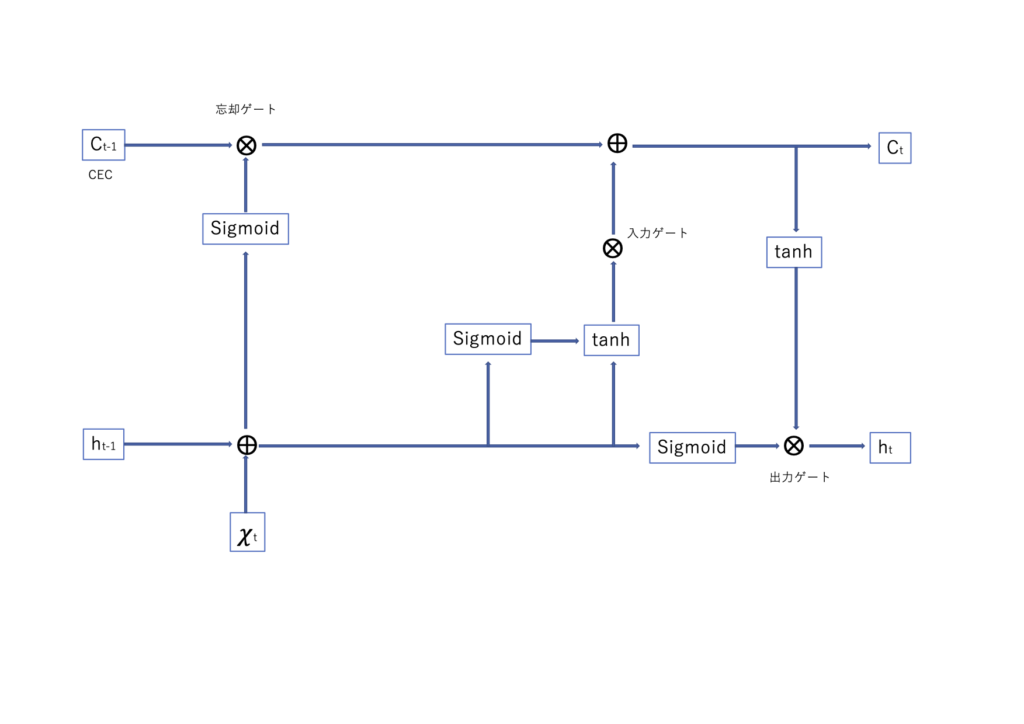

RNNは、時系列データの連続性を学ぶ初期のモデルとして登場しましたが、長期依存の学習では勾配消失問題に直面しました。この課題を克服したLSTM(長短期記憶)は、ゲート機構を通じて重要な情報を保持し、金融予測や異常検知で成功を収めました。さらに、LSTMを簡略化したGRU(ゲート付きリカレントユニット)は計算効率を高め、リアルタイム解析にも適用されました。

これらの進化は、次に登場するTransformerモデルへの橋渡しとなります。

時系列データに関するアルゴリズムの発展

自然言語処理におけるTransformerモデルの登場と進化

自然言語処理の進化の振り返り

Word2Vec

- 目的

- Word2Vec(2013年)は、単語をベクトル化し、単語間の意味的な関係を効率的に捉える手法です。Skip-gramやCBOWを活用して計算効率を高め、大規模データにも対応可能で、自然言語処理タスクの性能向上に貢献しました。

- 課題

- Word2Vecの課題は、短い文脈内の関係性は捉えられるものの、長い文章での単語間の長期依存関係や文書全体の意味を把握するのが難しい点です。また、文脈情報が固定されているため、同じ単語の異なる意味を表現するには不十分でした。

| 用途 | 説明 | 具体例 |

|---|---|---|

| 単語の類似性や関連性の計算 | 単語を高次元ベクトル空間に埋め込むことで、類似性(コサイン類似度など)を計算し、関連性の高い単語を特定するのに利用。 | 「王」-「男性」+「女性」=「女王」のようなベクトル演算。 |

| 検索エンジンや情報検索 | 検索クエリと文書間の意味的な類似性を向上させるために使用。 | Synonym Expansion(類義語展開)による検索精度の向上。 |

| 自然言語処理(NLP)タスク | テキスト分類(スパム検知、感情分析)、翻訳モデル、質問応答システムなどで利用。 | メールのスパム検知、感情分析、翻訳システム、質問応答システム。 |

| レコメンデーションシステム | ユーザーの好みや行動履歴を単語と見立て、類似した商品やコンテンツを推薦。 | 映画や音楽の推薦アルゴリズム。 |

| 知識発見 | 文書間の隠れた関係性やテーマを分析し、トピックモデリングや知識グラフの構築に役立つ。 | トピックモデリング、知識グラフの構築。 |

| 音声認識や画像キャプション生成 | 単語の意味をベクトル表現として用いることで、音声や画像に関連するテキスト生成の精度向上に貢献。 | 音声認識システム、画像キャプション生成。 |

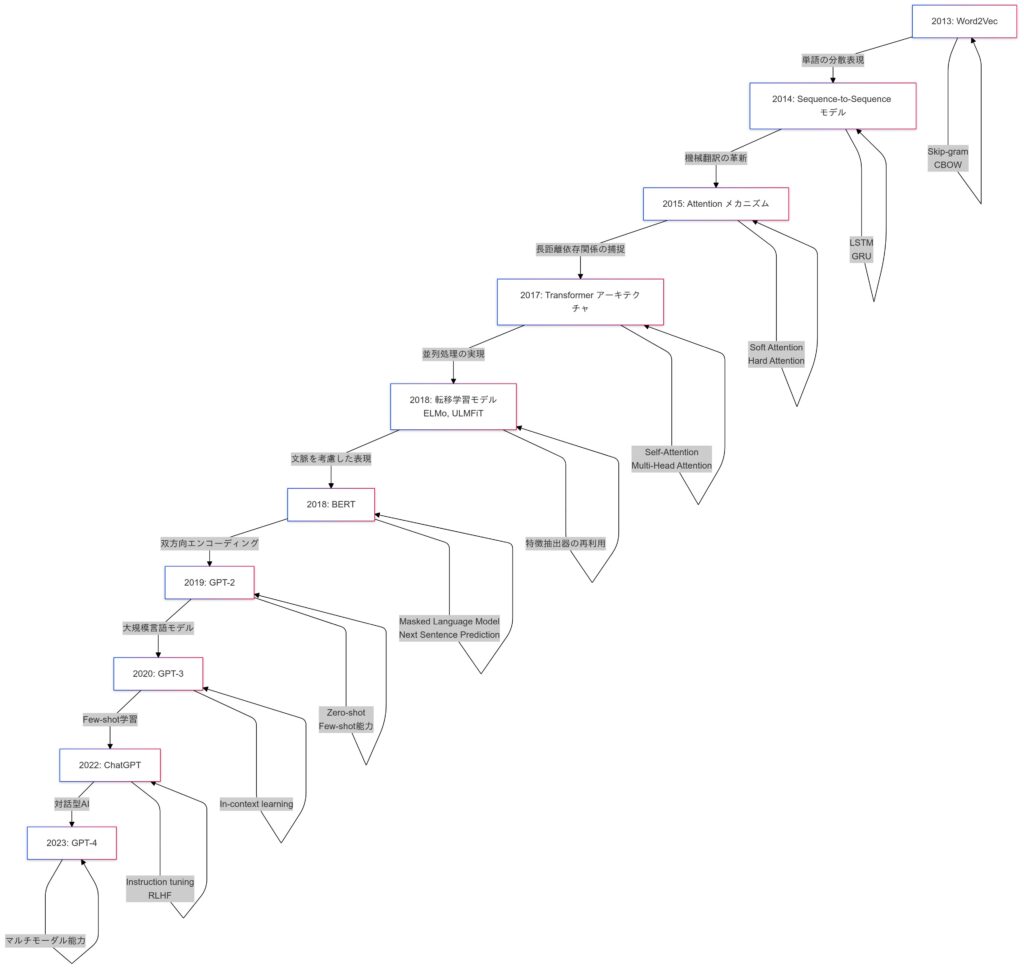

RNNとLSTMの役割

- 自然言語処理の初期では、RNNや改良版のLSTMが主力モデルとして活躍しました。LSTMはゲート機構により長期依存関係を学習し、機械翻訳やテキスト分類などで高い効果を発揮しましたが、逐次処理による計算コストの高さや長い文脈を完全には捉えきれない課題がありました。LSTMの改良版であるGRUも同様の課題があります。

- 長期依存関係の限界

- 長い文では、離れた単語間の関係を正確に学習するのが難しいという課題があります。

- 計算効率の問題

- 逐次処理が必要なため、並列計算が難しく、大量のデータ処理に時間がかかる課題があります。

Transformerモデルが出てくるまでの自然言語処理を行う場合においてはこのRNNとLSTM、GRUなどがよく使われていました。

LSTMモデルのイメージ

GRUのイメージ

Seq2Seqモデル

- Seq2Seqモデルは、Encoder-Decoder構造を活用し、文全体をエンコードして別の形式にデコードすることで、自然言語タスクの性能を向上させました。例えば、機械翻訳では入力文をエンコードし、ターゲット言語の文を生成します。

- 長文の情報損失

- Encoderが文全体を固定長のコンテキストベクトルに圧縮するため、長文では重要な情報が失われやすい課題がありました。

- 逐次処理のボトルネック

- 処理速度が遅く、時間効率が悪いという課題が残っていました。

- 長文の情報損失

Seq2Seqの動作イメージ

Seq2Seqの主な適用例

| 適用例 | 説明 | 具体例 |

|---|---|---|

| 機械翻訳(Machine Translation) | 入力文をエンコーダでベクトルに圧縮し、その情報を元にターゲット言語の文をデコードする。 | 英語の文章を日本語に翻訳する。 |

| チャットボット | ユーザーの入力メッセージをエンコードし、それに適した返信を生成する。 | 質問に対する回答の生成。 |

| 自動要約 | 長い文書を短い要約に変換。 | ニュース記事をコンパクトに要約する。 |

| メールの自動返信 | 入力されたメール本文を解析し、適切な返信文を生成する。 | 自動返信メールの生成。 |

Seq2Seqが用いられた理由

| 理由 | 説明 |

|---|---|

| 柔軟性 | 入力系列と出力系列の長さが異なっても対応可能。 |

| 汎用性 | 時系列データ全般に適用できる。 |

| ソフトマックス層の使用 | 次に最も確率が高い単語を選択することで、自然な文生成を実現。 |

LSTMやGRUは、Seq2Seqモデルのエンコーダ・デコーダアーキテクチャによく用いられ、特に長期依存関係を効率的に学習できる点で優れています。この特性により、機械翻訳などのタスクで入力系列をエンコードし、出力系列をデコードする際、従来のRNNよりも高い性能を発揮しました。

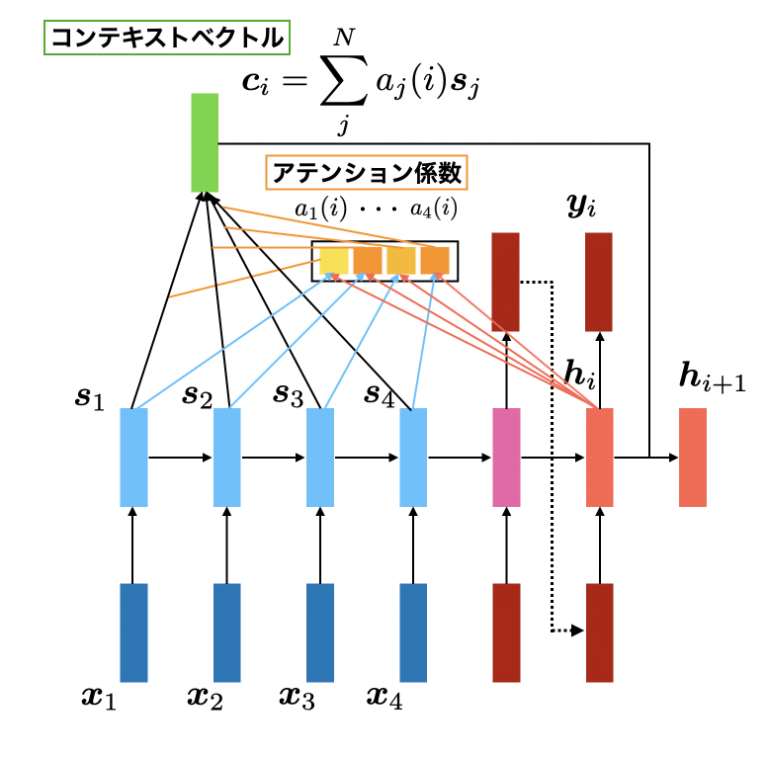

Attention機構の導入

Attention機構は、文中の単語間の重要度を動的に計算し、関連性の高い情報に焦点を当てる仕組みです。たとえば「彼女は美しい絵を描いて、それを友人に見せた」という文では、「それ」と「美しい絵」の関連性を捉え、文脈を理解します。この仕組みは人間が情報に注意を向ける動きやフラッシュバック現象に似ており、長文や複雑な文脈における依存関係を効率的に処理します。

LSTMの課題を克服したモデル

- Attentionは従来のLSTMやRNNが持つ逐次処理の限界を克服し、全単語間の関連性を一度に計算することで、並列処理による高い計算効率と長期依存関係への対応を可能にしました。この特性から、BERTやGPTなどの大規模モデルに採用され、NLPの分野で革新をもたらしています。

LSTMとAttentionを組み合せ

- Attention機構をLSTMの出力に適用することで、重要なタイムステップに焦点を当て、長期依存関係を効果的に捉えられるようになります。また、どの部分に注目しているかを可視化できるため、モデルの解釈性が向上します。これにより、特に時系列データの予測精度が向上することが期待されます。

Attention機構が用いられた経緯

- Attention機構は、入力データの重要部分に焦点を当てる技術で、関連性に基づき重みを動的に調整します。当初はseq2seqモデルの改良案として提案され、入力と出力の関係性を自動学習・可視化できる利点を持ちます。その後、Transformerモデルに発展し、自然言語処理や長期依存関係の処理で広く活用されています。このシンプルかつ効果的な仕組みは、深層学習の革新的な技術として標準化されています。

Attention機構の特徴

| 理由 | 説明 |

|---|---|

| 動的な情報抽出 | 文中の重要な単語に焦点を当てて処理を行うため、重要な情報を効率よく捉えます。 |

| 長文処理の改善 | 長文でも、重要な情報を失うことなく処理できるため、翻訳精度や文脈の理解が向上します。 |

| スケーラビリティ | 大規模データや多言語翻訳タスクにも適用可能で、特にGoogle Translateのような実用的なシステムで大きな成功を収めました。 |

数式

- スコア計算

- クエリ $q$ とキー $k$ の関連度を計算します。

$$\text{Score}(q, k) = q^\top k$$

- 重みの正規化

- スコアをソフトマックス関数で正規化し、重み $α$ を計算します。

$$\alpha_i = \frac{\exp(\text{Score}(q, k_i))}{\sum_j \exp(\text{Score}(q, k_j))}$$

- コンテキストベクトルの計算

- 重み付けした値 $v$ を合計して、コンテキストベクトル $c$ を計算します。

$$c = \sum_i \alpha_i v_i$$

Attentionの課題

| デメリット | 説明 |

|---|---|

| 計算コストの増加 | スコア計算やソフトマックスで計算コストが高くなる。 |

| メモリ消費 | キーと値の行列が大きい場合、メモリの消費量が増大する。 |

| 並列処理の制限 | 処理に依存関係がある場合、並列処理が難しいことがある。 |

Attentionの実装例)

import torch

import torch.nn as nn

import torch.nn.functional as F

# Attentionクラスの定義

class Attention(nn.Module):

def __init__(self, hidden_dim):

super(Attention, self).__init__()

# スケールファクターの計算(隠れ層次元の平方根)

self.scale = hidden_dim ** 0.5

def forward(self, query, key, value):

# スコア計算: queryとkeyの転置行列の内積を計算し、スケールファクターで割る

scores = torch.matmul(query, key.transpose(-2, -1)) / self.scale

# ソフトマックスで重みを計算: スコアをソフトマックス関数に通して重みを計算

weights = F.softmax(scores, dim=-1)

# 重み付けされた値を計算: 重みをvalueに掛けてコンテキストベクトルを計算

context = torch.matmul(weights, value)

return context, weights

# 入力テンソルの例

query = torch.rand(1, 5, 64) # (バッチサイズ, シーケンス長, 隠れ層次元)

key = torch.rand(1, 5, 64)

value = torch.rand(1, 5, 64)

# Attentionクラスのインスタンス化

attention = Attention(hidden_dim=64)

# フォワードパスの実行

context, weights = attention(query, key, value)

# 結果の出力

print("Context shape:", context.shape)

print("Weights shape:", weights.shape)Context shape: torch.Size([1, 5, 64]) # (バッチサイズ, シーケンス長, シーケンス長)

Weights shape: torch.Size([1, 5, 5]) # (バッチサイズ, シーケンス長, シーケンス長)- コンテキストベクトルは、重み付けされたバリューテンソルを加重平均して得られるもので、形状は (バッチサイズ, シーケンス長, 隠れ層次元) です。

- 重みは、クエリとキーのスコアにソフトマックス関数を適用して計算され、形状は (バッチサイズ, シーケンス長, シーケンス長) になります。

適用例

| 応用例 | 説明 |

|---|---|

| 機械翻訳 | Google Translateなどの翻訳モデルでは、Attentionを活用することで翻訳精度が大幅に向上しました。 |

| テキスト要約 | Attentionを利用して重要な文脈を抽出し、要約を生成。 |

| 画像キャプション生成 | 画像の特徴にAttentionを適用し、キャプション生成に利用。 |

論文

『Neural Machine Translation by Jointly Learning to Align and Translate』

- ソフトアライメント機構の導入

- ソフトアライメント機構は、翻訳時にソース文全体を固定長ベクトルに圧縮するのではなく、各ターゲット単語に関連する部分を動的に選択する手法です。双方向RNNで生成した各単語の「アノテーション」に重み付けを行い、必要な情報に焦点を当てたコンテキストベクトルを計算します。これにより、長文でも重要な情報を抽出しながら翻訳精度を大幅に向上。従来のモデルが抱える長文での性能劣化を克服し、人間の直感に近い翻訳を可能にした革新的な技術です。

- 長文翻訳での高い性能

- RNNsearchは、従来のモデルが長文で情報を保持しきれず性能が劣化する課題を克服し、安定した翻訳精度を実現しました。ソフトアライメント機構により、翻訳時に関連情報を動的に抽出することで、BLEUスコアで従来のRNNencdecを上回り、フレーズベース翻訳システム(Moses)に匹敵する精度を達成。特に長文での翻訳性能向上が顕著で、実用性が飛躍的に向上した点が大きな特徴です。

- Attention機構の基本的な概念の導き

- この論文は、RNNsearchを用いてAttention機構の原型となるソフトアライメント機構を提案したものであり、Attentionの基本概念を導いた重要な研究と位置付けられます。そのため、現在の多くのNLPアルゴリズムにおけるAttention機構の源流と言って差し支えありません。

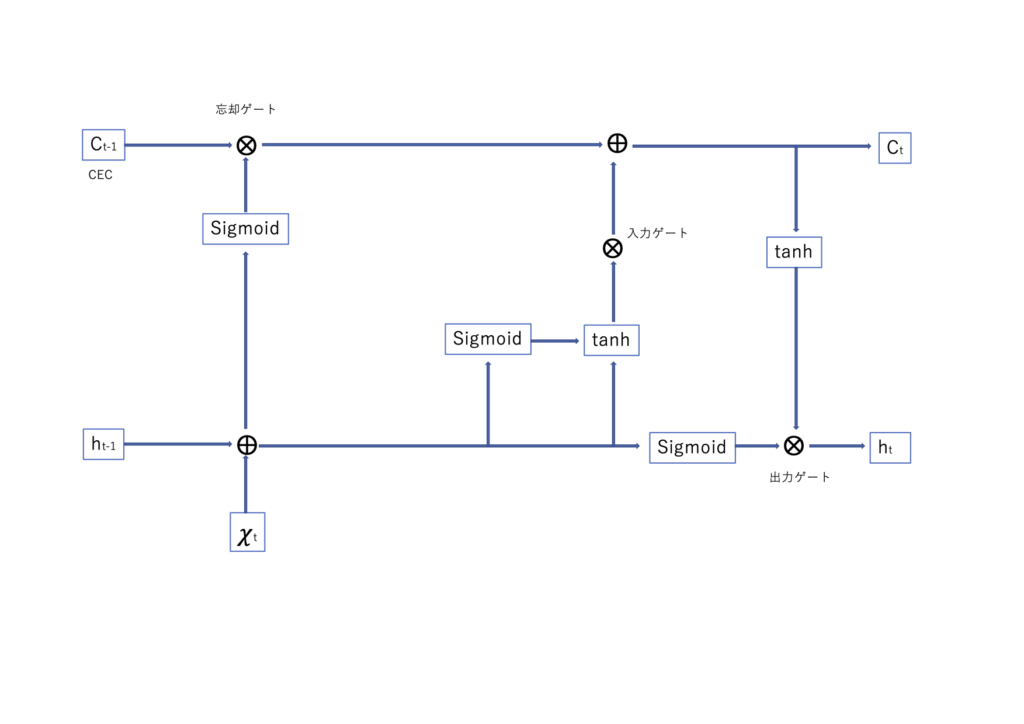

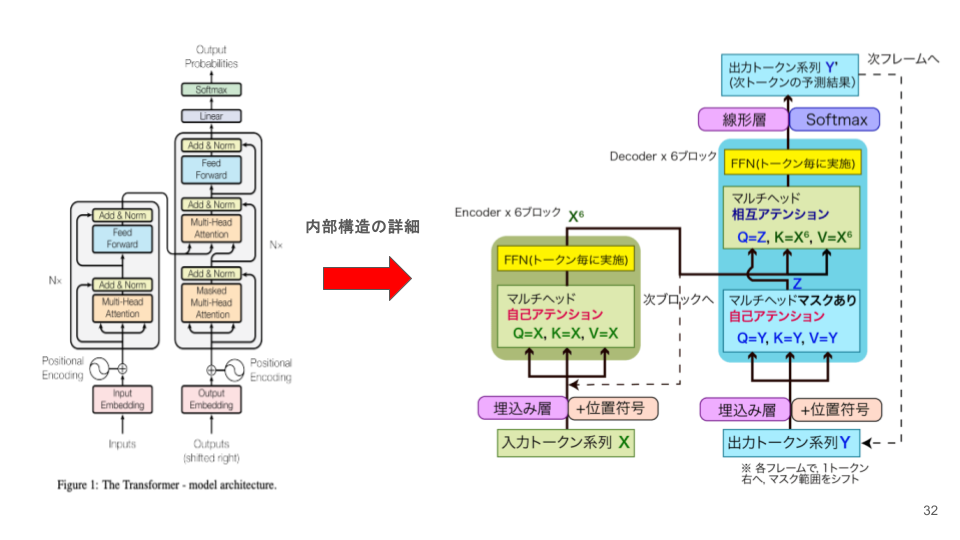

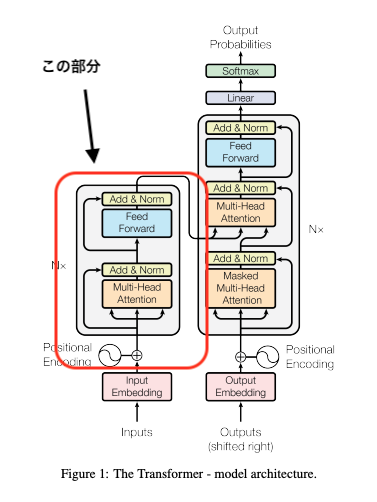

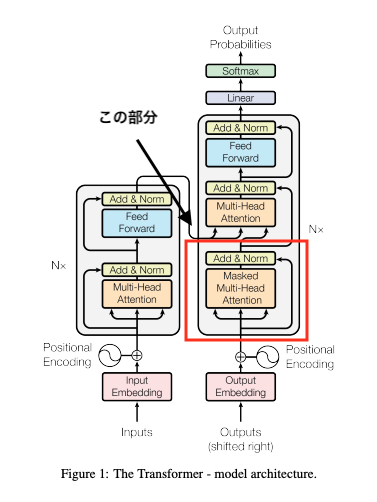

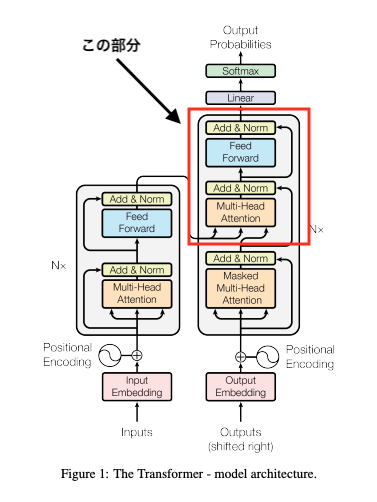

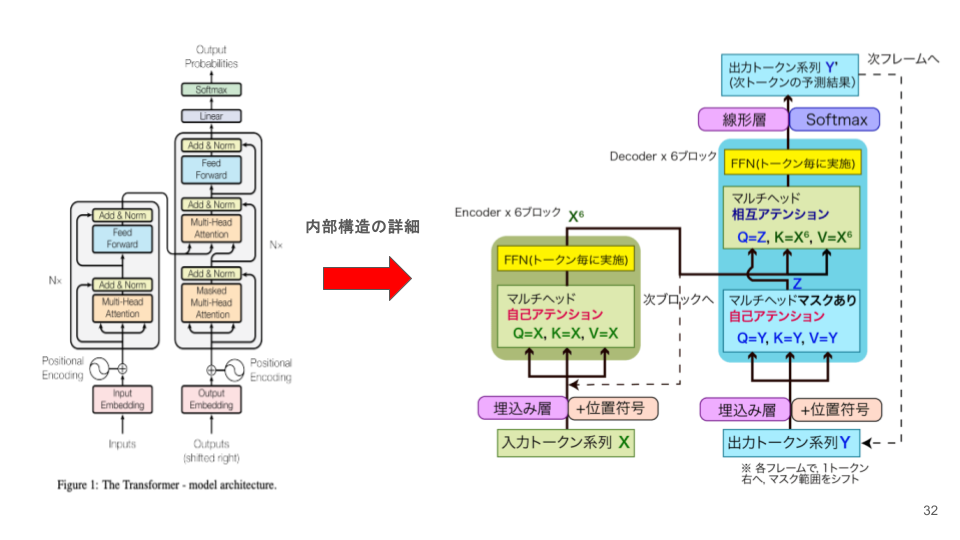

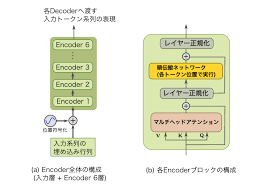

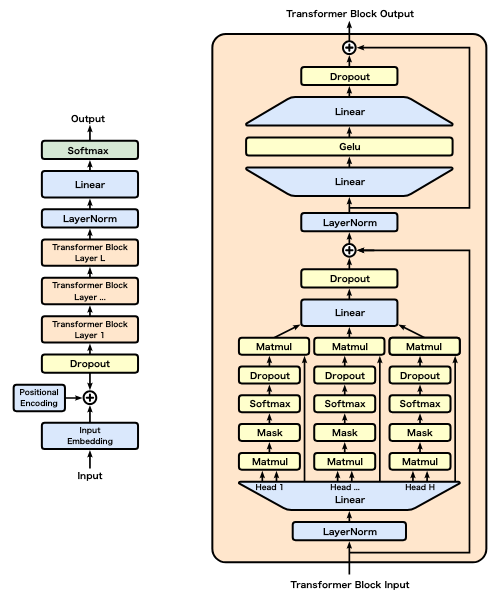

Transformerの基本構造と仕組み

Transformerモデルは、2017年にVaswaniらが提案したNLPの革新的技術で、Self-Attentionと並列処理により、RNNの逐次処理を不要にしました。これにより、長文や複雑な文脈を効率的に処理し、機械翻訳や質問応答など多くのタスクで高い性能を発揮。特に、BERTやGPTといった大規模モデルの基盤技術となり、NLPの発展を大きく後押ししています。また、画像処理やマルチモーダルタスクにも応用されるなど、幅広い分野で活用されています。

特徴:

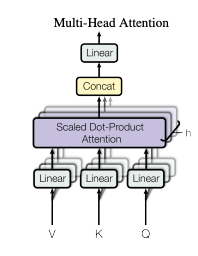

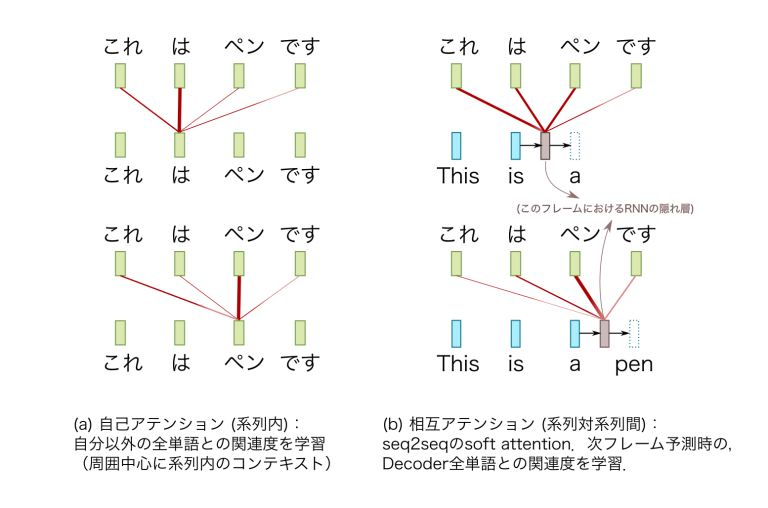

上のTransformerを構成するイメージ図からもわかりますが、Transformerは3種類のAttentionを組み合わせて高い性能を実現します。

- Self-Attention

- Self-Attentionは同一系列内のトークン間の関連性を計算し、文脈を学習します。

- Cross-Attention

- Cross-Attentionはエンコーダの出力とデコーダのトークン間の関連性を計算し、次のトークン生成を補助します。

- Multi-Head Attention

- Multi-Head Attentionは複数のヘッドでこれらの計算を並列化し、多様な特徴を効率的に学習します。

| Attentionの 種類 | 定義 | 用途 | 使用場所 | 具体例 |

|---|---|---|---|---|

| Self-Attention | 同一系列内の関連性を計算 | 文脈情報を学習 | エンコーダとデコーダ内部 | 文中の単語が他の単語との関係を学び、文全体の意味を理解する。 |

| Cross-Attention | 異なる系列間の関連性を計算 | エンコーダ出力を参照し次のトークンを生成 | デコーダ内部 | エンコーダ出力(入力文)を元に、デコーダ(出力文)が次の単語を生成。 |

| Multi-Head Attention | 複数のAttentionヘッドを並列実行し多様な関係を学習 | 各ヘッドが異なる特徴を学習 | Self-AttentionとCross-Attentionに適用 | 1つのAttentionを複数に分け、異なる角度でトークン間の関連性を計算。 |

次はこの3種類のAttentionの仕組みを解説します。

Self-Attentionの仕組み(エンコーダー)

エンコーダーの自己アテンション(Self-Attention)は、文中の各単語が他の単語との関連性を動的に計算し、文全体の文脈を考慮した特徴を持つように更新する仕組みです。具体的には、各単語がQuery(検索)、Key(比較対象)、Value(情報)として表現され、QueryとKeyの関連度を計算後、ソフトマックス関数で重み付けを行い、Valueに適用します。このプロセスで、単語間の文脈情報を効果的に学習し、高精度な自然言語処理が可能になります。

- Query(クエリ): 各単語の情報を他の単語と比較する際の「検索」の役割。

- Key(キー): 他の単語が「検索される側」の役割を果たす情報。

- Value(値): 実際に重み付けして特徴表現を更新する際の基礎情報。

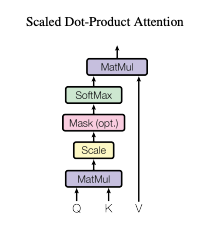

Scaled Dot-Product Attention

- Scaled Dot-Product Attentionは、Self-Attentionの具体的な計算アルゴリズムであり、入力シーケンス内の単語間の関連性を動的に計算する仕組みです。Query(クエリ)とKey(キー)の内積で類似度スコアを求め、それをスケール化しソフトマックス関数で正規化します。これに基づき、Value(バリュー)に重み付けを行い、重要な情報を抽出します。Self-Attention全体の中で、この計算プロセスが中核を担い、単語間の文脈情報を効率的に学習します。

Multi-Head Attention

- Multi-Head Attentionは、Attention機構を複数の視点で同時に実行する手法で、情報の多様性を向上させます。入力を複数のヘッドに分割し、それぞれが異なる関連性を学習。これにより、異なる特徴や文脈を同時に捉えることが可能です。各ヘッドの出力を統合することで、短期・長期依存関係を包括的に学習します。この技術はTransformerモデルの核となり、機械翻訳や質問応答など多くのNLPタスクで高い性能を発揮しています。

Single-Head Attention

- Single-Head Attentionは、Multi-Head Attentionを構成する基本的な要素です。具体的には、各単語に対して他のすべての単語との関連度を計算し、重要な情報に焦点を当てる仕組みです。

Position Encoding

- Position Encodingは、Transformerモデルで単語の順序情報を提供する技術です。正弦波と余弦波を利用して位置ベクトルを生成し、埋め込みベクトルに加算することで、Attention機構だけでは捉えられない単語の順序を補完します。この仕組みにより、モデルは文脈の順序関係を理解しながら、効率的な並列計算を維持できます。計算効率が高く、BERTやGPTなど多くのモデルで活用され、自然言語処理の基盤技術となっています。

数式

- Self-Attentionの計算

- Self-Attentionは、クエリ $Q$、キー $K$、値 $V$ を用いて以下の計算を行います。

$$\text{Self-Attention(Q, K, V)} = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V$$

$Q,K,V$:クエリ、キー、値行列(入力データから線形変換)。$d_k$:キーの次元数(スケーリング因子)

- Multi-Head Attentionの計算

- Single-Head Attentionを複数回並列計算し、それらを結合する仕組みです。

$$\text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \dots, \text{head}_h)W^O$$

- 各ヘッド

$$\text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V)$$

- Position Encodingの計算

- 単語の順序情報を加えるため、以下の形式で位置情報を埋め込みます。

$$PE_{(pos, 2i)} = \sin\left(\frac{pos}{10000^{\frac{2i}{d_\text{model}}}}\right), \quad

PE_{(pos, 2i+1)} = \cos\left(\frac{pos}{10000^{\frac{2i}{d_\text{model}}}}\right)$$

Self-Attention(エンコーダー部分)の実装)

- この部分はエンコーダー部分のマスクなしのSelf-Attentionの実装です。

import torch

import torch.nn as nn

import torch.nn.functional as F

class MultiHeadSelfAttention(nn.Module):

def __init__(self, embed_size, num_heads):

super(MultiHeadSelfAttention, self).__init__()

assert embed_size % num_heads == 0, "Embedding size must be divisible by number of heads"

self.head_dim = embed_size // num_heads

self.num_heads = num_heads

self.embed_size = embed_size

self.values = nn.Linear(embed_size, embed_size, bias=False)

self.keys = nn.Linear(embed_size, embed_size, bias=False)

self.queries = nn.Linear(embed_size, embed_size, bias=False)

self.fc_out = nn.Linear(embed_size, embed_size)

def forward(self, values, keys, queries, mask=None):

N = queries.shape[0] # Batch size

value_len, key_len, query_len = values.shape[1], keys.shape[1], queries.shape[1]

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# Split embedding into self.num_heads pieces

values = values.view(N, value_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

keys = keys.view(N, key_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

queries = queries.view(N, query_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

# Scaled dot-product attention

scores = torch.matmul(queries, keys.permute(0, 1, 3, 2)) / (self.head_dim ** 0.5)

if mask is not None:

scores = scores.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(scores, dim=-1)

out = torch.matmul(attention, values)

out = out.permute(0, 2, 1, 3).contiguous()

out = out.view(N, query_len, self.embed_size)

return self.fc_out(out)Self-Attentionの仕組み(デコーダー)

基本的には先ほど説明したSelf-Attentionと同等の役割を持ちますが、役割が違う部分もありますのでその点について言及しておきます。

役割:

マスク付きSelf-Attentionは、ターゲットシーケンス生成時に過去のトークンのみを参照し、未来の情報を遮断する仕組みです。Attentionスコア計算時に未生成のトークンに対応する部分をマスク(無視)し、文脈に沿った自然な生成を学習します。この処理により、文法的整合性や文脈情報が正確に捉えられ、逐次的な生成プロセスに忠実なモデル学習が可能になります。

- Mask Multi-Head Attentionの役割

- Maskは主にデコーダー側のMulti-Head Attentionに適用され、自己アテンション(Self-Attention)の一部として機能します。具体的には、ターゲットシーケンス生成時に未生成の未来トークンを参照しないようにするため、マスク処理を使用します。この処理では、ソフトマックス計算時に現在のトークン以降の情報を遮断します。これにより、過去の文脈情報のみを活用しながら、次のトークンを予測することが可能になります。この仕組みは、翻訳やテキスト生成タスクで情報漏洩を防ぐ重要な役割を果たします。

仕組み:

エンコーダーと同様に、Query、Key、Valueはターゲットシーケンスから生成されます。ただし、マスク処理を用いて、現在のトークン以降の未来の情報を遮断し、過去の情報だけを参照できるようにします。

Self-Attention(デーコーダー部分)の実装)

- この部分はデコーダー部分のマスクありのSelf-Attentionの実装です。

import torch

import torch.nn as nn

import torch.nn.functional as F

class MultiHeadSelfAttention(nn.Module):

def __init__(self, embed_size, num_heads):

super(MultiHeadSelfAttention, self).__init__()

assert embed_size % num_heads == 0, "Embedding size must be divisible by number of heads"

self.head_dim = embed_size // num_heads

self.num_heads = num_heads

self.embed_size = embed_size

self.values = nn.Linear(embed_size, embed_size, bias=False)

self.keys = nn.Linear(embed_size, embed_size, bias=False)

self.queries = nn.Linear(embed_size, embed_size, bias=False)

self.fc_out = nn.Linear(embed_size, embed_size)

def forward(self, values, keys, queries, mask=None):

N = queries.shape[0] # Batch size

value_len, key_len, query_len = values.shape[1], keys.shape[1], queries.shape[1]

# Linear transformation to obtain Query, Key, and Value matrices

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# Split embedding into self.num_heads pieces

values = values.view(N, value_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

keys = keys.view(N, key_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

queries = queries.view(N, query_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

# Scaled dot-product attention

scores = torch.matmul(queries, keys.permute(0, 1, 3, 2)) / (self.head_dim ** 0.5)

# Apply mask if provided

if mask is not None:

# Mask shape should match scores shape: (batch_size, num_heads, query_len, key_len)

scores = scores.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(scores, dim=-1)

# Compute weighted sum of values

out = torch.matmul(attention, values)

# Reshape back to original dimensions

out = out.permute(0, 2, 1, 3).contiguous()

out = out.view(N, query_len, self.embed_size)

# Final linear layer

return self.fc_out(out)

# Example usage

def generate_subsequent_mask(size):

""" Generate a mask to prevent attention to future positions. """

mask = torch.tril(torch.ones(size, size)).unsqueeze(0).unsqueeze(0) # Shape: (1, 1, size, size)

return mask

# Define parameters

embed_size = 128

num_heads = 8

seq_len = 10

batch_size = 2

# Create dummy inputs

x = torch.rand(batch_size, seq_len, embed_size) # Input tensor

# Initialize model

attention = MultiHeadSelfAttention(embed_size, num_heads)

# Generate mask

mask = generate_subsequent_mask(seq_len)

# Forward pass

output = attention(x, x, x, mask)

print("Output shape:", output.shape)Output shape: torch.Size([2, 10, 128])Cross-Attentionの仕組み(デコーダー)

役割:

相互アテンション(Cross-Attention)は、エンコーダ-デコーダアーキテクチャで、エンコーダの出力(ソース系列)とデコーダの入力(ターゲット系列)との関連性を計算する仕組みです。デコーダがエンコーダの情報を基に、次に生成するトークンを適切に判断するための重要なプロセスです。

特徴:

Self-Attentionが同一系列内の関連性を計算するのに対し、Cross-Attention(相互アテンション)は異なる系列間の関係性を学習します。主にTransformerのデコーダで使われ、入力系列の中で出力系列の生成に最も関連する情報を動的に特定する役割を担います。

具体的な仕組み

相互アテンションは、Scaled Dot-Product Attentionを活用して以下のプロセスを実行します。先ほどSelf-Attention(エンコーダー部分)で説明した補足として相互アテンションでは以下の役割があります。

- 入力と出力

- 相互アテンションでは、エンコーダの出力をKeyとValue、デコーダの中間表現をQueryとして利用して関連性を計算します。

- 計算プロセス

- Query, Key, Valueの生成

- デコーダの中間表現をQueryに変換し、エンコーダの出力からKeyとValueを生成して関連性を計算します。

- Query, Key, Valueの生成

- 関連度の計算

- 関連度の計算では、QueryとKeyの内積を求め、Keyの次元数の平方根でスケーリングします。その後、ソフトマックス関数で正規化し、どのエンコーダ出力が重要かを確率分布として判断します。

- コンテキストベクトルの生成

- コンテキストベクトルは、重み付けされたValueを加重平均して生成されます。このベクトルは、デコーダの次のステップで使用され、出力生成に役立ちます。

数式

- Cross-Attentionでは、クエリ $Q$ がターゲット系列に依存し、キー $K$ と値 $V$ が入力系列に依存します。この数式により、ターゲット側の単語が、ソース側のどの単語に注目すべきかを計算します。

$$\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^\top}{\sqrt{d_k}}\right)V$$

- $Q$:デコーダの出力から計算されるクエリ行列

- $K$、$V$:エンコーダの出力から計算されるキーと値の行列

- $d_k$:キーの次元数(スケーリングのため)

相互アテンションの効果

| 効果 | 説明 |

|---|---|

| 重要情報の抽出 | 入力系列(エンコーダの出力)の中から、出力に最も関連する部分に注意を集中し、無駄のない情報利用を可能にします。 |

| 文脈を反映した生成 | デコーダがエンコーダ出力全体を参照しながら、文脈に応じて動的にトークンを生成します。 |

| 効率性の向上 | ソフトマックス関数で関連度を確率分布に変換し、スケーリングにより安定した計算を実現します。複数トークン間の適切な情報選択を効率的に行えます。 |

Cross-Attentionの実装)

- Self-Attentionとの実装の違いは??

- Self-Attentionは、シーケンス内の各位置が他の位置にどれだけ注意を払うべきかを計算する仕組みで、エンコーダーやデコーダーの自己注意層で使用されます。

- Cross-Attentionは、デコーダーがエンコーダーの出力に基づいて注意を払う仕組みで、エンコーダーの出力(キーとバリュー)とデコーダーの入力(クエリ)を利用します。これにより、入力と出力間の関連性を動的に学習します。

- マスクの使用が可能

- またCross-Attentionは図解には記載されていませんが、マスクを適用して特定の位置への注意を防ぐことも可能です。これにより、モデルの性能が向上し、不要な注意を防ぐことができます

import torch

import torch.nn as nn

class CrossAttention(nn.Module):

def __init__(self, embed_size, num_heads):

super(CrossAttention, self).__init__()

assert embed_size % num_heads == 0, "Embedding size must be divisible by number of heads"

self.num_heads = num_heads

self.head_dim = embed_size // num_heads

self.scale = self.head_dim ** 0.5

self.query = nn.Linear(embed_size, embed_size)

self.key = nn.Linear(embed_size, embed_size)

self.value = nn.Linear(embed_size, embed_size)

self.fc_out = nn.Linear(embed_size, embed_size)

self.softmax = nn.Softmax(dim=-1)

def forward(self, query_input, key_input, value_input, mask=None):

N = query_input.shape[0]

# Linear projections

Q = self.query(query_input)

K = self.key(key_input)

V = self.value(value_input)

# Split the embedding into self.num_heads different pieces

Q = Q.view(N, -1, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

K = K.view(N, -1, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

V = V.view(N, -1, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

# Scaled dot-product attention

scores = torch.matmul(Q, K.transpose(-2, -1)) / self.scale

if mask is not None:

scores = scores.masked_fill(mask == 0, float("-1e20"))

attention_weights = self.softmax(scores)

# Weighted sum of values

output = torch.matmul(attention_weights, V)

output = output.permute(0, 2, 1, 3).contiguous()

output = output.view(N, -1, self.num_heads * self.head_dim)

# Final linear layer

output = self.fc_out(output)

return output, attention_weights

# テスト用データ

embed_size = 64

num_heads = 8

batch_size = 8

query_len = 5

key_value_len = 10

query = torch.rand((batch_size, query_len, embed_size))

key = torch.rand((batch_size, key_value_len, embed_size))

value = torch.rand((batch_size, key_value_len, embed_size))

# マスクの生成(例としてランダムなマスクを使用)

mask = torch.randint(0, 2, (batch_size, 1, query_len, key_value_len)).bool()

cross_attention = CrossAttention(embed_size, num_heads)

# output, attention_weights = cross_attention(query, key, value)

output, attention_weights = cross_attention(query, key, value, mask)

print("Output shape:", output.shape)

print("Attention Weights shape:", attention_weights.shape)Output shape: torch.Size([8, 5, 64])

Attention Weights shape: torch.Size([8, 8, 5, 10])自己アテンション(Self-Attention) と 相互アテンション(Cross-Attention)の違い

- 自己アテンションは同一系列内で文脈を学習し、情報を豊かにします。一方、相互アテンションは異なる系列間での関連性を学習し、翻訳などで次の単語を生成するための基盤となります。それぞれの役割が明確であり、Transformerモデルのエンコーダ-デコーダ構造の中心的な役割を担っています。

自己アテンション(Self-Attention)と相互アテンション(Cross-Attention, 相互注意)の違い

| 項目 | Self-Attention | Cross-Attention |

|---|---|---|

| 処理対象 | 同一系列内のトークン間(Query, Key, Value)の関係を計算 | 異なる系列間(エンコーダ出力(Key, Value)とデコーダのQuery)の関係を計算 |

| 使用箇所 | 主にエンコーダで使用 | 主にデコーダで使用 |

| 目的 | 文脈情報の学習(系列内の文脈的な情報を強化する) | 入力と出力間の関連性を学習(入力系列(エンコーダ出力)に基づく出力トークンの生成)し、出力を生成する |

| 計算の基盤 | Scaled Dot-Product Attentionを用いてトークン間の関連性を計算 | 同じ計算手法を用いて異なる系列間の関連性を計算 |

具体的な例

Transformerの利点と課題

| 利点 | 課題 |

|---|---|

| 並列処理:RNNの逐次処理に依存せず、計算が高速。 | 計算資源の消費:Attentionの全単語間計算が必要で、大規模データではメモリ負荷が高い。 |

| 長文対応:文中の全単語間の関係を効率的に計算し、長文にも強い。 | 順序情報の課題:Position Encodingが必要で、順序依存タスクでは設計が重要。 |

| 汎用性:翻訳、要約、質問応答、画像処理など、幅広いタスクで応用可能。 | データ量依存:高い性能を発揮するには大量のデータが必要。 |

Transformerの全体を構成するコードの実装例)

先ほど説明した3種類のAttention(MultiHeadAttention, Self-Attention, Cross-Attention)の実装を行います。

ライブラリのインポート

import torch

import torch.nn as nn

import torch.nn.functional as FMultiHeadAttentionクラスの定義

class MultiHeadAttention(nn.Module):

def __init__(self, embed_size, num_heads):

super(MultiHeadAttention, self).__init__()

assert embed_size % num_heads == 0, "Embedding size must be divisible by number of heads"

self.head_dim = embed_size // num_heads

self.num_heads = num_heads

self.embed_size = embed_size

self.values = nn.Linear(embed_size, embed_size, bias=False)

self.keys = nn.Linear(embed_size, embed_size, bias=False)

self.queries = nn.Linear(embed_size, embed_size, bias=False)

self.fc_out = nn.Linear(embed_size, embed_size)フォワードパスの定義

def forward(self, values, keys, queries, mask=None):

N = queries.shape[0] # バッチサイズ

value_len, key_len, query_len = values.shape[1], keys.shape[1], queries.shape[1]

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# 埋め込みをself.num_heads個に分割

values = values.view(N, value_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

keys = keys.view(N, key_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

queries = queries.view(N, query_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

# スケールド・ドットプロダクト・アテンション

scores = torch.matmul(queries, keys.permute(0, 1, 3, 2)) / (self.head_dim ** 0.5)

if mask is not None:

scores = scores.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(scores, dim=-1)

out = torch.matmul(attention, values)

out = out.permute(0, 2, 1, 3).contiguous()

out = out.view(N, query_len, self.embed_size)

return self.fc_out(out)TransformerBlockクラスの定義

- これはSelf-Attentionの部分の実装を行っています。また、正規化層、ドロップアウト層などの実装も同時に行っています。

class TransformerBlock(nn.Module):

def __init__(self, embed_size, num_heads, dropout, forward_expansion):

super(TransformerBlock, self).__init__()

self.attention = MultiHeadAttention(embed_size, num_heads)

self.norm1 = nn.LayerNorm(embed_size)

self.norm2 = nn.LayerNorm(embed_size)

self.feed_forward = nn.Sequential(

nn.Linear(embed_size, forward_expansion * embed_size),

nn.ReLU(),

nn.Linear(forward_expansion * embed_size, embed_size)

)

self.dropout = nn.Dropout(dropout)

def forward(self, value, key, query, mask):

attention = self.attention(value, key, query, mask)

x = self.dropout(self.norm1(attention + query)) # スキップ接続

forward = self.feed_forward(x)

out = self.dropout(self.norm2(forward + x)) # スキップ接続

return out- スキップ接続の必要性は?

- スキップ接続は、Transformerのように多数のブロックを重ねた深いモデルの学習を安定させるための技術です。層の出力をその入力に直接加算することで、逆伝播時に勾配が層を迂回して伝わる「近道」を作り、勾配消失問題を緩和します。

- これにより、モデルは入力情報との「差分」のみを学習すればよくなり、元の重要な情報を失うことなく、文脈に応じた特徴を効率的に獲得できます。この仕組みが、Transformerが多数の層を重ねて高性能化することを可能にしています。

- スキップ接続は、Transformerのように多数のブロックを重ねた深いモデルの学習を安定させるための技術です。層の出力をその入力に直接加算することで、逆伝播時に勾配が層を迂回して伝わる「近道」を作り、勾配消失問題を緩和します。

CrossAttentionクラスの定義

- Cross-Attentionは、異なる入力シーケンスをクエリ、キー、バリューとして使用します。

class CrossAttention(nn.Module):

def __init__(self, embed_size, num_heads):

super(CrossAttention, self).__init__()

assert embed_size % num_heads == 0, "Embedding size must be divisible by number of heads"

self.head_dim = embed_size // num_heads

self.num_heads = num_heads

self.embed_size = embed_size

self.values = nn.Linear(embed_size, embed_size, bias=False)

self.keys = nn.Linear(embed_size, embed_size, bias=False)

self.queries = nn.Linear(embed_size, embed_size, bias=False)

self.fc_out = nn.Linear(embed_size, embed_size)

def forward(self, values, keys, queries, mask=None):

N = queries.shape[0] # バッチサイズ

value_len, key_len, query_len = values.shape[1], keys.shape[1], queries.shape[1]

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# 埋め込みをself.num_heads個に分割

values = values.view(N, value_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

keys = keys.view(N, key_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

queries = queries.view(N, query_len, self.num_heads, self.head_dim).permute(0, 2, 1, 3)

# スケールド・ドットプロダクト・アテンション

scores = torch.matmul(queries, keys.permute(0, 1, 3, 2)) / (self.head_dim ** 0.5)

if mask is not None:

scores = scores.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(scores, dim=-1)

out = torch.matmul(attention, values)

out = out.permute(0, 2, 1, 3).contiguous()

out = out.view(N, query_len, self.embed_size)

return self.fc_out(out)Encoderクラスの定義(Position Encodingの実装)

- Position Encodingは、シーケンス内の各トークンの位置情報を埋め込みベクトルに追加するために使用されます。これにより、モデルはトークンの順序を認識することができます。

class Encoder(nn.Module):

def __init__(self, src_vocab_size, embed_size, num_layers, num_heads, device, forward_expansion, dropout, max_length):

super(Encoder, self).__init__()

self.embed_size = embed_size

self.device = device

self.word_embedding = nn.Embedding(src_vocab_size, embed_size)

self.position_embedding = nn.Embedding(max_length, embed_size)

self.layers = nn.ModuleList(

[

TransformerBlock(embed_size, num_heads, dropout, forward_expansion)

for _ in range(num_layers)

]

)

self.dropout = nn.Dropout(dropout)

def forward(self, x, mask):

N, seq_length = x.shape

positions = torch.arange(0, seq_length).expand(N, seq_length).to(self.device)

out = self.dropout(self.word_embedding(x) + self.position_embedding(positions))

for layer in self.layers:

out = layer(out, out, out, mask)

return outDecoderBlockクラスの定義

- Self-AttentionとCross-Attentionを組み合わせて、シーケンス内およびシーケンス間の関連性を計算します。また、LayerNormとDropoutを用いて、正規化と過学習防止を行い、モデルの安定性と汎化性能を向上させます。

class DecoderBlock(nn.Module):

def __init__(self, embed_size, num_heads, forward_expansion, dropout, device):

super(DecoderBlock, self).__init__()

self.attention = MultiHeadAttention(embed_size, num_heads)

self.cross_attention = CrossAttention(embed_size, num_heads)

self.norm1 = nn.LayerNorm(embed_size)

self.norm2 = nn.LayerNorm(embed_size)

self.norm3 = nn.LayerNorm(embed_size)

self.feed_forward = nn.Sequential(

nn.Linear(embed_size, forward_expansion * embed_size),

nn.ReLU(),

nn.Linear(forward_expansion * embed_size, embed_size)

)

self.dropout = nn.Dropout(dropout)

def forward(self, x, enc_out, src_mask, trg_mask):

attention = self.attention(x, x, x, trg_mask)

query = self.dropout(self.norm1(attention + x)) # スキップ接続

cross_attention = self.cross_attention(enc_out, enc_out, query, src_mask)

x = self.dropout(self.norm2(cross_attention + query)) # スキップ接続

forward = self.feed_forward(x)

out = self.dropout(self.norm3(forward + x)) # スキップ接続

return outDecoderクラスの定義

- デコーダーは、エンコーダーの出力を基に次のトークンを予測・生成します。

class Decoder(nn.Module):

def __init__(self, trg_vocab_size, embed_size, num_layers, num_heads, forward_expansion, dropout, device, max_length):

super(Decoder, self).__init__()

self.device = device

self.word_embedding = nn.Embedding(trg_vocab_size, embed_size)

self.position_embedding = nn.Embedding(max_length, embed_size)

self.layers = nn.ModuleList(

[

DecoderBlock(embed_size, num_heads, forward_expansion, dropout, device)

for _ in range(num_layers)

]

)

self.fc_out = nn.Linear(embed_size, trg_vocab_size)

self.dropout = nn.Dropout(dropout)

def forward(self, x, enc_out, src_mask, trg_mask):

N, seq_length = x.shape

positions = torch.arange(0, seq_length).expand(N, seq_length).to(self.device)

x = self.dropout(self.word_embedding(x) + self.position_embedding(positions))

for layer in self.layers:

x = layer(x, enc_out, src_mask, trg_mask)

out = self.fc_out(x)

return outTransformerクラスの定義

- Transformerクラスは、エンコーダーとデコーダーを組み合わせて、完全なTransformerモデルを構築するための重要な役割を果たします。また、

make_src_maskはソース系列のマスクを生成し、make_trg_maskはターゲット系列のマスクを生成するメソッドです。

class Transformer(nn.Module):

def __init__(self, src_vocab_size, trg_vocab_size, src_pad_idx, trg_pad_idx, embed_size=256, num_layers=6, forward_expansion=4, num_heads=8, dropout=0.1, device="cuda", max_length=100):

super(Transformer, self).__init__()

self.encoder = Encoder(src_vocab_size, embed_size, num_layers, num_heads, device, forward_expansion, dropout, max_length)

self.decoder = Decoder(trg_vocab_size, embed_size, num_layers, num_heads, forward_expansion, dropout, device, max_length)

self.src_pad_idx = src_pad_idx

self.trg_pad_idx = trg_pad_idx

self.device = device

def make_src_mask(self, src):

src_mask = (src != self.src_pad_idx).unsqueeze(1).unsqueeze(2)

return src_mask.to(self.device)

def make_trg_mask(self, trg):

N, trg_len = trg.shape

trg_mask = torch.tril(torch.ones((trg_len, trg_len))).expand(N, 1, trg_len, trg_len)

return trg_mask.to(self.device)

def forward(self, src, trg):

src_mask = self.make_src_mask(src)

trg_mask = self.make_trg_mask(trg)

enc_src = self.encoder(src, src_mask)

out = self.decoder(trg, enc_src, src_mask, trg_mask)

return outハイパーパラメータの設定とモデルのインスタンス化

# ハイパーパラメータの設定

src_vocab_size = 10000 # ソース語彙サイズ

trg_vocab_size = 10000 # ターゲット語彙サイズ

src_pad_idx = 0 # パディングインデックス

trg_pad_idx = 0 # パディングインデックス

embed_size = 256

num_layers = 6

forward_expansion = 4

num_heads = 8

dropout = 0.1

max_length = 100

# device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

# モデルのインスタンス化

model = Transformer(

src_vocab_size, trg_vocab_size, src_pad_idx, trg_pad_idx,

embed_size, num_layers, forward_expansion, num_heads,

dropout, device, max_length

).to(device)ダミーデータの作成

# ダミーデータの作成

batch_size = 32

src_seq_length = 50

trg_seq_length = 60

src = torch.randint(1, src_vocab_size, (batch_size, src_seq_length)).to(device)

trg = torch.randint(1, trg_vocab_size, (batch_size, trg_seq_length)).to(device)オプティマイザと損失関数の設定

# オプティマイザと損失関数の設定

optimizer = torch.optim.Adam(model.parameters(), lr=0.0001)

criterion = nn.CrossEntropyLoss(ignore_index=trg_pad_idx)トレーニングループの例

# トレーニングループの例

num_epochs = 10

for epoch in range(num_epochs):

model.train()

optimizer.zero_grad()

# trg_in: デコーダへの入力(最後のトークンを除く)

trg_in = trg[:, :-1]

# trg_out: 損失計算用ラベル(最初のトークンを除く)

trg_out = trg[:, 1:]

output = model(src, trg_in) # (Batch, trg_len-1, trg_vocab_size)

output = output.reshape(-1, output.shape[2]) # (Batch*(trg_len-1), trg_vocab_size)

trg_out = trg_out.reshape(-1) # (Batch*(trg_len-1))

loss = criterion(output, trg_out)

loss.backward()

optimizer.step()

print(f"Epoch {epoch+1}/{num_epochs}, Loss: {loss.item():.4f}")Epoch 8/10, Loss: 9.1729

Epoch 9/10, Loss: 9.1145

Epoch 10/10, Loss: 9.0978マスクの用途と役割

- どちらもSelf-Attentionに対するマスクであり、TransformerモデルのAttention計算の妥当性を維持するために重要な役割を果たします。

| マスク種類 | 適用場所 | 目的 |

|---|---|---|

| make_src_mask | エンコーダのSelf-Attention | パディングトークンを無視し、必要な情報だけをAttention計算に利用する。 |

| make_trg_mask | デコーダのSelf-Attention | 未来のトークンを参照しないようにし、逐次的な生成プロセスを守る。 |

論文

『Attention Is All You Need』

- 再帰・畳み込みの排除

- Transformerは、再帰(RNN)や畳み込み(CNN)を完全に排除し、自己注意機構を活用することで、並列処理と計算効率を大幅に向上させました。RNNが逐次処理によりトレーニング時間が長くなる一方で、Transformerはトークン間の依存関係を一括で計算可能です。また、CNNのように長距離依存を多層で学習する必要がなく、効率的に関係性をモデリングできます。この結果、大規模データでも短時間で高精度を達成し、自然言語処理の分野で新たな基準を打ち立てました。

- 機械翻訳での画期的な性能

- Transformerは、WMT 2014英独翻訳でBLEUスコア28.4、英仏翻訳で41.8を達成し、従来モデルを大幅に上回る性能を示しました。この成果は、自己注意機構を活用して効率的に依存関係を学習できる点や、8つのGPUでわずか3.5日間のトレーニングで高精度を実現したことに基づきます。従来のRNNやCNNモデルと比較して計算効率が高く、短期間で優れた翻訳結果を出せることが、商業利用や研究分野での活用を促進しています。

- 汎用性と応用範囲

- Transformerは、翻訳だけでなく構文解析や要約、質問応答など多様な自然言語処理タスクに適用可能です。自己注意機構により、文中の長距離依存関係を効率的に学習し、高精度な結果を短時間で得られます。計算効率の高さと汎用的なアーキテクチャにより、法律や医療、教育などの分野での実用化も進展。タスク固有の設計を必要とせず、微調整だけで幅広い用途に対応できる点が特長です。

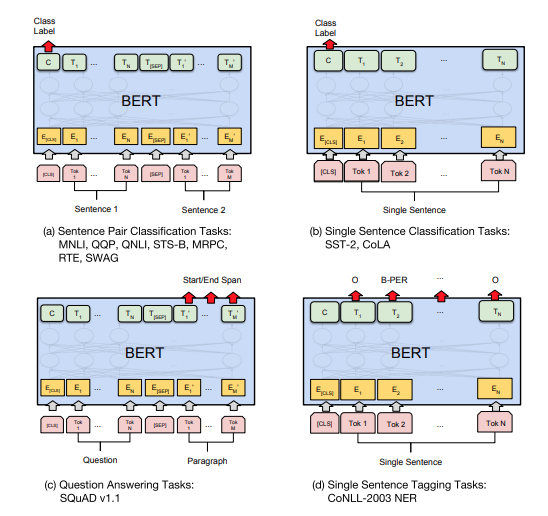

自然言語処理への応用

次に、先ほど説明したTransformerを基盤とした応用モデルである「BERT」と「GPTシリーズ」について、具体的な仕組みや応用例を詳しく解説します。

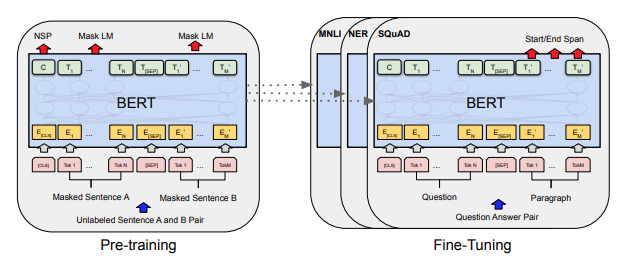

BERT

BERTは2018年にGoogleが提案した双方向Transformerモデルで、双方向の文脈モデリングによりNLPタスクに革命をもたらしました。それ以前のモデル(例: GPT)が単方向で文脈を考慮していたのに対し、BERTは双方向の文脈理解と転移学習を導入し、多様なタスクで圧倒的な精度を達成しました。計算コストの高さが課題ですが、現在もRoBERTaやDistilBERTなど多くの派生モデルや技術の基盤として活用されています。

特徴

- 双方向の文脈モデリング

- 文中の単語を左右両方向から同時に捉えることで、より正確な文脈理解を実現します。例えば、「私は本が好きです」という文では、「本」の文脈を「私は」と「好きです」の両方向から補完します。

- 事前学習とファインチューニング

- 大規模データで事前学習を行い、その後、タスク固有のデータを用いて微調整(ファインチューニング)します。

- マスク付き言語モデル

- 文中の一部の単語を隠し、その隠れた単語を予測することで、双方向の文脈を学習します。

- 次文予測

- 文と文の関係性(連続性があるかどうか)を学習し、文ペアに関連するタスクの精度を向上させます。

数式

- Attention計算

- Self-Attentionを用いて文脈を学習します。

$$\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^\top}{\sqrt{d_k}}\right)V$$

- MLM損失関数

$$L_{\text{MLM}} = – \sum_{i \in M} \log P(x_i \mid x_{\setminus i})$$

$M$:マスクされた単語の位置。$x_i$:マスクされた単語。$x_{/i}$:マスクされた単語以外の文脈。

- NSP損失関数

$$L_{\text{NSP}} = – \left[ y \log P(y = 1 \mid x) + (1 – y) \log P(y = 0 \mid x) \right]$$

メリットとデメリット

| メリット | デメリット |

|---|---|

| 高い汎用性:文書分類、翻訳、質問応答など、幅広いNLPタスクに適用可能。 | 計算資源の負担:モデルサイズが大きく、GPUやTPUなどの高性能計算環境が必須。 |

| 転移学習の効果:事前学習済みモデルを微調整することで、タスク固有の学習コストを大幅に削減。 | 事前学習コスト:大量のデータと長時間のトレーニングが必要。 |

| 高精度:双方向文脈を考慮することで、従来モデルを超える精度を達成。 | 次文予測の課題:NSPタスクは一部のNLPタスクには不要で、後続モデル(RoBERTaなど)では削除される傾向。 |

適用例

| 適用例 | 説明 |

|---|---|

| 質問応答 | SQuAD(Stanford Question Answering Dataset)での高精度な回答生成。 |

| 文書分類 | 感情分析、スパム検知。 |

| 自然言語推論 | 文ペア間の関連性解析。 |

| 名前付きエンティティ認識 | テキストからの特定のエンティティ抽出(例: 人名や地名)。 |

BERTの実装)

- このコードでは、Hugging FaceのTransformersライブラリを使用して、日本語のBERTモデルをロードし、テキストの分類タスクを実行します。

import torch

from transformers import BertTokenizer, BertForSequenceClassification

# モデルとトークナイザーのロード

model_name = "cl-tohoku/bert-base-japanese"

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name, num_labels=2)

# デバイスの設定

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)

# テスト用の日本語テキスト

texts = [

"この映画はとても感動的で、最後まで涙が止まりませんでした。",

"このレストランの料理は美味しいですが、サービスが遅いです。",

"この本は非常に退屈で、読むのに時間がかかりました。",

"この製品は高品質で、非常に満足しています。",

"このホテルの部屋は清潔で快適でしたが、スタッフの対応が悪かったです。"

]

# テキストのトークナイズとテンソルへの変換

inputs = tokenizer(texts, return_tensors="pt", padding=True, truncation=True, max_length=128)

inputs = {key: value.to(device) for key, value in inputs.items()}

# モデルの推論

with torch.no_grad():

outputs = model(**inputs)

# ログイットを取得し、ソフトマックス関数を適用して確率を計算

logits = outputs.logits

probs = torch.softmax(logits, dim=-1)

# 結果の表示

for i, text in enumerate(texts):

print(f"テキスト: {text}")

print(f"ポジティブ確率: {probs[i][1].item():.4f}, ネガティブ確率: {probs[i][0].item():.4f}")テキスト: この映画はとても感動的で、最後まで涙が止まりませんでした。

ポジティブ確率: 0.5446, ネガティブ確率: 0.4554

テキスト: このレストランの料理は美味しいですが、サービスが遅いです。

ポジティブ確率: 0.4917, ネガティブ確率: 0.5083

テキスト: この本は非常に退屈で、読むのに時間がかかりました。

ポジティブ確率: 0.4487, ネガティブ確率: 0.5513

テキスト: この製品は高品質で、非常に満足しています。

ポジティブ確率: 0.4927, ネガティブ確率: 0.5073

テキスト: このホテルの部屋は清潔で快適でしたが、スタッフの対応が悪かったです。

ポジティブ確率: 0.5060, ネガティブ確率: 0.4940論文

『BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding』

- 双方向性の導入

- BERTの革新は双方向の文脈を学習できる仕組みの導入です。従来の一方向モデルは片側の文脈しか考慮できず、文の完全な意味を捉えるのが難しい課題がありました。BERTは、隠された単語を周囲の文脈から予測するMasked Language Model(MLM)と、2文の関連性を判定するNext Sentence Prediction(NSP)の2つのタスクを活用。これにより、左側と右側の文脈情報を同時に活用する能力がモデルに加わり、幅広い自然言語処理タスクで高い性能を実現しました。

- 幅広いNLPタスクでの性能向上

- BERTは、GLUEやSQuADなどの主要ベンチマークで大幅な性能向上を達成しました。GLUEスコアを80.5%(+7.7%)に引き上げたほか、SQuAD v1.1ではF1スコア93.2(+1.5)、v2.0では83.1(+5.1)を記録。特に質問応答や自然言語推論タスクで高い精度を示し、微調整のみで最先端の結果を達成しました。この汎用性により、BERTは多様なNLPタスクに適用可能な新しい標準モデルとなりました。

- 転移学習の効率性

- BERTは、事前学習済みモデルを微調整するだけで多様なNLPタスクに適用可能です。複雑なタスク固有の設計が不要で、特にラベル付きデータが少ないタスクでも高精度を発揮します。双方向Transformer構造により、文脈の全体像を捉える能力が向上し、幅広い言語知識を活用可能です。この効率的な転移学習により、BERTはNLPの汎用性と生産性を飛躍的に向上させました。

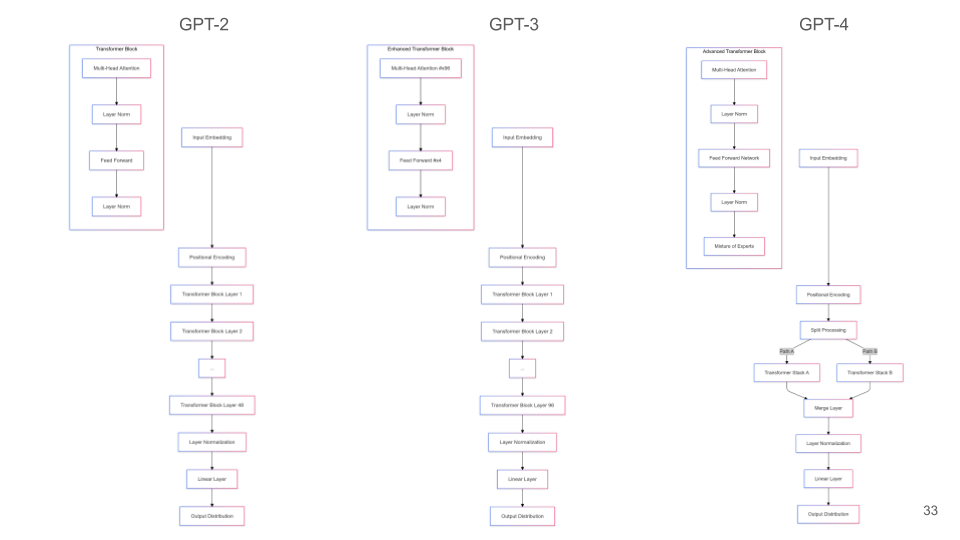

GPTシリーズ

GPT(Generative Pre-trained Transformer)は、OpenAIが開発した自然言語生成に特化したTransformerベースのモデルで、初代GPTからGPT-4まで進化を遂げました。Transformerのデコーダー部分のみを使用し、自己回帰型モデルとして未来のトークンを逐次予測する仕組みで自然な文生成を実現します。自然言語生成や汎用的なNLPタスクで高い性能を発揮する一方、計算リソースの負荷やバイアス問題が課題として残されています。

動作イメージの説明

- この図は、Transformerデコーダーブロックの構造を示しており、GPTモデルのアーキテクチャに対応しています。入力トークンに位置情報を加算後、Self-Attentionとフィードフォワードネットワークを通じて処理を行います。マスク処理により未来のトークンを参照せず、残差接続やLayerNormで安定性を向上。これを複数層繰り返すことで、自己回帰型の自然言語生成を実現します。GPTは、このデコーダー部分のみを使用したモデルです。

特徴

| 特徴 | 説明 |

|---|---|

| 自己回帰型アーキテクチャ | 文章の次の単語を逐次予測し、文脈に適合した文を生成。 |

| 単方向文脈モデリング | 入力トークンの左側(過去)の情報に基づいて、次のトークンを生成。双方向モデル(BERT)とは異なり、生成に特化。 |

| 大規模事前学習 | インターネットから収集した膨大なデータで事前学習を行い、文法、知識、論理構造を学習。 |

| 拡張性 | パラメータ数の増加に伴い、性能が指数的に向上(GPT: 110M → GPT-2: 1.5B → GPT-3: 175B→GPT-4: 1,760B)。 |

数式

- 自己回帰型生成

- GPTは以下の条件付き確率を最大化します。

$$P(x_1, x_2, \ldots, x_n) = \prod_{t=1}^n P(x_t \mid x_1, x_2, \ldots, x_{t-1})$$

- $x_t$: $t$ 番目のトークン。

- Attention計算

- Self-Attention機構を用いて、過去のすべてのトークンを考慮します。

$$\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^\top}{\sqrt{d_k}}\right)V$$

- 位置埋め込み (Position Encoding)

- GPTは単語順序を保持するため、以下の埋め込みを加えます。

$$PE(pos, 2i) = \sin\left(\frac{pos}{10000^{\frac{2i}{d_{\text{model}}}}}\right), \quad

PE(pos, 2i+1) = \cos\left(\frac{pos}{10000^{\frac{2i}{d_{\text{model}}}}}\right)$$

メリットとデメリット

| メリット | デメリット |

|---|---|

| 自然な文生成:人間に近い文章を生成でき、多様なNLPタスクに適用可能。 | エネルギー消費:トレーニングに莫大なエネルギーが必要で、環境負荷が高い。 |

| 汎用性:事前学習済みモデルを微調整するだけで多種多様なタスクを処理。 | データ依存:トレーニングデータの品質に大きく依存し、不適切なデータが影響を与える。 |

| スケーラビリティ:モデルサイズと性能の間に明確な相関があり、性能向上が期待できる。 | コスト:商用利用には高性能なハードウェアが必要で、コストがかかる。 |

適用例

| 適用例 | 説明 |

|---|---|

| 対話モデル | ChatGPTのような高度な対話生成。 |

| コンテンツ生成 | 記事、詩、ストーリーの自動生成。 |

| コード生成 | GitHub Copilotのようなプログラミング支援。 |

| 翻訳 | 多言語間のテキスト変換。 |

| 質問応答 | ユーザーの質問に適切な回答を生成。 |

それぞれのGPTの動作イメージ

| モデル | 層数 | アーキテクチャの特徴 | 備考 |

|---|---|---|---|

| GPT-2 | 48 | 標準的なTransformerブロックを持つ基本的なTransformerアーキテクチャ。 | 初代GPTからの進化版で、生成能力が向上。 |

| GPT-3 | 96 | モデルのサイズと複雑さが大幅に増加したスケールアップされたアーキテクチャ。 | パラメータ数が1750億に達し、多様なタスクに対応。 |

| GPT-4 | 非公開 | 分岐した処理パスやMixture of Experts(専門家の混合)などの追加コンポーネントを備えた、より高度なアーキテクチャ。 | 正確な詳細は公開されていないが、性能と効率が向上。 |

GPT-2の実装例)

- GPT-2モデルは与えられた入力テキストに応じた新しいテキストを生成します。

from transformers import GPT2LMHeadModel, GPT2Tokenizer

import torch

# モデルとトークナイザーの読み込み

model_name = "gpt2"

model = GPT2LMHeadModel.from_pretrained(model_name)

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

# pad_token を eos_token に設定

tokenizer.pad_token = tokenizer.eos_token

model.config.pad_token_id = tokenizer.eos_token_id

# padding_side を left に設定

tokenizer.padding_side = 'left'

# デバイスの設定

# device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)

# 入力テキスト(より日常的な内容に変更)

input_text = (

"Today, I went to the coffee shop with my friends and we had a great time discussing our weekend plans."

)

# トークナイズとattention_maskの作成

encoding = tokenizer.encode_plus(

input_text,

add_special_tokens=True,

return_tensors="pt",

padding='max_length',

truncation=True,

max_length=50

)

input_ids = encoding['input_ids'].to(device)

attention_mask = encoding['attention_mask'].to(device)

# テキスト生成

output = model.generate(

input_ids=input_ids,

attention_mask=attention_mask,

max_length=100, # 生成するテキストの最大長(トークン数)

num_return_sequences=1, # 生成するシーケンスの数

no_repeat_ngram_size=2, # 繰り返しを避けるn-gramのサイズ

temperature=0.7, # 温度パラメータ(生成の多様性)

top_k=50, # 上位k個のトークンから選択

top_p=0.95, # 累積確率がtop_pを超えるまでトークンを選択

do_sample=True, # サンプリングを有効にする

pad_token_id=tokenizer.eos_token_id # pad_token_idの設定

)

# 結果のデコード

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print("Generated Text:", generated_text)全体の流れ

- 必要なライブラリをインポートし、GPT-2モデルとトークナイザーをロード。デバイスやパディングの設定を調整。

- 入力テキストをトークナイズし、パディングとマスクを適用。

- モデルでテキストを生成し、生成パラメータを調整して多様性と一貫性を確保。

- 結果をデコードしてテキストを表示。

論文

論文1:「Universal Language Model Fine-tuning for Text Classification」

- 汎用的なNLP転移学習の実現

- ULMFiTは、NLPにおける転移学習を汎用化し、タスク固有のカスタマイズを不要にしました。一般ドメインで事前学習した言語モデルを活用し、少量のラベル付きデータでも高性能を実現します。たとえば、IMDbデータセットでは、わずか100個のラベル付きデータで、従来モデルが100倍のデータで達成する精度を上回りました。また、エラー率を18-24%削減し、多様なタスクに対応可能な柔軟性を提供しています。この手法により、NLPモデルの効率的な活用が大幅に進展しました。

- 画期的なファインチューニング技術

- ULMFiTは、「分散ファインチューニング」「斜め三角学習率」「段階的解凍」という新技術を導入し、転移学習の課題である破滅的忘却を克服しました。分散ファインチューニングでは層ごとに異なる学習率を適用し、斜め三角学習率では初期に急速な学習を進めながら後半で安定化させます。さらに、段階的解凍により、事前学習の知識を保持しつつタスクへの適応を実現。これらにより、少量データや異なるドメインでも安定して高性能な学習が可能となりました。

論文2:『Language Models are Few-Shot Learners』

- 大規模モデルによる少数ショット学習の性能向上

- GPT-3は、1750億パラメータという圧倒的な規模を持つ自己回帰型言語モデルです。この大規模化により、従来のモデルが必要とした数万サンプルのトレーニングやファインチューニングなしで、数個の例だけで新しいタスクに適応する「少数ショット学習」が可能となりました。文法訂正や読解、推論など多様なタスクで高い性能を発揮し、タスク非依存の汎用性を実証。これにより、迅速かつ効率的なタスク適応が可能になり、NLPの可能性を大きく広げています。

- タスク非依存かつ多様な応用可能性

- GPT-3は、文法修正や抽象的概念生成、読解、推論といった幅広いタスクに対応可能な汎用性を持ちます。この「タスク非依存性」により、従来の個別モデルを必要としない効率性を実現しました。一方で、ゼロショット設定での性能低下や双方向コンテキスト処理の課題といった限界も明らかになりました。これらを踏まえ、GPT-3はNLPの可能性を広げる一方で、さらなる改善の余地がある重要なモデルと言えます。

論文3:『Scaling Laws for Neural Language Models』

- 損失のべき乗則スケーリング

- この論文では、言語モデルの損失(クロスエントロピー損失)がモデルサイズ、データセットサイズ、計算量に応じてべき乗則的に減少することを示しました。特に、モデルサイズを8倍に増加させる際、データセットサイズを5倍にするだけで効率的な性能向上が可能である具体的な指針が示されています。また、これにより過学習やリソース不足を防ぎつつ、限られた計算リソースでも効果的なトレーニング戦略を立てられるようになります。この知見は、リソース配分を最適化した言語モデルの開発に貢献します。

- クリティカルバッチサイズと効率的学習

- この研究では、クリティカルバッチサイズ(学習効率を維持できる最大バッチサイズ)が損失の減少に応じて倍増するべき乗則的な関係を示しました。特に、最適なバッチサイズを選ぶことで、トレーニングステップ数を削減しつつ効率的な学習が可能になります。この知見により、固定された計算予算下でもリソースを最大限に活用し、大規模モデルのトレーニングコスト削減や速度向上を実現できる具体的な戦略が提供されます。

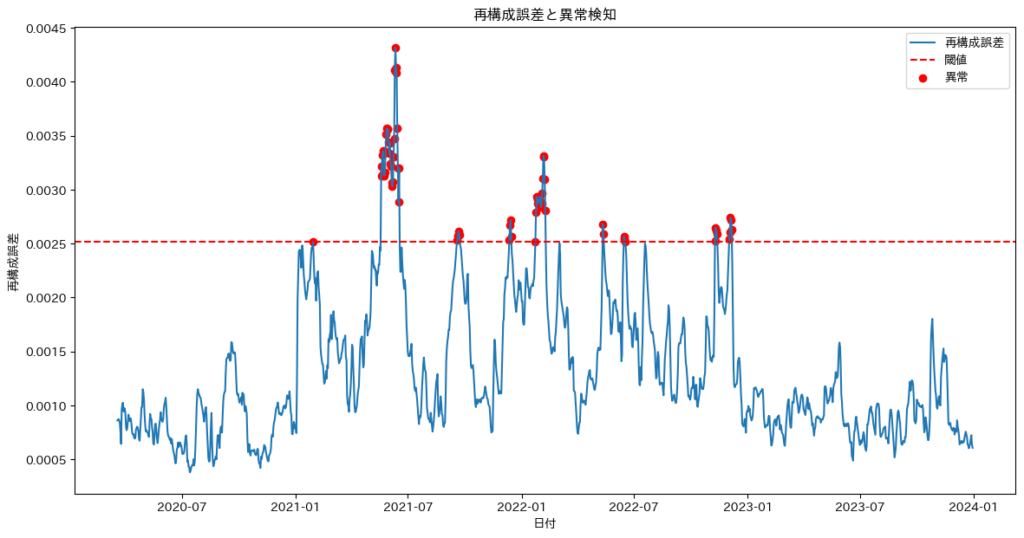

時系列データ解析におけるTransformerの応用

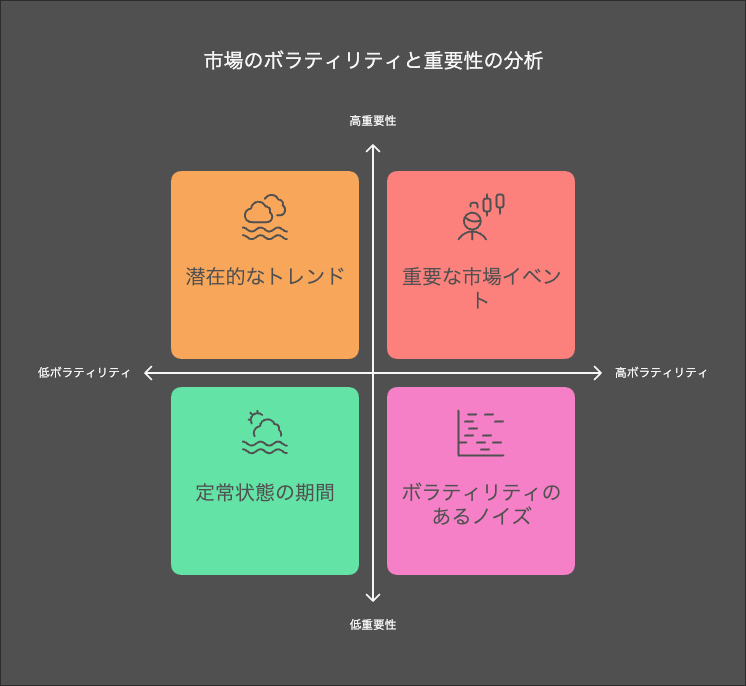

なぜTransformerが時系列データ解析に適しているのか?

- 時系列データ解析は、株価予測や需要予測などで重要ですが、長期的な依存関係の処理には従来のRNNやLSTMに限界がありました。TransformerはSelf-Attention機構を活用することで並列処理を可能にし、これらの課題を効果的に解決しています。

時系列データの課題

- 長期依存関係のモデリング

- 時系列データでは、過去の重要なイベントが現在や未来に影響を与えることがあります。例えば、数ヶ月前の経済指標が現在の株価に影響を及ぼすことがありますが、従来のモデルではこのような長期的な依存関係を学習するのが難しい場合がありました。

- 非線形構造の複雑さ

- 時系列データは単純な直線的相関だけでなく、非線形なパターンや複雑な因果関係を含むことが多いです。

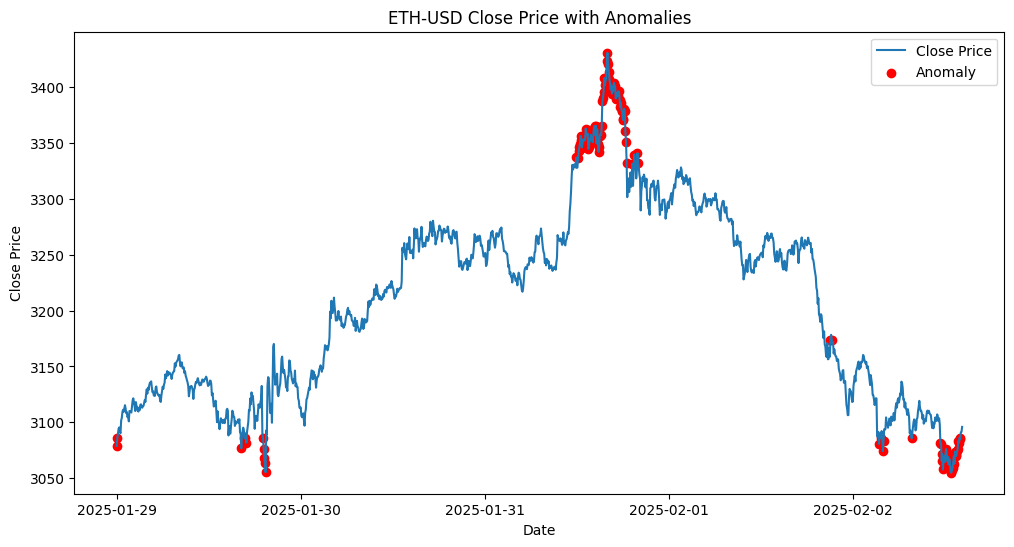

- ノイズ対応

- 特に金融市場やセンサーデータでは、外れ値やノイズが頻繁に含まれます。これらのノイズを適切に処理しつつ、意味のあるパターンを抽出することが重要です。

RNNからTransformerへの進化

- RNNの課題

- RNNやその改良版であるLSTMやGRUは、逐次処理が必要なため並列処理ができず、計算効率が低いという課題があります。また、長期的な依存関係を十分に捉えられないという限界もあります。

- Transformerの利点

- TransformerはSelf-Attentionを活用してデータ間の全ての依存関係を直接モデル化し、並列処理を可能にします。これにより、大規模データでも効率的に学習できます。

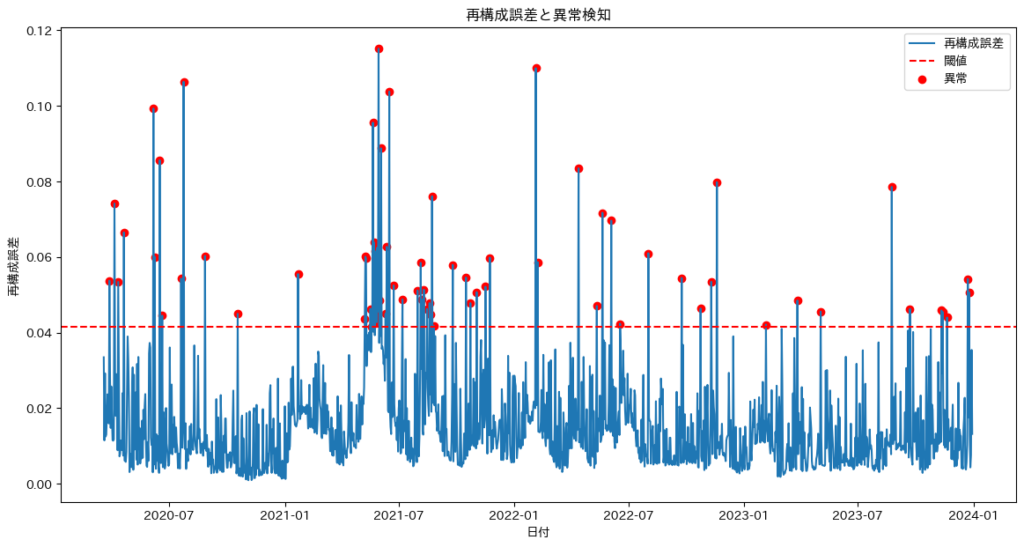

Transformerの時系列データへの応用例

| 応用例 | 説明 | 具体例 |

|---|---|---|

| 株価予測 | 複数の銘柄や指標間の相関をモデル化し、特定のイベントが異なる時間スケールでどのように影響を与えるかを学習します。 | 株式市場の動向予測、イベントドリブンの株価変動分析。 |

| 異常検知 | 工場のセンサーデータや金融市場データを活用した異常検知に応用されます。ノイズや外れ値に強い解析モデルとして機能し、潜在空間を利用して異常な時系列パターンを識別します。 | 工場設備の異常検出、金融取引の不正検知。 |

| 需要予測 | 小売業や物流業界での需要予測に活用され、季節性やイベントの影響を考慮した予測が可能です。 | 季節商品やセール期間中の商品の需要予測。 |

メリットと課題

| メリット | 課題 |

|---|---|

| 並列処理による計算効率の向上。 | 高い計算コストとメモリ使用量。 |

| 長期依存関係や複雑な相関性のモデリング。 | 順序情報を補完するPosition Encodingの設計。 |

| 多次元データを同時に処理できる。 | 特定タスクに合わせたハイパーパラメータの調整が必要。 |

補足説明

- メリット

- 並列処理による計算効率の向上。

- Transformerモデルは自己注意機構(Self-Attention)を活用することで、従来のRNNベースのモデルに比べて並列処理が可能となり、計算効率が大幅に向上します。

- 長期依存関係や複雑な相関性のモデリング。

- 自己注意機構により、入力シーケンス内の全てのトークン間の関係性を同時に捉えることができ、長期的な依存関係や複雑な相関性を効果的にモデル化します。

- 多次元データを同時に処理できる。

- Transformerは多次元の特徴量を一括して処理できるため、画像や音声、テキストなど多様なデータ形式に対応可能です。

- 並列処理による計算効率の向上。

- 課題

- 高い計算コストとメモリ使用量。

- 自己注意機構は入力シーケンスの長さに対して二乗の計算コストがかかるため、大規模なデータセットや長いシーケンスの処理には大量の計算資源とメモリが必要となります。

- 順序情報を補完するPosition Encodingの設計。

- Transformerは並列処理が可能な反面、シーケンスの順序情報を直接的に捉えることができないため、位置埋め込み(Position Encoding)を設計して順序情報を補完する必要があります。

- 特定タスクに合わせたハイパーパラメータの調整が必要。

- Transformerモデルの性能を最大限に引き出すためには、学習率、層数、ヘッド数など多くのハイパーパラメータをタスクに合わせて最適化する必要があります。

- 高い計算コストとメモリ使用量。

時系列データ解析における様々なTransformerの活用例

金融データ予測に関する方法論

- 金融データの予測には、統計的手法から機械学習・ディープラーニングまで、さまざまな方法論が存在します。

| 方法論 | 代表的な手法 | メリット | デメリット |

|---|---|---|---|

| 統計手法 | ARIMA, GARCH, VAR | 解釈性が高い | 複雑なデータには弱い |

| 機械学習 | ランダムフォレスト, XGBoost | 非線形な関係を捉えやすい | 過学習のリスク |

| ディープラーニング | LSTM, Transformer | 高精度な時系列予測が可能 | 計算コストが高い |

| 強化学習 | DQN, PPO | トレーディング戦略の最適化 | 収束が不安定 |

| 量子金融 | 量子ボルツマンマシン | 量子計算の強みを活かせる | 実用化には時間がかかる |

予測手法の選択は、データの特性や目的に応じて決定されます。特に統計手法と機械学習を組み合わせるハイブリッドアプローチが注目されています。

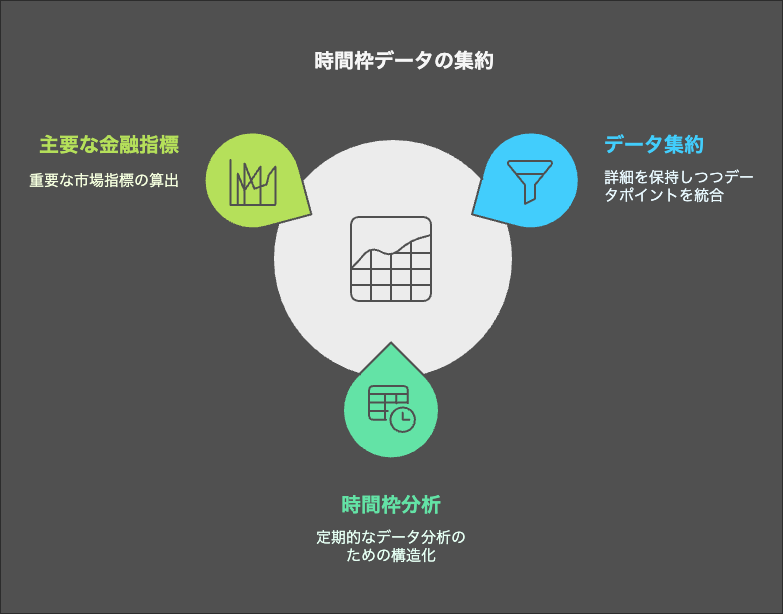

この章ではディープラーニングを使った時系列データ解析における、様々なTransformerの活用例として特に金融時系列データ解析についての方法論をいくつかに分けて説明します。まずは金融時系列データ解析にはどのような種類の方法論があるのかを確認してみましょう。

| 方法 | 説明 |

|---|---|

| 予測 | 株価、為替、金利、仮想通貨価格などの将来予測 |

| ノイズ除去 | 価格データのノイズを除去し、スムーズな時系列を生成する |

| 異常値検出 | 異常な市場変動や急激な価格変動を検出する |

| ボラティリティ予測 | 短期・長期のボラティリティを予測し、リスク管理に活用 |

| リスク管理 | VaR(リスク値)やES(VaRを超えた場合に期待される平均損失額を測る指標)などのリスク指標を計算し、リスク管理に利用 |

| ポートフォリオ最適化 | 過去のリターンデータから最適な資産配分を計算 |

| 市場間の相関分析 | 異なる市場(株式、為替、債券など)の相関関係を解析 |

| マルチスケール学習 | 短期的・長期的な市場トレンドを同時に学習 |

| 市場の状態クラスタリング | 市場のトレンドをクラスタリングし、強気・弱気相場を分類 |

| 強化学習の補助 | 強化学習の状態表現を改善し、最適なトレーディング戦略を構築 |

| 特徴量エンベディング | 時系列データを埋め込みベクトルに変換し、非線形特徴を抽出 |

| イベントインパクト分析 | ニュースやイベントの市場への影響を分析し、価格変動を予測 |

| 因果推論 | 金融市場における因果関係を分析し、マクロ経済指標の影響を理解 |

| 階層的モデリング | 市場全体、セクター、個別銘柄の階層構造をモデル化 |

| モメンタム/リバーサル分析 | 価格トレンドの持続性や反転パターンを分析 |

| 動的ネットワーク分析 | 金融市場の動的な関係(ペアトレードなど)をネットワークとして解析 |

| データ合成 | 時系列データの補完や合成を行い、シミュレーションデータを作成 |

| エコシステム全体の分析 | SNSやニュースデータを統合し、価格変動に与える影響を分析 |

時系列データ解析において、Transformerはさまざまな手法と組み合わせることで、より効果的な分析が可能になります。予測、ノイズ除去、異常検知、ボラティリティ予測、リスク管理 など、目的に応じたアプローチを適切に選択し、組み合わせることが重要です。

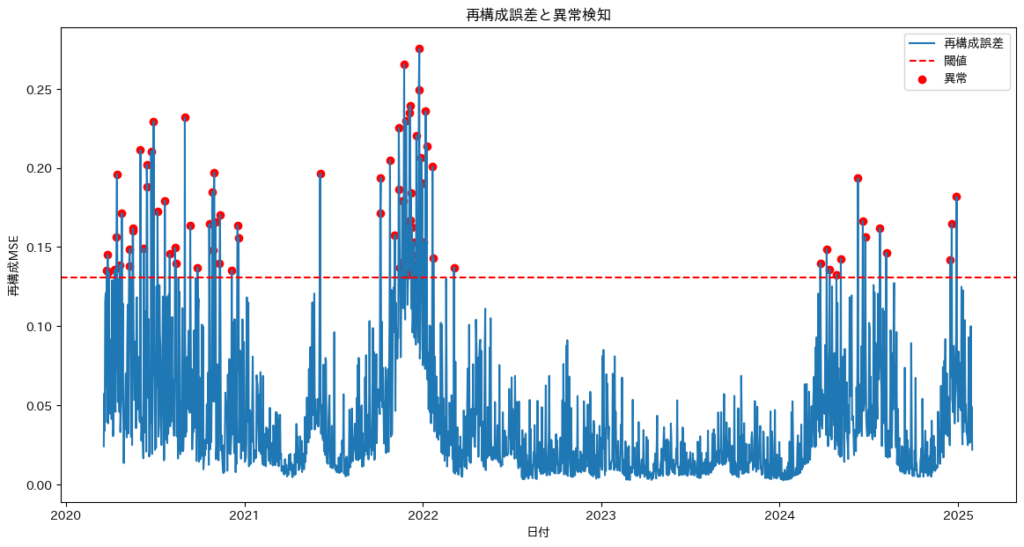

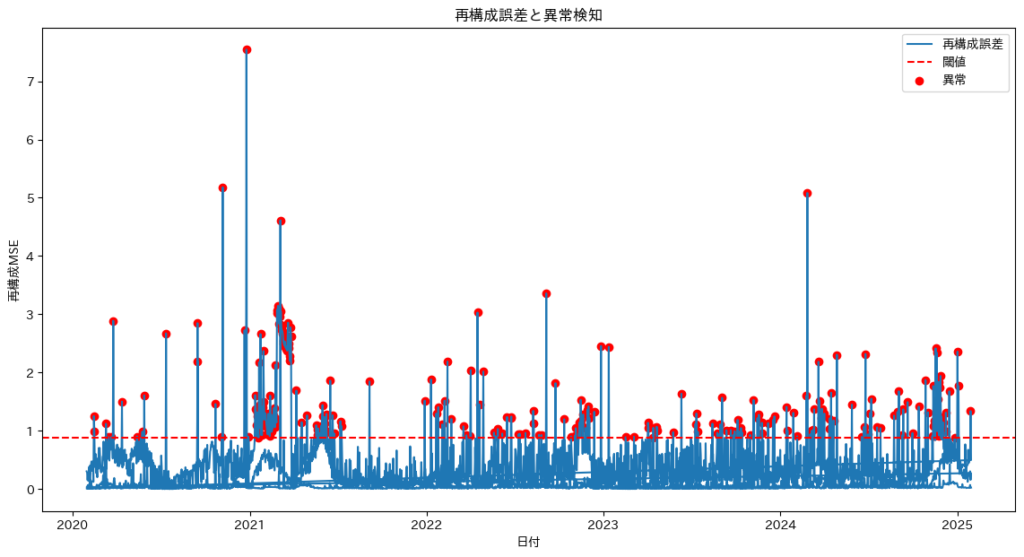

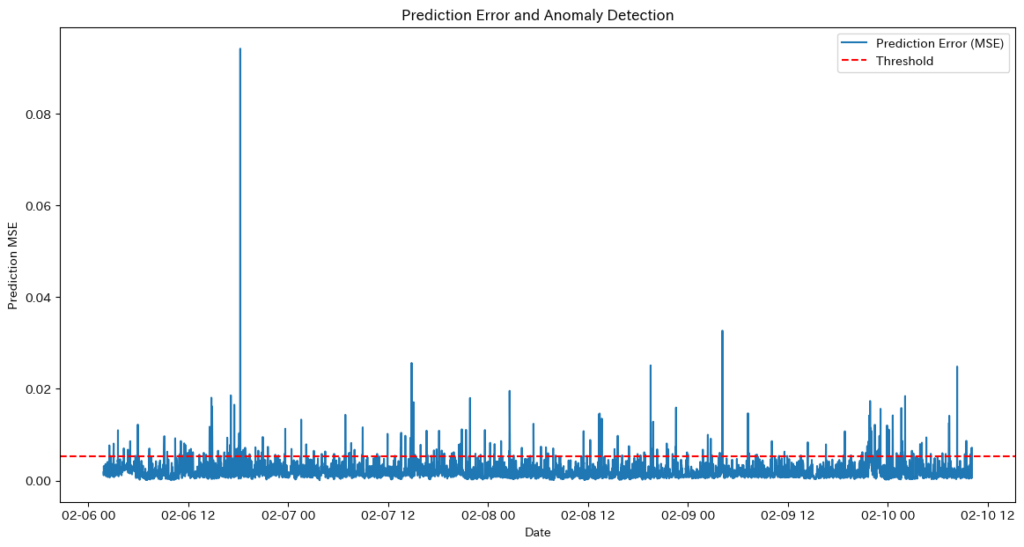

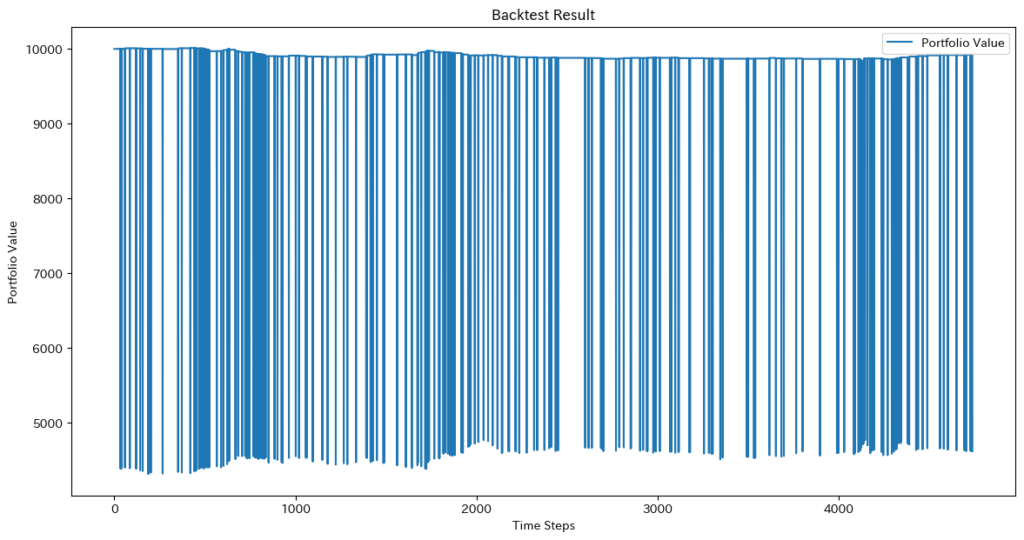

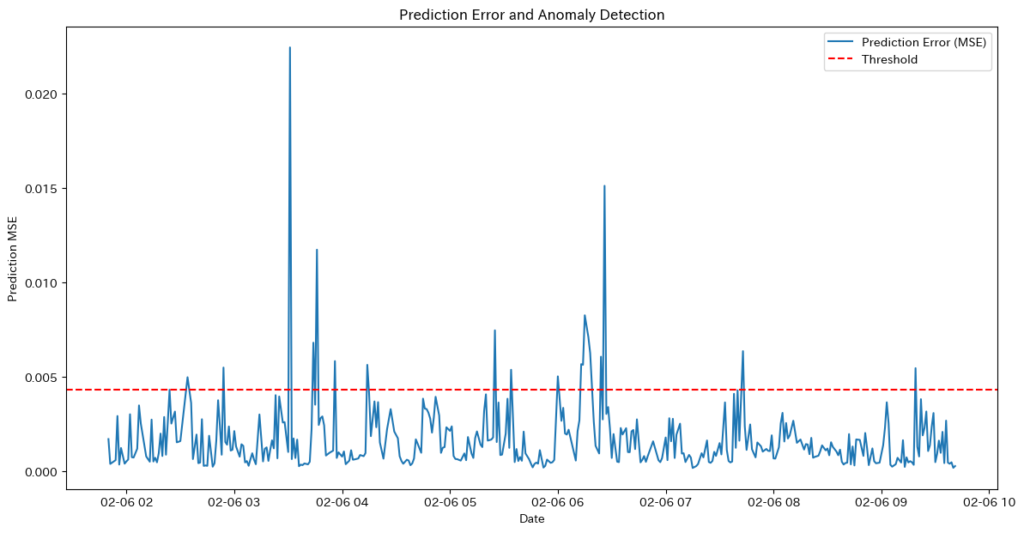

本記事では、特に実務で頻繁に活用されるノイズ除去、異常検知、予測 の3つに焦点を当て、それぞれの手法の特徴や活用例を詳しく解説していきます。

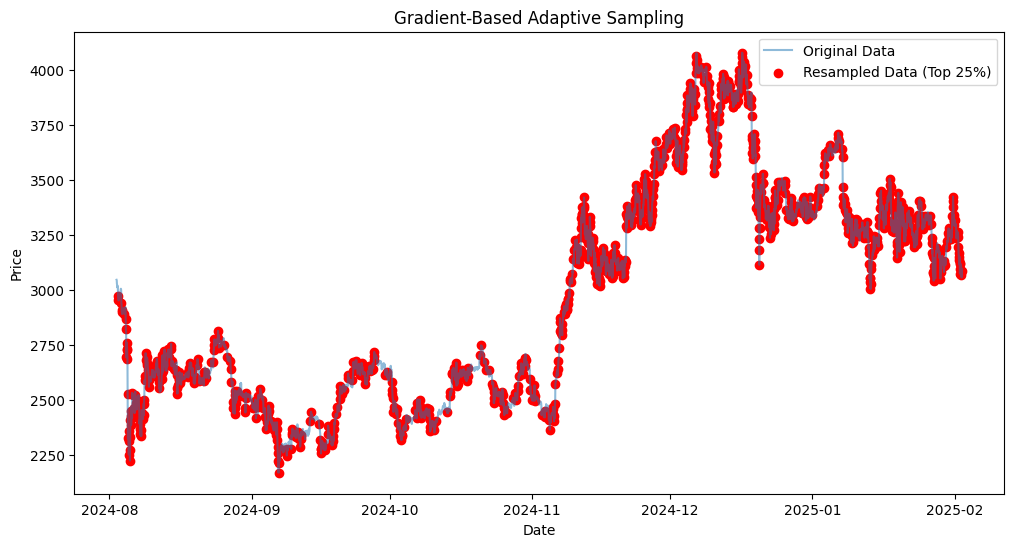

ノイズ除去

ノイズ除去は、金融市場の価格データをより正確に分析するために活用されます。具体的には、高頻度取引やボラティリティの高い銘柄の価格変動を平滑化し、時系列データ内の異常値を検出・排除します。また、短期的なニュースや無関係な変動の影響を抑えることで、実際のトレンドに基づいた精度の高い予測を可能にします。

なぜTransformerがノイズ除去に向いているのか?

- Self-Attention機構による重要な情報の選択

- TransformerのSelf-Attention機構は、時系列データ全体を俯瞰しながら、重要なポイント(例えば、過去の価格変動や特定のイベント)を動的に見つけ出し、データ間の依存関係をモデル化します。この過程で、関連性の低いデータ(ノイズ)は相対的に排除される仕組みが自然に備わっています。

- 並列処理で効率的な学習

- TransformerのSelf-Attention機構は、時系列データ全体を一括で処理することにより、ノイズに影響されにくい特徴量を効率よく抽出できます。これにより、長期的な依存関係を捉える際にも、短期的な変動によるノイズの影響を最小限に抑えることが可能です。

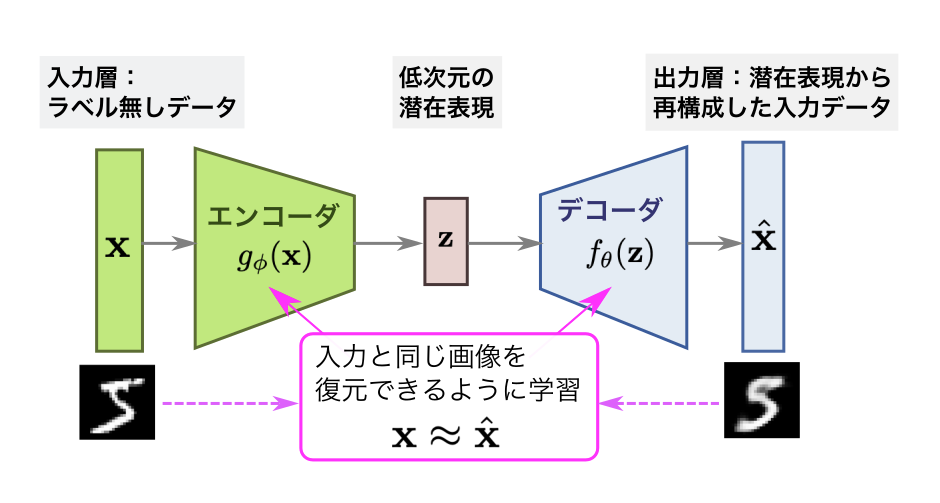

- フィルタリング機能の拡張性

- Transformerモデルにデノイジングオートエンコーダや自己教師付き学習を組み合わせることで、ノイズ除去能力をさらに高めることができます。このアプローチは、潜在空間でノイズと有用な情報を効果的に分離するのにも適しています。

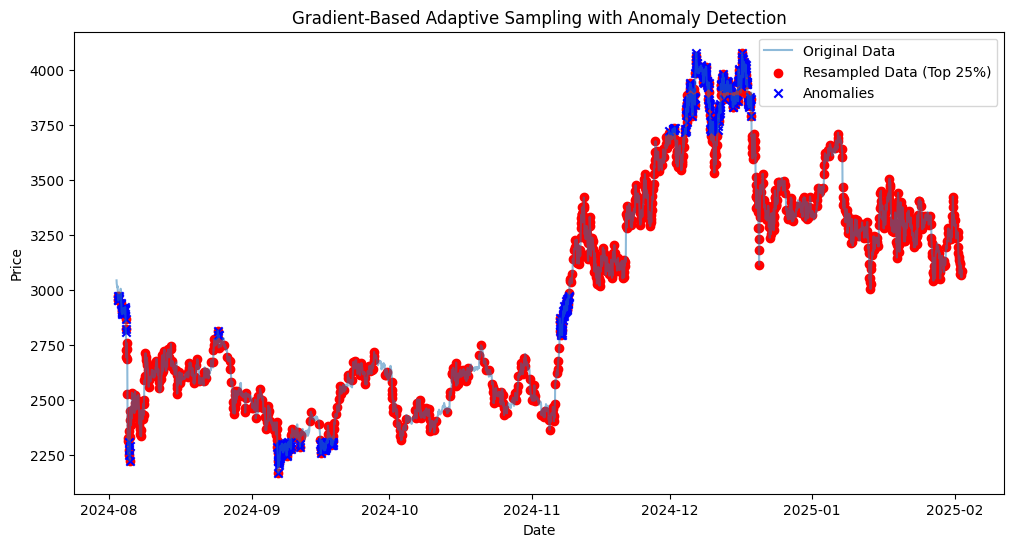

Transformerを使ったノイズ除去の実装

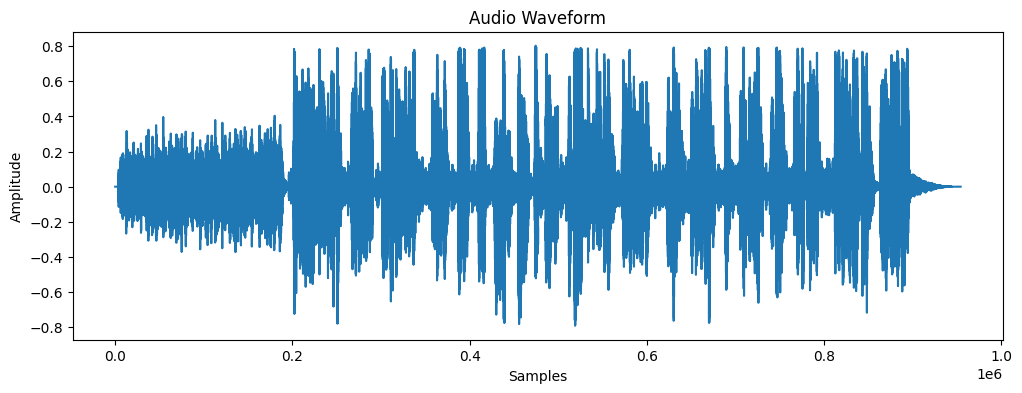

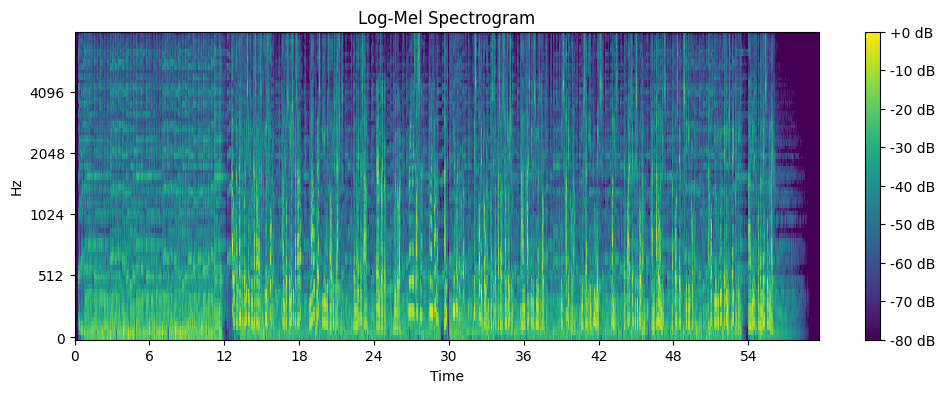

今回は前回紹介したデノイジングオートエンコーダを使ってTransformerモデルにデノイジングオートエンコーダを組み合わせたモデルの検証を行ってみます。今回もETHの金融時系列データとして、過去5日間の1分足データを使用します。

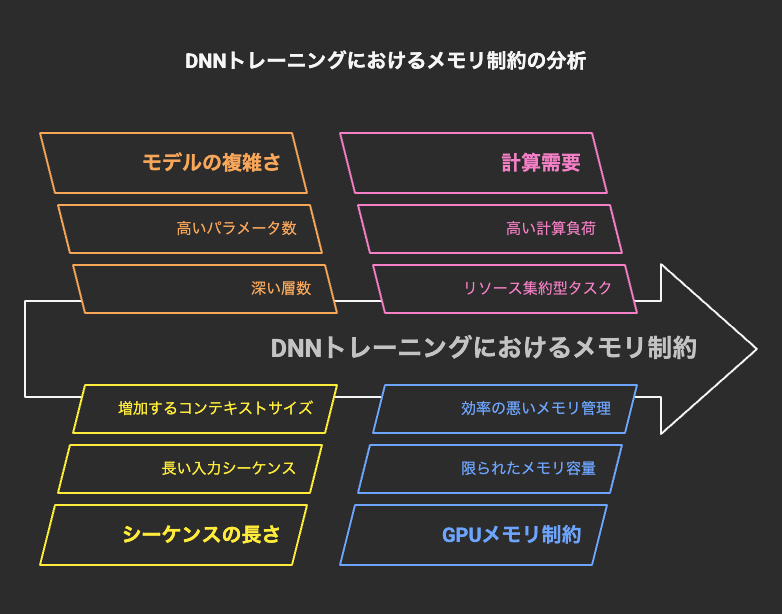

またTransformerをモデルに用いる際には注意点としてGPUのメモリ制限の問題をクリアする必要があります。

- GPUのメモリ制限の問題の理由

- Transformerを使う際の制限として、GPUのメモリ量が問題になる主な理由は、自己注意機構 (Self-Attention) の計算負荷がシーケンスの長さに対して二乗で増加することです。特に、金融時系列データのように長いシーケンスを扱う場合、メモリ消費が急激に増え、計算資源の制約が厳しくなります。

- この解決案については後で触れますので今回はここでTransformerを使えるようになるためにモデルの軽量化として低精度計算を用いてFP32(32-bit浮動小数点)をFP16(16-bit浮動小数点)に置き換えることでメモリ使用量を半減させることで対処してみようと思います。

- Transformerを使う際の制限として、GPUのメモリ量が問題になる主な理由は、自己注意機構 (Self-Attention) の計算負荷がシーケンスの長さに対して二乗で増加することです。特に、金融時系列データのように長いシーケンスを扱う場合、メモリ消費が急激に増え、計算資源の制約が厳しくなります。

デノイジングオートエンコーダ + LSTMを使ったモデルの実装

- まずは前回に紹介したLSTMモデルを使ったモデルと比較してみましょう。どのモデルに対しても過学習を予防する方法として、正規化にL2正則化とDropoutの手法を用いて検証を行います。このモデルはノイズ除去法としては優秀ではありますが、取引を行うロジックに使う場合は必ずしも良いとは言えないことがあります。

import yfinance as yf

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScaler

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import matplotlib.pyplot as plt

# データの取得

ticker = 'ETH-USD'

# 高頻度データの取得期間を有効な値に設定(例: 過去5日間)

data = yf.download(ticker, period='5d', interval='1m') # 1分足データ

# 特徴量の選択(Open, High, Low, Close, Volume)

features = ['Open', 'High', 'Low', 'Close', 'Volume']

data = data[features]

# データの標準化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

# ノイズの追加関数

def add_noise(data, noise_factor=0.2): # ノイズファクターを調整

noisy_data = data + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=data.shape)

return np.clip(noisy_data, -3, 3) # 値の範囲を制限

# ノイズ付きデータの作成

data_noisy = add_noise(data_scaled)

# シーケンスの作成(スライディングウィンドウ)

def create_sequences(data, seq_length):

xs = []

for i in range(len(data) - seq_length):

x = data[i:(i + seq_length)]

xs.append(x)

return np.array(xs)

seq_length = 30 # シーケンス長を調整

X_clean = create_sequences(data_scaled, seq_length)

X_noisy = create_sequences(data_noisy, seq_length)

# テンソルへの変換

X_clean_tensor = torch.tensor(X_clean, dtype=torch.float32)

X_noisy_tensor = torch.tensor(X_noisy, dtype=torch.float32)

# データローダーの作成

dataset = TensorDataset(X_noisy_tensor, X_clean_tensor)

train_loader = DataLoader(dataset, batch_size=128, shuffle=True)

# デノイジングオートエンコーダモデルの定義(LSTMを使用)

class DenoisingAutoencoder(nn.Module):

def __init__(self, input_dim, encoding_dim, dropout=0.1):

super(DenoisingAutoencoder, self).__init__()

self.encoder = nn.LSTM(input_dim, encoding_dim, batch_first=True)

self.decoder = nn.LSTM(encoding_dim, input_dim, batch_first=True)

self.dropout = nn.Dropout(dropout)

def forward(self, x):

x, _ = self.encoder(x)

x = self.dropout(x)

x, _ = self.decoder(x)

return x

# モデルのインスタンス化

input_dim = X_clean_tensor.shape[2]

encoding_dim = 32 # 隠れ層の次元数を調整

dropout = 0.1 # Dropout率

model = DenoisingAutoencoder(input_dim, encoding_dim, dropout)

# デバイスの設定

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)

# 損失関数とオプティマイザの定義

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001, weight_decay=1e-5) # L2正則化を追加

# 学習ループ

num_epochs = 30 # エポック数を調整

for epoch in range(num_epochs):

model.train()

epoch_loss = 0

for data in train_loader:

noisy_inputs, clean_inputs = data

noisy_inputs = noisy_inputs.to(device)

clean_inputs = clean_inputs.to(device)

optimizer.zero_grad()

outputs = model(noisy_inputs)

loss = criterion(outputs, clean_inputs)

loss.backward()

optimizer.step()

epoch_loss += loss.item()

avg_loss = epoch_loss / len(train_loader)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {avg_loss:.4f}')

# 再構成データの生成

model.eval()

with torch.no_grad():

reconstructed = model(X_noisy_tensor.to(device)).cpu().numpy()

# データの逆標準化

reconstructed_data = scaler.inverse_transform(reconstructed.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

original_data = scaler.inverse_transform(X_clean.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

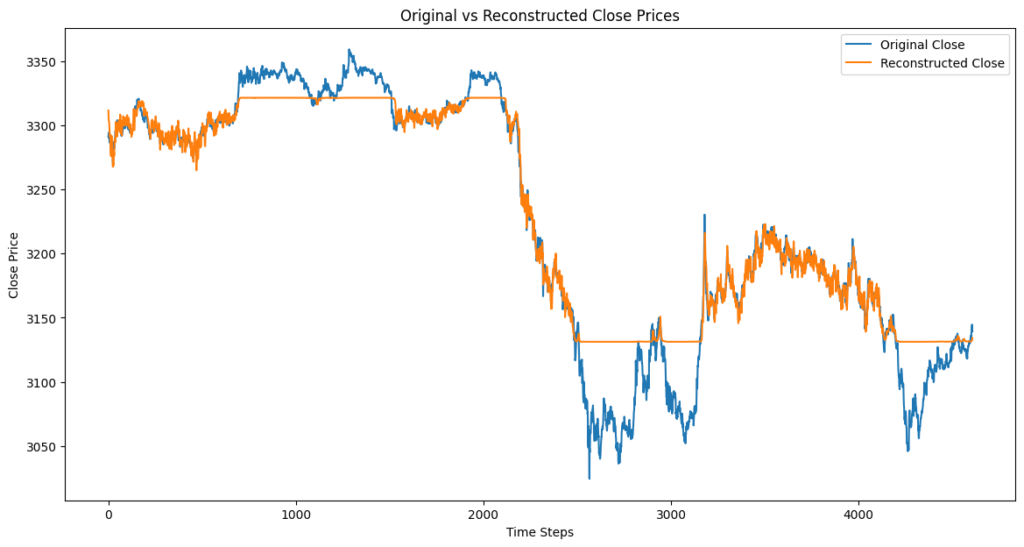

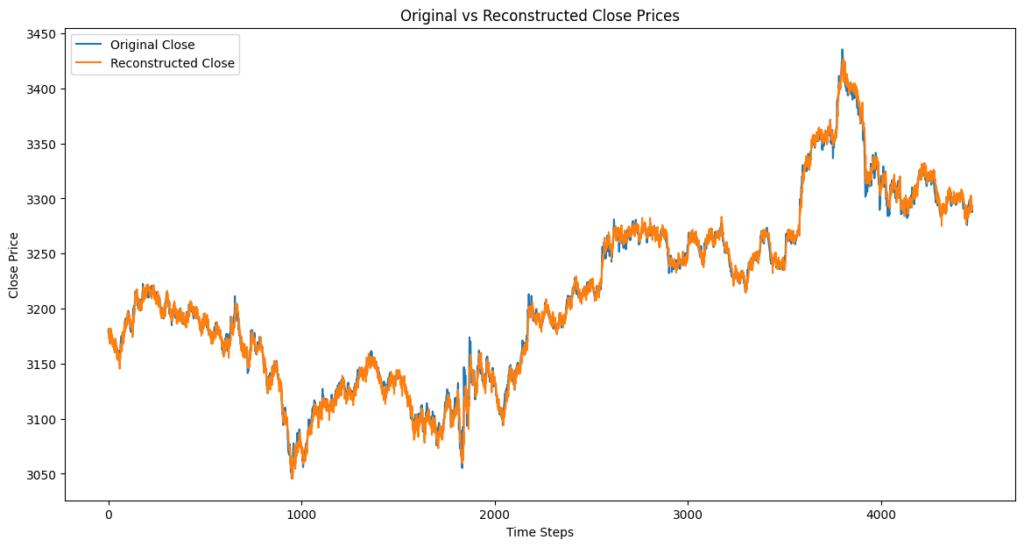

# 可視化(Close価格の比較)

plt.figure(figsize=(14, 7))

plt.plot(original_data[:, -1, 3], label='Original Close') # 最後のシーケンスのClose価格をプロット

plt.plot(reconstructed_data[:, -1, 3], label='Reconstructed Close') # 最後のシーケンスのClose価格をプロット

plt.title('Original vs Reconstructed Close Prices')

plt.xlabel('Time Steps')

plt.ylabel('Close Price')

plt.legend()

plt.show()

print("処理が完了しました")Epoch [29/30], Loss: 0.2531

Epoch [30/30], Loss: 0.2527

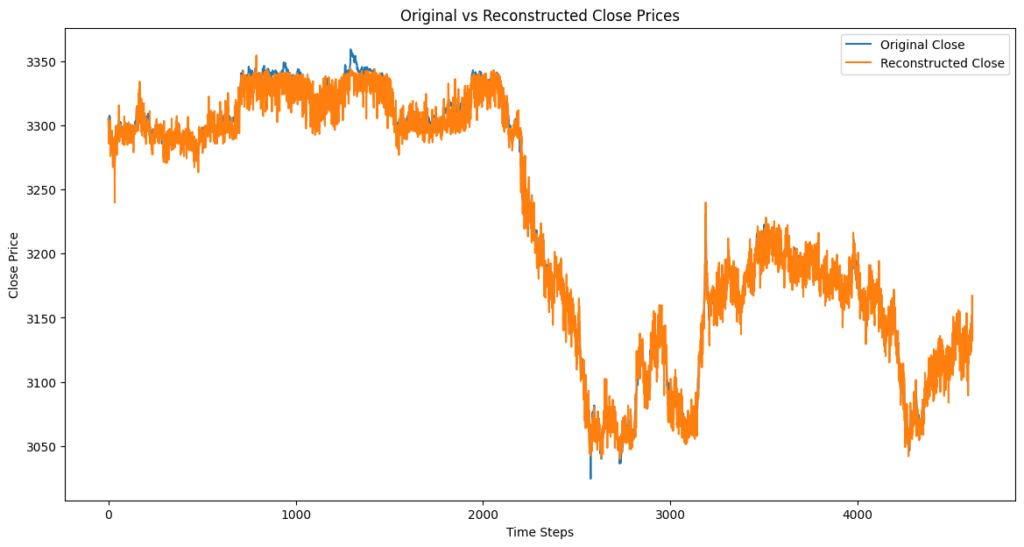

- このモデルの注意点と課題

- デノイジングオートエンコーダ+LSTMを用いたノイズ除去モデルでは、再構成されていないクローズ価格の部分は取引に使用できないことを表しています。

- 理由:スライディングウィンドウによるシーケンス作成時に、十分なデータが揃わない最初の部分はモデルの入力として使用されず、再構成もされないためです。また、逆標準化後のデータも不足部分はプロットされません。取引には再構成済みのクローズ価格が必要なため、未再構成部分での取引はできません。

- デノイジングオートエンコーダ+LSTMを用いたノイズ除去モデルでは、再構成されていないクローズ価格の部分は取引に使用できないことを表しています。

デノイジングオートエンコーダ + Transformer(エンコーダー)を使ったモデルの実装

- 次にTransformerを組み合わせたモデルを使ってみます。このモデルはGPUのメモリ制限上、パラメータを以下の条件に設定します。

- batch_size=16, embed_dim = 32, num_heads = 2

- エンコーダーのみを使う理由:

- デノイジングオートエンコーダーは、Transformerのエンコーダー部分だけを使って特徴を抽出し、ノイズ除去(復元)を行うモデルです。デコーダーは計算コストが高く、GPUメモリの制約もあるため、本モデルでは省略しています。

- また、このモデルの目的は 時系列データの復元であり、「未来の値を生成する」のではなく「過去の値を復元する」ことに特化しているため、エンコーダーのみで十分に機能します。

import yfinance as yf

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import mean_squared_error, mean_absolute_error

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import matplotlib.pyplot as plt

from torch.cuda.amp import autocast, GradScaler

# データの取得

ticker = 'ETH-USD'

data = yf.download(ticker, period='5d', interval='1m') # 1分足データ

# 特徴量の選択(Open, High, Low, Close, Volume)

features = ['Open', 'High', 'Low', 'Close', 'Volume']

data = data[features]

# データの標準化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

# ノイズの追加関数

def add_noise(data, noise_factor=0.2):

noisy_data = data + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=data.shape)

return np.clip(noisy_data, -3, 3) # 値の範囲を制限

# ノイズ付きデータの作成

data_noisy = add_noise(data_scaled)

# シーケンスの作成(スライディングウィンドウ)

def create_sequences(data, seq_length):

xs = []

for i in range(len(data) - seq_length):

x = data[i:(i + seq_length)]

xs.append(x)

return np.array(xs)

seq_length = 20 # シーケンス長を調整

X_clean = create_sequences(data_scaled, seq_length)

X_noisy = create_sequences(data_noisy, seq_length)

# テンソルへの変換

X_clean_tensor = torch.tensor(X_clean, dtype=torch.float32)

X_noisy_tensor = torch.tensor(X_noisy, dtype=torch.float32)

# データローダーの作成

dataset = TensorDataset(X_noisy_tensor, X_clean_tensor)

train_loader = DataLoader(dataset, batch_size=16, shuffle=True) # バッチサイズをさらに小さく

# デノイジングオートエンコーダモデルの定義(Transformerを使用)

class DenoisingTransformer(nn.Module):

def __init__(self, input_dim, embed_dim, num_heads, num_layers, seq_length, dropout=0.1):

super(DenoisingTransformer, self).__init__()

self.embedding = nn.Linear(input_dim, embed_dim)

self.pos_encoding = nn.Parameter(torch.zeros(1, seq_length, embed_dim))

encoder_layer = nn.TransformerEncoderLayer(d_model=embed_dim, nhead=num_heads, dropout=dropout)

self.transformer = nn.TransformerEncoder(encoder_layer, num_layers=num_layers)

self.fc_out = nn.Linear(embed_dim, input_dim)

self.dropout = nn.Dropout(dropout)

def forward(self, x):

x = self.embedding(x) + self.pos_encoding

x = self.dropout(x)

x = self.transformer(x)

x = self.fc_out(x)

return x

# モデルのインスタンス化

input_dim = X_clean_tensor.shape[2]

embed_dim = 32 # 埋め込み次元数を減らす

num_heads = 2 # ヘッド数を減らす

num_layers = 2

dropout = 0.1 # Dropout率

model = DenoisingTransformer(input_dim, embed_dim, num_heads, num_layers, seq_length, dropout)

# デバイスの設定

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)

# 損失関数とオプティマイザの定義

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001, weight_decay=1e-5) # L2正則化を追加

# 自動混合精度の設定

grad_scaler = GradScaler()

# 学習ループ

num_epochs = 30 # エポック数を調整

for epoch in range(num_epochs):

model.train()

epoch_loss = 0

for data in train_loader:

noisy_inputs, clean_inputs = data

noisy_inputs = noisy_inputs.to(device)

clean_inputs = clean_inputs.to(device)

optimizer.zero_grad()

with autocast(): # FP16を自動適用

outputs = model(noisy_inputs)

loss = criterion(outputs, clean_inputs)

grad_scaler.scale(loss).backward()

grad_scaler.step(optimizer)

grad_scaler.update()

epoch_loss += loss.item()

avg_loss = epoch_loss / len(train_loader)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {avg_loss:.4f}')

# 再構成データの生成

model.eval()

with torch.no_grad():

reconstructed = model(X_noisy_tensor.to(device)).cpu().numpy()

# データの逆標準化

reconstructed_data = scaler.inverse_transform(reconstructed.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

original_data = scaler.inverse_transform(X_clean.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

# 可視化(Close価格の比較)

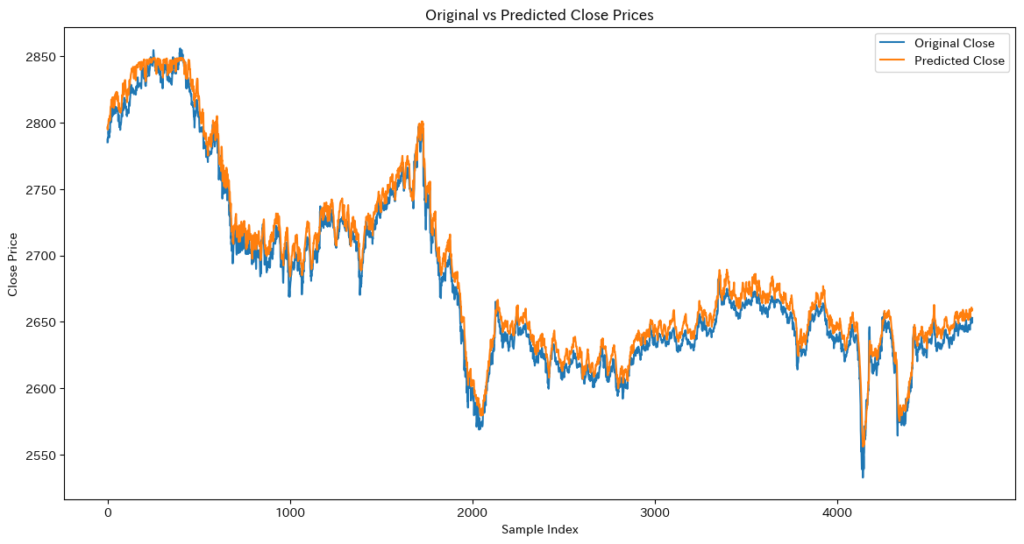

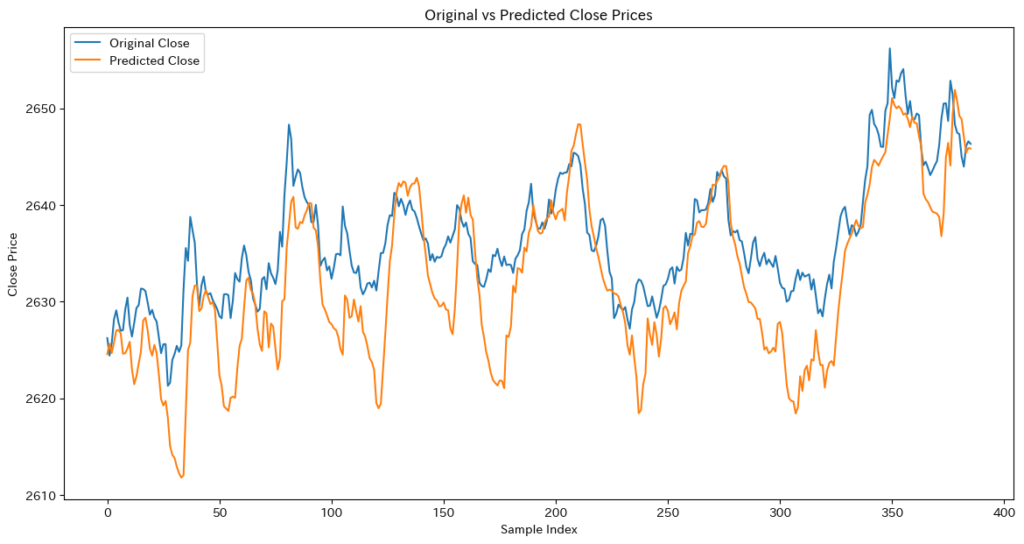

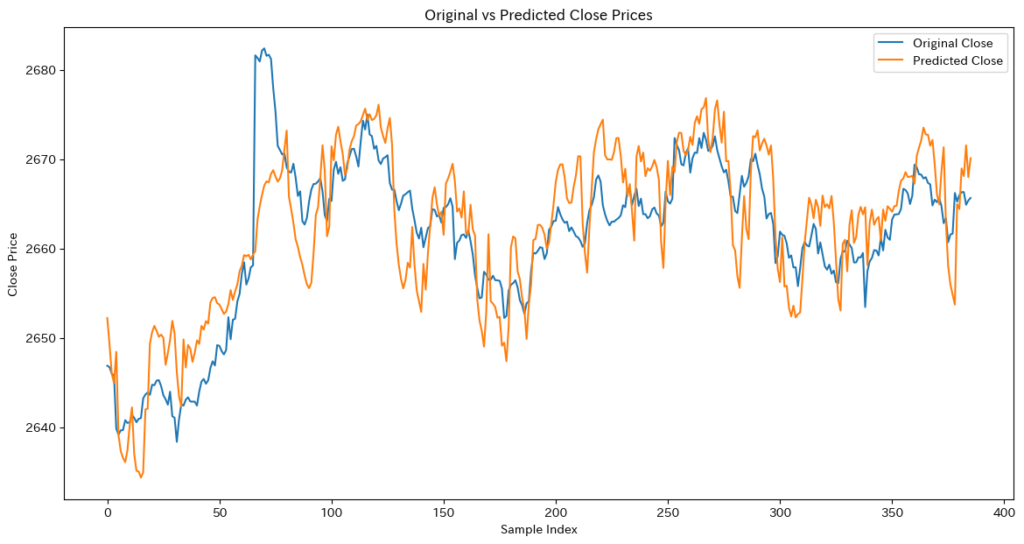

plt.figure(figsize=(14, 7))

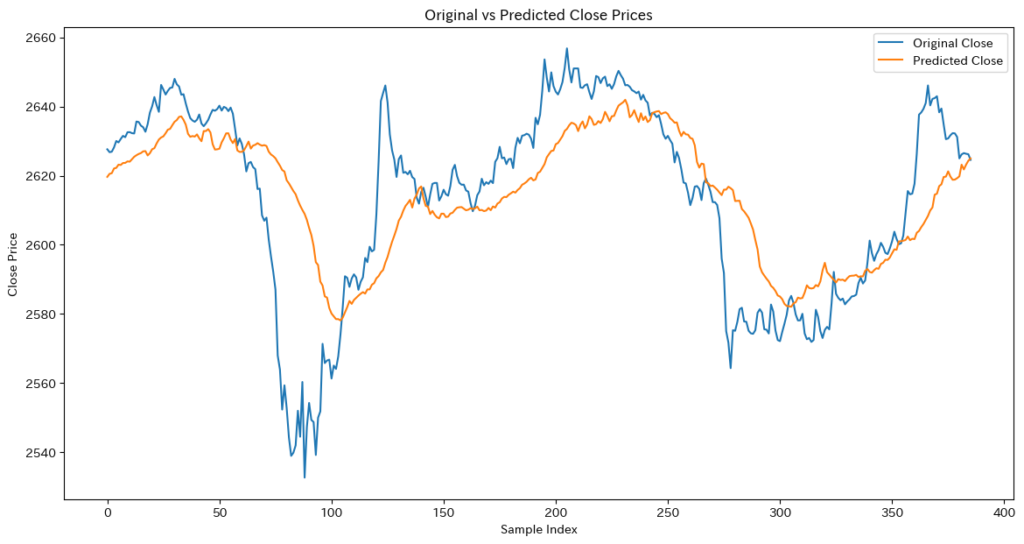

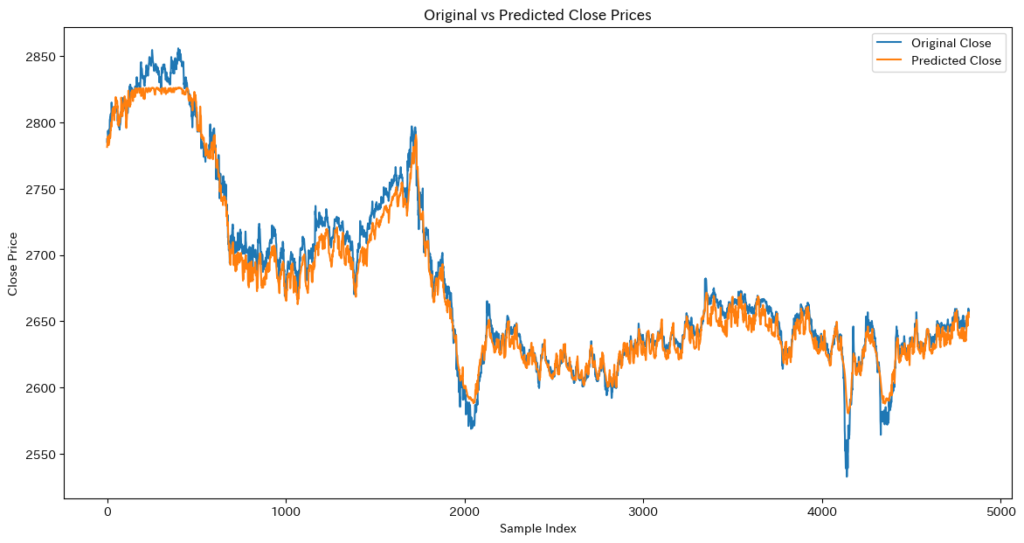

plt.plot(original_data[:, -1, 3], label='Original Close') # 最後のシーケンスのClose価格をプロット

plt.plot(reconstructed_data[:, -1, 3], label='Reconstructed Close') # 最後のシーケンスのClose価格をプロット

plt.title('Original vs Reconstructed Close Prices')

plt.xlabel('Time Steps')

plt.ylabel('Close Price')

plt.legend()

plt.show()

print("処理が完了しました")Epoch [29/30], Loss: 0.0246

Epoch [30/30], Loss: 0.0245

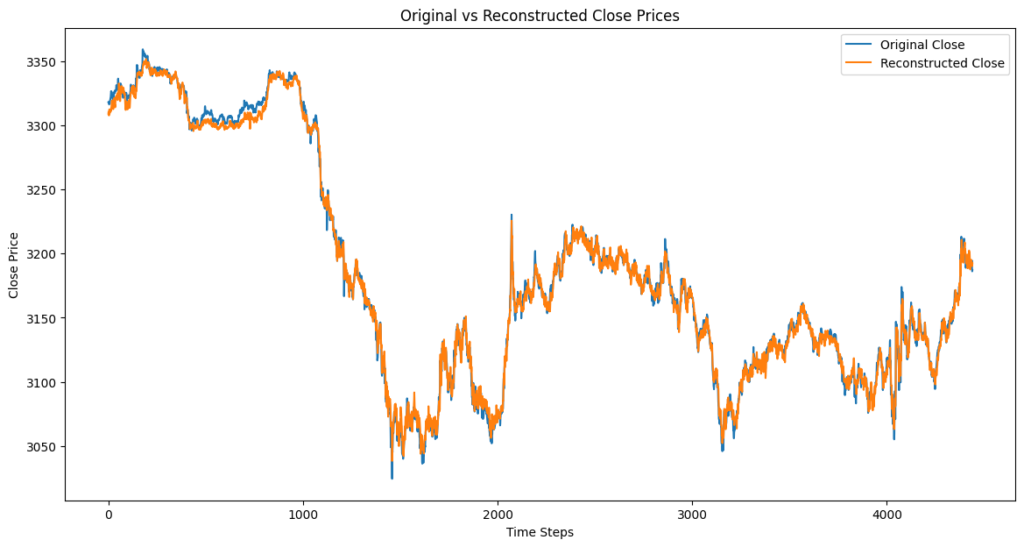

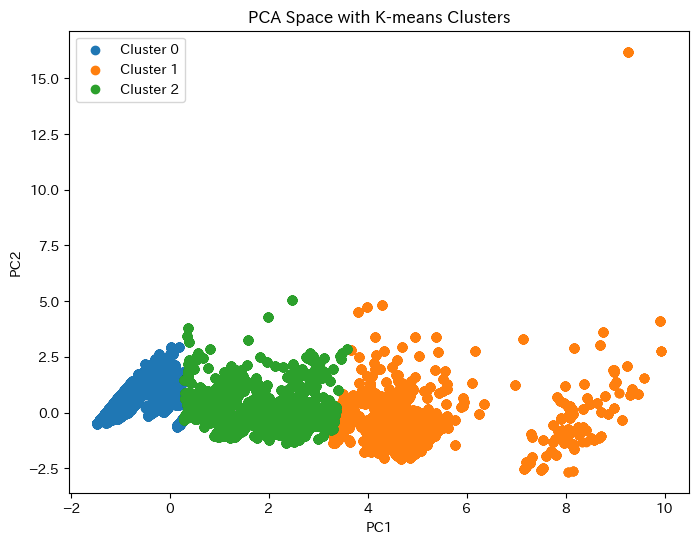

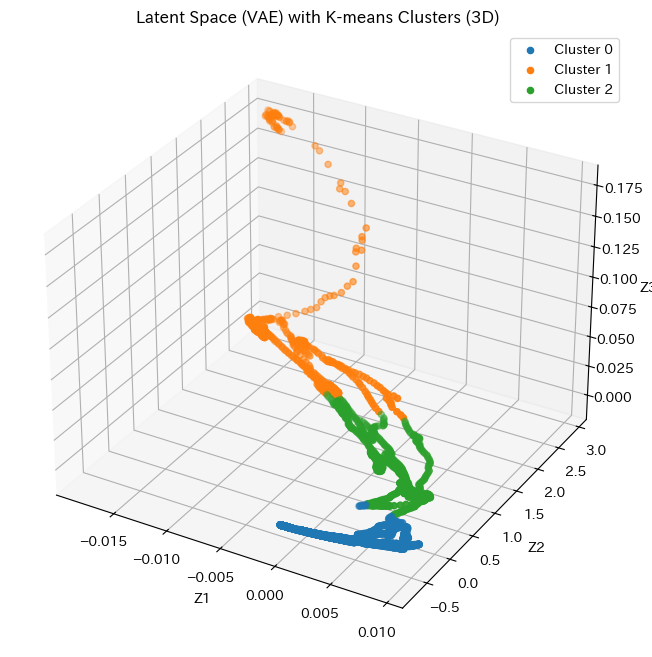

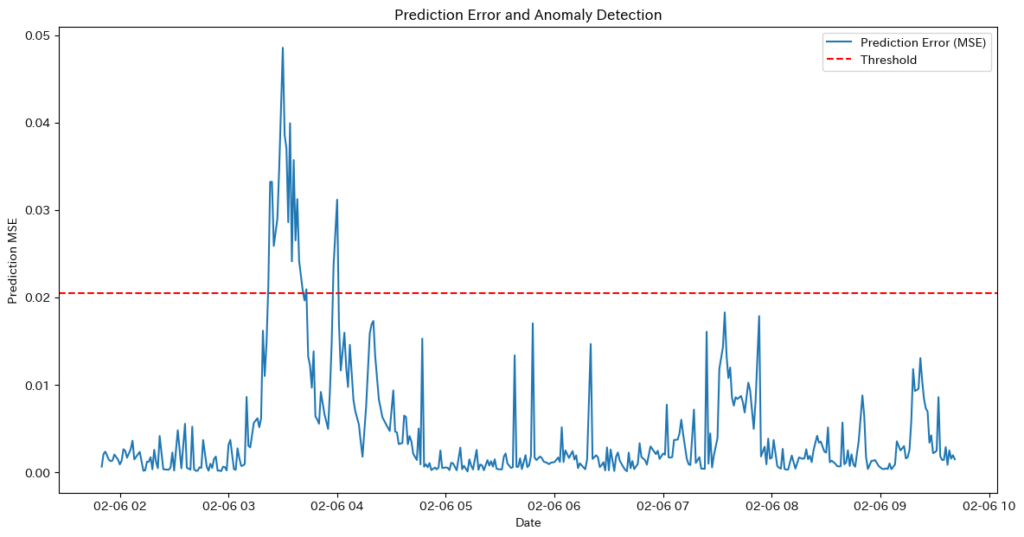

- deno+Transformerモデルの特徴

- 短期的な変動は忠実に再現され、細かいノイズを除去しつつオリジナルデータに近い形で復元できている。ただし、長期的なトレンドの捉え方にはやや弱さがある。

- 課題

- 価格の急変動をそのまま反映しすぎることがある

- ノイズが十分に取り除かれない場合もある

先ほどのデノイジングオートエンコーダ+LSTMとの違いを見てみましょう。

| 比較項目 | Denoising Autoencoder + Transformer | Denoising Autoencoder + LSTM |

|---|---|---|

| ノイズ除去の仕方 | ノイズを滑らかに除去し、局所的な変動もある程度再現する | ノイズを強く除去し、短期的な変動を抑えてしまう |

| 再構成の精度 | 細かい変動をある程度再現 | 階段状の形になり、価格変化が遅れる傾向 |

| 価格変動の追随 | 急激な変化にも比較的対応できる | 過去のデータを重視しすぎて変動をスムーズに反映できない |

| 取引の安定性 | ノイズを除去しつつ、適度に変動を捉えられるため適応性が高い | 変動が遅れて反映されるため、エントリー・エグジットのタイミングがずれやすい |

結果:

- この二つのモデルの場合は再現性の問題によりTransformerモデルを組み合わせたモデルの方がノイズ除去に優れていることがわかります。また取引回数においてもTransformerモデルの方が優位性があることがわかります。

デノイジングオートエンコーダ + Transformer + LSTMを使ったモデルの実装

- 先ほどと同じパラメータを使って同じモデルにLSTMを組み合わせてみます。

- エンコーダーの省略理由に関しては先ほどのデノイジングオートエンコーダ + Transformer で説明を行なっていますので確認してください。

- 更にLSTMを追加することで、時系列の長期的な依存関係を補完できる ため、エンコーダーだけで十分な性能を発揮することができます。

import yfinance as yf

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScaler

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import matplotlib.pyplot as plt

from torch.cuda.amp import autocast, GradScaler

# データの取得

ticker = 'ETH-USD'

data = yf.download(ticker, period='5d', interval='1m') # 1分足データ

# 特徴量の選択(Open, High, Low, Close, Volume)

features = ['Open', 'High', 'Low', 'Close', 'Volume']

data = data[features]

# データの標準化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

# ノイズの追加関数

def add_noise(data, noise_factor=0.2):

noisy_data = data + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=data.shape)

return np.clip(noisy_data, -3, 3) # 値の範囲を制限

# ノイズ付きデータの作成

data_noisy = add_noise(data_scaled)

# シーケンスの作成(スライディングウィンドウ)

def create_sequences(data, seq_length):

xs = []

for i in range(len(data) - seq_length):

x = data[i:(i + seq_length)]

xs.append(x)

return np.array(xs)

seq_length = 20 # シーケンス長を調整

X_clean = create_sequences(data_scaled, seq_length)

X_noisy = create_sequences(data_noisy, seq_length)

# テンソルへの変換

X_clean_tensor = torch.tensor(X_clean, dtype=torch.float32)

X_noisy_tensor = torch.tensor(X_noisy, dtype=torch.float32)

# データローダーの作成

dataset = TensorDataset(X_noisy_tensor, X_clean_tensor)

train_loader = DataLoader(dataset, batch_size=16, shuffle=True) # バッチサイズをさらに小さく

# デノイジングオートエンコーダモデルの定義(Transformer + LSTMを使用)

class DenoisingAutoencoder(nn.Module):

def __init__(self, input_dim, embed_dim, num_heads, num_layers, lstm_hidden_dim, seq_length, dropout=0.1):

super(DenoisingAutoencoder, self).__init__()

self.embedding = nn.Linear(input_dim, embed_dim)

self.pos_encoding = nn.Parameter(torch.zeros(1, seq_length, embed_dim))

encoder_layer = nn.TransformerEncoderLayer(d_model=embed_dim, nhead=num_heads, dropout=dropout)

self.transformer = nn.TransformerEncoder(encoder_layer, num_layers=num_layers)

self.lstm = nn.LSTM(embed_dim, lstm_hidden_dim, batch_first=True)

self.fc_out = nn.Linear(lstm_hidden_dim, input_dim)

self.dropout = nn.Dropout(dropout)

def forward(self, x):

x = self.embedding(x) + self.pos_encoding

x = self.dropout(x)

x = self.transformer(x)

x, _ = self.lstm(x)

x = self.fc_out(x)

return x

# モデルのインスタンス化

input_dim = X_clean_tensor.shape[2]

embed_dim = 32 # 埋め込み次元数

num_heads = 2 # ヘッド数

num_layers = 2

lstm_hidden_dim = 64 # LSTMの隠れ層次元数

dropout = 0.1 # Dropout率

model = DenoisingAutoencoder(input_dim, embed_dim, num_heads, num_layers, lstm_hidden_dim, seq_length, dropout)

# デバイスの設定

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)

# 損失関数とオプティマイザの定義

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001, weight_decay=1e-5) # L2正則化を追加

# 自動混合精度の設定

grad_scaler = GradScaler()

# 学習ループ

num_epochs = 30 # エポック数を調整

for epoch in range(num_epochs):

model.train()

epoch_loss = 0

for data in train_loader:

noisy_inputs, clean_inputs = data

noisy_inputs = noisy_inputs.to(device)

clean_inputs = clean_inputs.to(device)

optimizer.zero_grad()

with autocast(): # FP16を自動適用

outputs = model(noisy_inputs)

loss = criterion(outputs, clean_inputs)

grad_scaler.scale(loss).backward()

grad_scaler.step(optimizer)

grad_scaler.update()

epoch_loss += loss.item()

avg_loss = epoch_loss / len(train_loader)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {avg_loss:.4f}')

# 再構成データの生成

model.eval()

with torch.no_grad():

reconstructed = model(X_noisy_tensor.to(device)).cpu().numpy()

# データの逆標準化

reconstructed_data = scaler.inverse_transform(reconstructed.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

original_data = scaler.inverse_transform(X_clean.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

# 可視化(Close価格の比較)

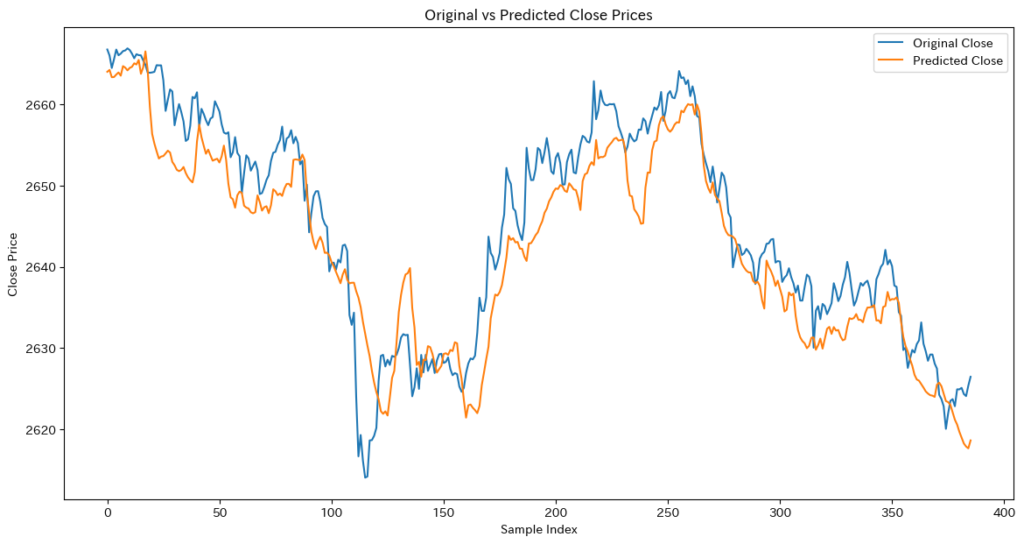

plt.figure(figsize=(14, 7))

plt.plot(original_data[:, -1, 3], label='Original Close') # 最後のシーケンスのClose価格をプロット

plt.plot(reconstructed_data[:, -1, 3], label='Reconstructed Close') # 最後のシーケンスのClose価格をプロット

plt.title('Original vs Reconstructed Close Prices')

plt.xlabel('Time Steps')

plt.ylabel('Close Price')

plt.legend()

plt.show()

print("処理が完了しました")Epoch [29/30], Loss: 0.0094

Epoch [30/30], Loss: 0.0101

- deno+Transformer+LSTMモデルの特徴

- 全体のトレンドは滑らかで、ノイズもしっかり除去されている。

- 課題

- 短期的な価格変動が滑らかになりすぎており、細かい動きを捉えにくい。過去のデータを重視しすぎることで、急な価格変動への対応が遅れる可能性がある。取引に活用する際は、この即応性の低下に注意が必要。

先ほどのデノイジングオートエンコーダ+ Transformerとの違いを見てみましょう。

| 項目 | deno+Transformer+LSTM | deno+Transformer |

|---|---|---|

| 短期的なノイズ除去 | 過度に平滑化される可能性がある | ノイズを除去しつつ短期変動を再現 |

| 長期的なトレンド把握 | LSTMがあるため精度が高い | Transformer単体では学習がやや難しい |

| 価格変動への適応性 | 長期トレンドを捉えつつ短期変動もある程度追随 | 短期的な変動をより細かく捉えるが長期的な変動は見落としがち |

| リアルタイム性 | 計算コストが高いため遅れが生じやすい | 処理速度が速い |

結果:目的によって異なるが、一般的には Transformer+LSTM の方がノイズ除去能力に優れている。

- ✅ 短期トレードやボラティリティの高い市場ではTransformerのみが即応性に優れ、長期トレードや安定したシグナルを求める場合はTransformer+LSTMがノイズ耐性と予測の信頼性に優位性を持つ。

最適な用途

- 長期投資・スイングトレード → Transformer+LSTM(ノイズを除去しつつ大きな流れを捉えられる)

- デイトレード・スキャルピング → Transformerのみ(短期的な変動をキャッチしやすい)

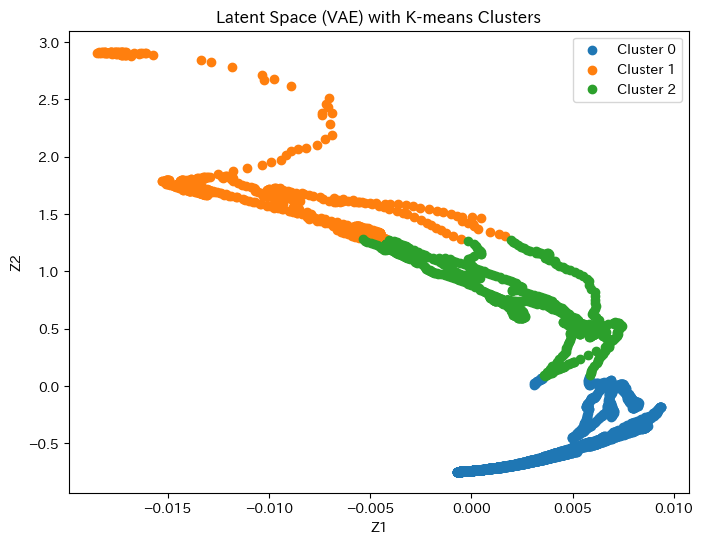

Multi-Head Latent Attention(MLA)モデルの実装

次にデノイジングオートエンコーダとTransformerのMulti-Head Attentionの改良型のMulti-Head Latent Attentionを使ってノイズ除去を行います。このモデルはTransformerモデルではあるのですが、MLA単体でデノイジングオートエンコーダと組み合わせてノイズ除去が可能なモデルです。

まずは簡単にMLAの紹介をしてから実装を行うことにします。

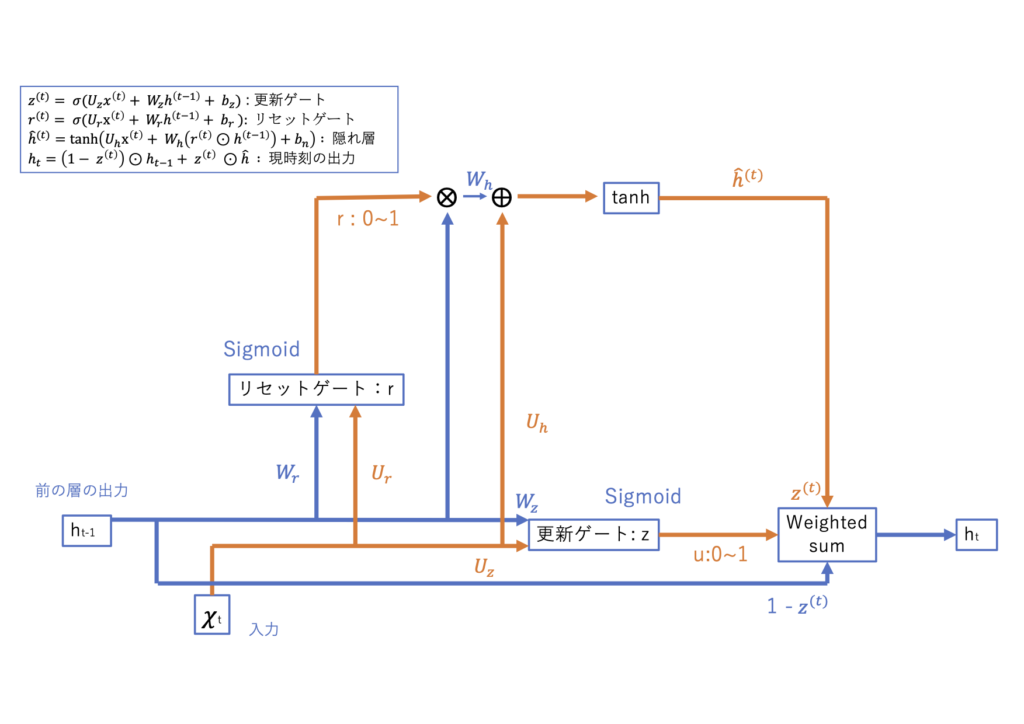

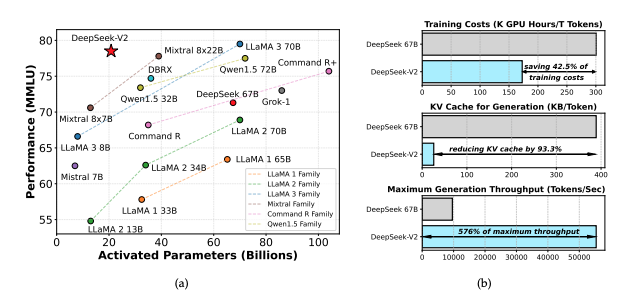

MLAは、DeepSeek-V2モデルに導入された新しいアテンション機構で、従来のマルチヘッドアテンション(MHA)と比べてKVキャッシュのサイズを大幅に削減し、推論の効率を向上させることを目的としています。

特徴とTransformerとの関係性

- MLAはMHAの変種として設計され、大規模モデルのKVキャッシュのメモリボトルネックを解消することで、Transformerのスケーラビリティと効率性を向上させます。特に推論時のメモリ消費が課題となるモデルに対して、KVキャッシュの圧縮によりGPUメモリ使用量を5–13%に削減し、高効率な推論を可能にする技術です。

論文:『DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model』

- 計算効率とスケーラビリティの両立

- DeepSeek-V2は2360億パラメータのMoEモデルでありながら、1トークンごとに210億パラメータのみを活性化することで、計算負荷を抑えつつ高精度な推論を実現。さらに、新技術Multi-Head Latent Attention (MLA) を採用し、推論時のキー・バリュー(KV)キャッシュを削減。これにより、長いコンテキスト(128Kトークン)でもメモリ効率の良い処理が可能に。計算コストを抑えつつ、強力な性能を維持する設計が特徴の次世代LLM。

- 高精度な多言語対応と汎用性

- DeepSeek-V2は英語・中国語の両方で最高レベルの性能を達成し、特に中国語の理解力はLLaMA3 70Bを超える。事前学習でSFT(教師ありデータ)を使用せず、データ依存を抑えた柔軟な知識獲得を実現。さらに、強化学習(RL)による最適化で数学・プログラミングタスクでも高精度を発揮。これにより、特定用途に縛られない汎用的な適用が可能なLLMとして、多言語理解と高度なタスク処理の両立を実現している。

deno+MLAの実装:

- MLAにより、キーとバリューを低次元の潜在ベクトルに圧縮することで、メモリ使用量を大幅に削減します。これにより、推論時のメモリ消費を抑え、効率的なモデル運用を可能にしています。

ライブラリのインポート

import yfinance as yf

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import mean_squared_error, mean_absolute_error

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import matplotlib.pyplot as plt

from torch.cuda.amp import autocast, GradScalerデータの取得と前処理

# データの取得

ticker = 'ETH-USD'

data = yf.download(ticker, period='5d', interval='1m') # 1分足データ

# 特徴量の選択(Open, High, Low, Close, Volume)

features = ['Open', 'High', 'Low', 'Close', 'Volume']

data = data[features]

# データの標準化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)ノイズの追加

# ノイズの追加関数

def add_noise(data, noise_factor=0.2):

noisy_data = data + noise_factor * np.random.normal(loc=0.0, scale=1.0, size=data.shape)

return np.clip(noisy_data, -3, 3) # 値の範囲を制限

# ノイズ付きデータの作成

data_noisy = add_noise(data_scaled)add_noise:データにノイズを追加する関数。ノイズの強さはnoise_factorで調整します。np.clip:ノイズの範囲を制限します。

シーケンスの作成

# シーケンスの作成(スライディングウィンドウ)

def create_sequences(data, seq_length):

xs = []

for i in range(len(data) - seq_length):

x = data[i:(i + seq_length)]

xs.append(x)

return np.array(xs)

seq_length = 20 # シーケンス長を調整

X_clean = create_sequences(data_scaled, seq_length)

X_noisy = create_sequences(data_noisy, seq_length)データのテンソル変換とデータローダーの作成

# テンソルへの変換

X_clean_tensor = torch.tensor(X_clean, dtype=torch.float32)

X_noisy_tensor = torch.tensor(X_noisy, dtype=torch.float32)

# データローダーの作成

dataset = TensorDataset(X_noisy_tensor, X_clean_tensor)

train_loader = DataLoader(dataset, batch_size=16, shuffle=True) DataLoader:データローダーを作成し、バッチサイズとシャッフルを設定します。

Multi-head Latent Attention(MLA)層の定義

class MultiHeadLatentAttention(nn.Module):

def __init__(self, embed_dim, num_heads):

super(MultiHeadLatentAttention, self).__init__()

self.num_heads = num_heads

self.embed_dim = embed_dim

self.head_dim = embed_dim // num_heads

assert self.head_dim * num_heads == embed_dim, "embed_dim must be divisible by num_heads"

self.query = nn.Linear(embed_dim, embed_dim)

self.key = nn.Linear(embed_dim, embed_dim)

self.value = nn.Linear(embed_dim, embed_dim)

self.out = nn.Linear(embed_dim, embed_dim)

def forward(self, x):

batch_size, seq_length, embed_dim = x.size()

q = self.query(x).view(batch_size, seq_length, self.num_heads, self.head_dim).transpose(1, 2)

k = self.key(x).view(batch_size, seq_length, self.num_heads, self.head_dim).transpose(1, 2)

v = self.value(x).view(batch_size, seq_length, self.num_heads, self.head_dim).transpose(1, 2)

scores = torch.matmul(q, k.transpose(-2, -1)) / np.sqrt(self.head_dim)

attn = torch.softmax(scores, dim=-1)

context = torch.matmul(attn, v).transpose(1, 2).contiguous().view(batch_size, seq_length, embed_dim)

out = self.out(context)

return outMLA層は、入力データの各部分間の関係を学習し、再構成精度を向上させるために使用されます。

デノイジングオートエンコーダモデルの定義(MLAを使用)

class DenoisingTransformer(nn.Module):

def __init__(self, input_dim, embed_dim, num_heads, num_layers, seq_length, dropout=0.1):

super(DenoisingTransformer, self).__init__()

self.embedding = nn.Linear(input_dim, embed_dim)

self.pos_encoding = nn.Parameter(torch.zeros(1, seq_length, embed_dim))

self.layers = nn.ModuleList([

nn.Sequential(

MultiHeadLatentAttention(embed_dim, num_heads),

nn.Dropout(dropout),

nn.LayerNorm(embed_dim)

) for _ in range(num_layers)

])

self.fc_out = nn.Linear(embed_dim, input_dim)

def forward(self, x):

x = self.embedding(x) + self.pos_encoding

for layer in self.layers:

x = layer(x)

x = self.fc_out(x)

return xlayers:MLA層、ドロップアウト、LayerNormを含む層を定義します。forward:前方伝播を定義します。埋め込みと位置エンコーディングを加えた後、各層を通過させ、最終的な出力を得ます。

モデルのインスタンス化とデバイスの設定

# モデルのインスタンス化

input_dim = X_clean_tensor.shape[2]

embed_dim = 32 # 埋め込み次元数を減らす

num_heads = 2 # ヘッド数を減らす

num_layers = 2

dropout = 0.1 # Dropout率

model = DenoisingTransformer(input_dim, embed_dim, num_heads, num_layers, seq_length, dropout)

# デバイスの設定

device = torch.device("mps" if torch.backends.mps.is_available() else "cpu")

model.to(device)損失関数とオプティマイザの定義

# 損失関数とオプティマイザの定義

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001, weight_decay=1e-5) # L2正則化を追加

# 自動混合精度の設定

grad_scaler = GradScaler()grad_scaler:自動混合精度(AMP)を使用するためのスケーラーを設定します。

学習ループ

# 学習ループ

num_epochs = 30 # エポック数を調整

for epoch in range(num_epochs):

model.train()

epoch_loss = 0

for data in train_loader:

noisy_inputs, clean_inputs = data

noisy_inputs = noisy_inputs.to(device)

clean_inputs = clean_inputs.to(device)

optimizer.zero_grad()

with autocast(): # FP16を自動適用

outputs = model(noisy_inputs)

loss = criterion(outputs, clean_inputs)

grad_scaler.scale(loss).backward()

grad_scaler.step(optimizer)

grad_scaler.update()

epoch_loss += loss.item()

avg_loss = epoch_loss / len(train_loader)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {avg_loss:.4f}')autocast():自動混合精度(AMP)を使用して前方伝播を行います。

再構成データの生成と評価

# 再構成データの生成

model.eval()

with torch.no_grad():

reconstructed = model(X_noisy_tensor.to(device)).cpu().numpy()

# データの逆標準化

reconstructed_data = scaler.inverse_transform(reconstructed.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)

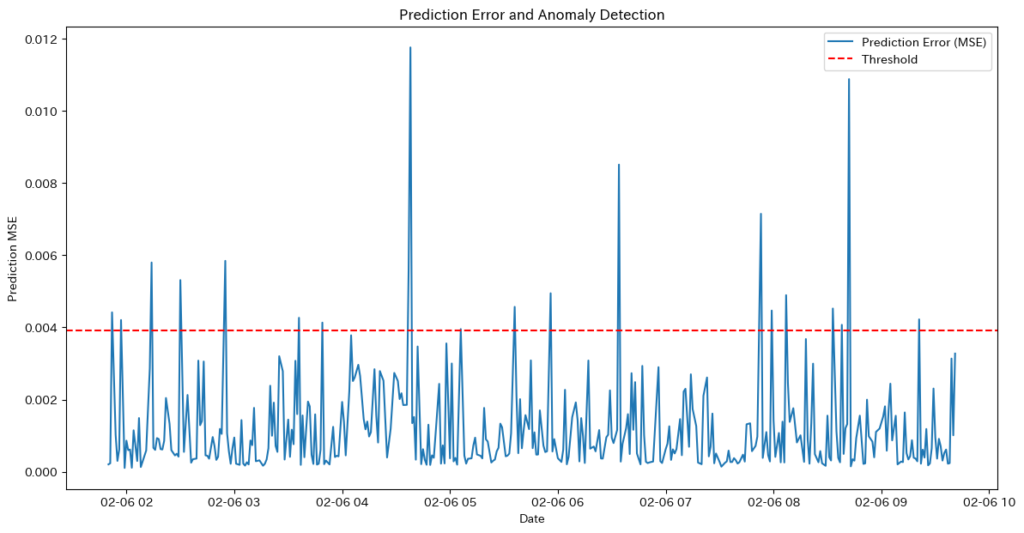

original_data = scaler.inverse_transform(X_clean.reshape(-1, input_dim)).reshape(-1, seq_length, input_dim)可視化

# 可視化(Close価格の比較)

plt.figure(figsize=(14, 7))

plt.plot(original_data[:, -1, 3], label='Original Close') # 最後のシーケンスのClose価格をプロット

plt.plot(reconstructed_data[:, -1, 3], label='Reconstructed Close') # 最後のシーケンスのClose価格をプロット

plt.title('Original vs Reconstructed Close Prices')

plt.xlabel('Time Steps')

plt.ylabel('Close Price')

plt.legend()

plt.show()

print("処理が完了しました")

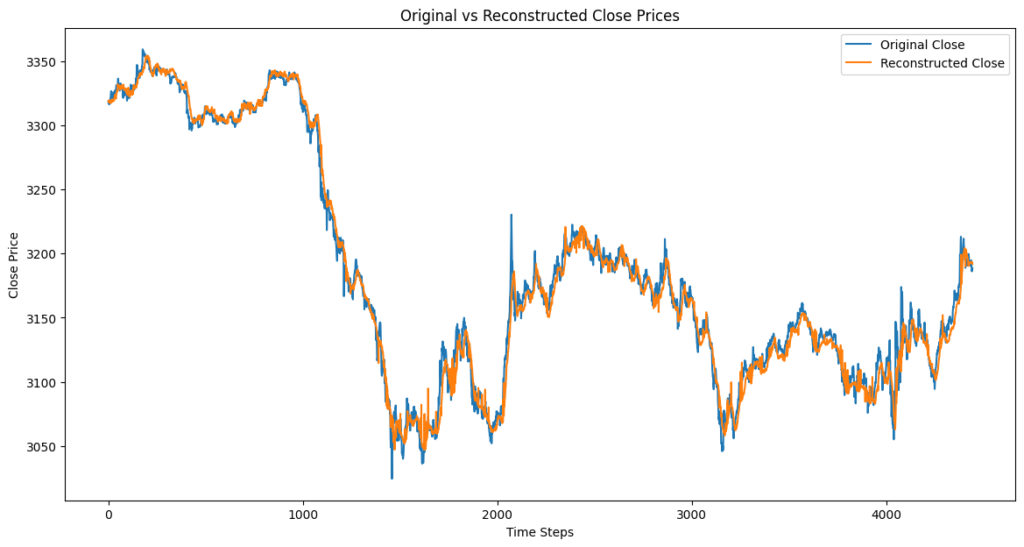

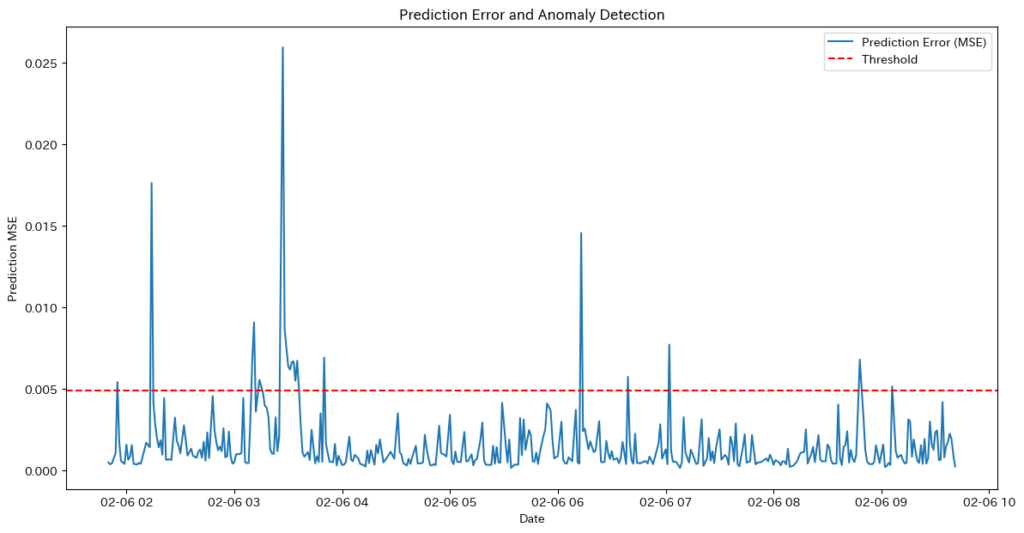

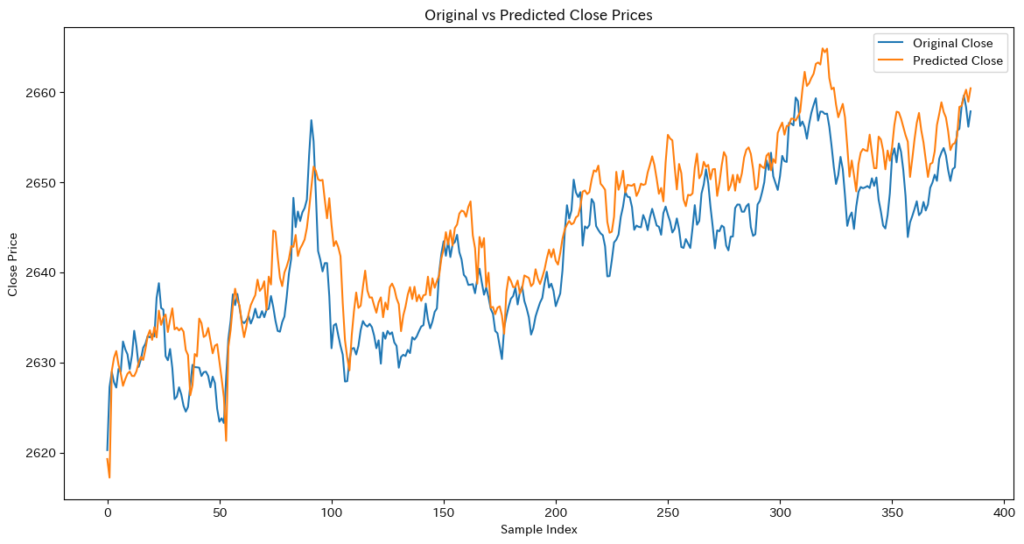

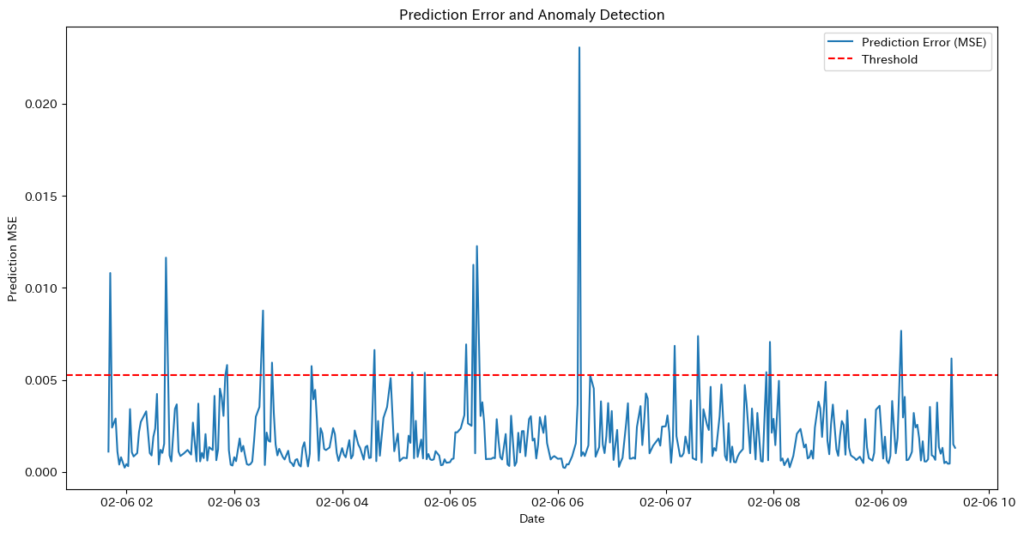

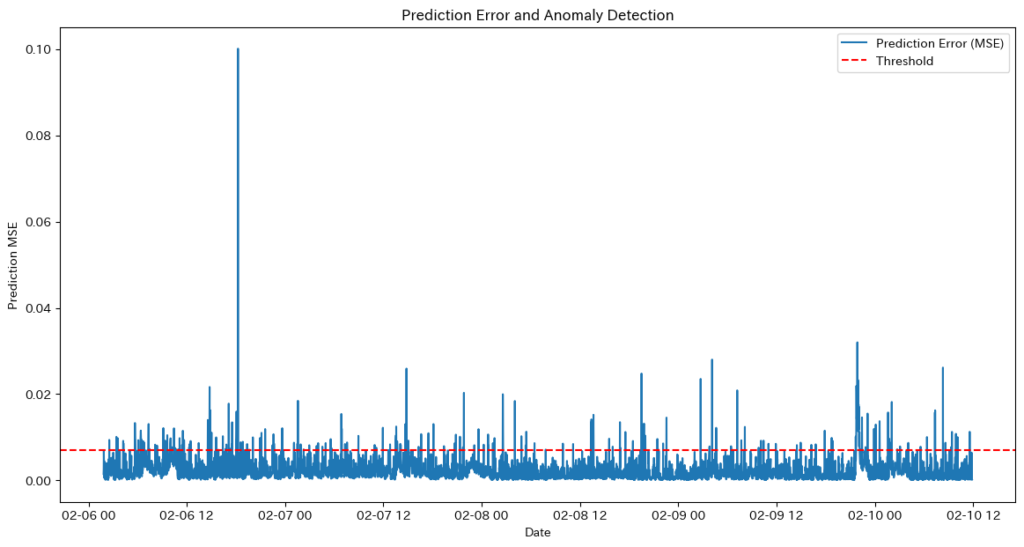

deno+MLAモデルの特徴

- 青(Original)とオレンジ(Reconstructed)がほぼ完全に一致し、短期的な変動を忠実に再現しつつ、トレンドの変化を正確に捉えながら適切にノイズが除去されています。

ノイズ除去の性能比較

| 項目 | MLAモデル | Transformerモデル |

|---|---|---|

| ノイズ除去の精度 | 高い(ノイズを適切に除去しつつ、短期変動を保持) | 高いが、短期変動をややスムーズにしすぎる |

| 短期変動の保持 | 優れている(スパイクや急変動に強い) | 若干劣る(平滑化されやすい) |

| 長期トレンドの再現 | 良い(短期変動とバランスよく再現) | 良い(長期変動の学習は得意) |

| 計算コスト | 低い(O(n log n) まで削減できる可能性あり) | 高い(O(n²) の計算量) |

| トレーディング適性 | 短期トレード・スイングトレード向き | スイングトレード・長期トレード向き |

どのような場合にどちらのモデルを使うべきか?

| 用途 | MLAモデルが適している場合 | Transformerモデルが 適している場合 |

|---|---|---|

| 短期トレード(スキャルピング、デイトレード) | ✅ 価格の細かい変動を再現できるため最適 | ❌ 短期の価格変動を滑らかにしてしまうため不向き |

| 長期トレード(スイングトレード、ポジショントレード) | ✅ 長期トレンドを維持しつつ短期変動も考慮できる | ✅ 長期の価格推移の再現に優れる |

| ボラティリティの高い市場 (仮想通貨、株式指数) | ✅ 価格の急変にも適応できるため有利 | ❌ 急変をスムーズにしすぎる可能性がある |

| 低計算コストでのリアルタイム処理 | ✅ Transformerより計算コストが低いため有利 | ❌ 計算負荷が高く、リアルタイム処理には向かない |

🔹 総合的に、ノイズ除去に関しては MLAモデルの方がTransformerモデルよりも実用性が高く、特に短期トレードには最適な選択肢と言える。

結論:TransformerよりMLAの方が良いのか?

結論として、「MLA単体 vs. Transformer」ではなく、MLAをTransformerに組み込むことでより優れたモデルになる可能性があると考えられます。

短期予測と長期予測の場合の組み合わせの最適解

✅ 短期予測(ボラティリティの高い市場) → MLA単体が最適(計算コストが低く、ノイズ耐性があり、即応性に優れる)

✅ 長期予測(市場トレンドの学習) → Transformer + MLAが最適(長期依存関係を学習し、トレンドの安定性を確保)

- そのほかに試すことができる方法

| 手法 | ノイズ除去への適性 | 主な特徴 |

|---|---|---|

| 自己教師あり学習(SSL) | ✅ 可能 | マスク学習でノイズを抑え、データ補完が可能 |

| 変分オートエンコーダ(VAE)+ Transformer | ✅ 可能 | 潜在空間を活用し、異常値やノイズを除去 |

| フィルタリングモデル(カルマンフィルター / Particle Filter)+ Transformer | ✅ 可能 | リアルタイムで市場ノイズを除去 |

| Long-Sequence対応のTransformer(Longformer等) | ✅ 可能 | GPUメモリ消費削減可能モデル |

Transformerを扱う上で知るべき可能性

後の章で紹介するGPUメモリ制約の解決策の一つとして、「Long-Sequence対応のTransformer」 というアプローチがあります。これは、Transformerモデルのメモリ消費を抑えるアルゴリズムを活用し、より効率的なモデルを構築する方法です。適切なアルゴリズムと組み合わせることで、計算コストを削減しながら、高性能なモデルを実現できる可能性があります。

GPUメモリ制約を解決するための方法

Transformerの自己注意機構(Self-Attention)は、入力シーケンスの長さに対して二乗オーダーの計算コストがかかるため、GPUのメモリ制限が問題になりやすくなります。特に、金融時系列データのような長いシーケンスを扱う場合、メモリ消費が急増するため注意が必要です。

GPUメモリ制約を解決するための方法として、以下のような方法を組み合わせることで、GPUのメモリ使用量を削減しながらTransformerを効率的に扱うことが可能です。

モデルの軽量化

低精度計算 (Mixed Precision Training)

「低精度計算」とは、FP32(32ビット)をFP16(16ビット)に置き換えることで、メモリ使用量を半減し、計算速度を向上させる手法です。特に、大規模な時系列データを扱うTransformerでは、GPUのメモリ制約を軽減するのに有効です。

低精度計算の利用条件

| 条件 | 説明 |

|---|---|

| 対応GPU | – NVIDIA GPU対応。MPS対応。 – AMP((自動混合精度))はNVIDIAのCUDA対応GPUでのみサポートされています。 |

| 必要なライブラリ | – CUDA および cuDNN ライブラリが必須(NVIDIA GPU専用)。 – CPUでの利用不可。 |

| CPUサポート | – CPUはMixed Precision Trainingをサポートしておらず、通常FP32(単精度浮動小数点)で計算を行う。 |

低精度計算の実装例:

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

for inputs, targets in dataloader:

optimizer.zero_grad()

with autocast(): # FP16を自動適用

outputs = model(inputs)

loss = loss_fn(outputs, targets)

scaler.scale(loss).backward()

scaler.step(optimizer)

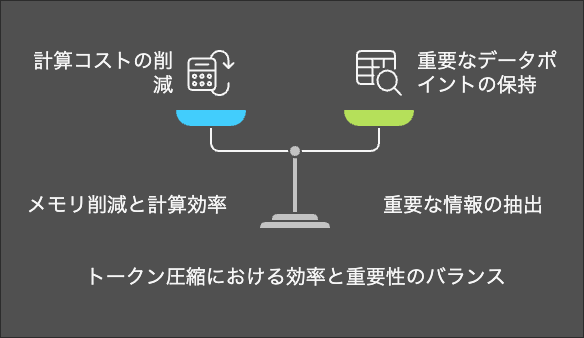

scaler.update()モデルの圧縮 (Pruning & 量子化)

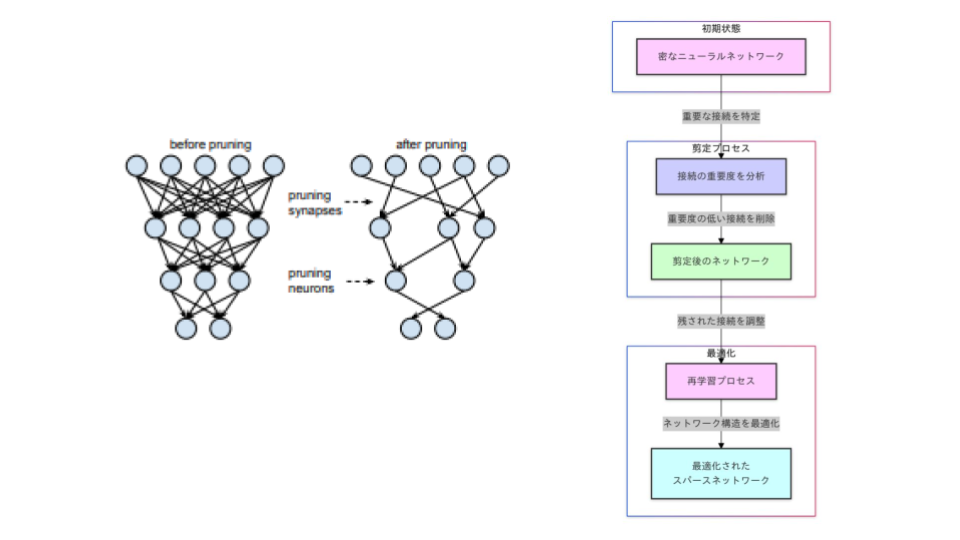

- Pruning (枝刈り)

- 影響の小さいパラメータを削除し、モデルサイズを縮小。

- 構造化プルーニング(Structured Pruning)が適している。

- 理由:フィルターやチャネル単位でプルーニングを行うため、ハードウェアの最適化が容易であり、計算効率を向上させることができます。

Puringの方法については下記のブログに詳しく記載しておりますのでご確認ください。

構造化プルーニングの実装例:

from torch.nn.utils import prune

# 構造化プルーニングの適用

for name, module in model.named_modules():

if isinstance(module, nn.Linear):

prune.ln_structured(module, name='weight', amount=0.2, n=2, dim=0) # 20%のプルーニングを適用

# プルーニングの再パラメータ化を解除

for name, module in model.named_modules():

if isinstance(module, nn.Linear):

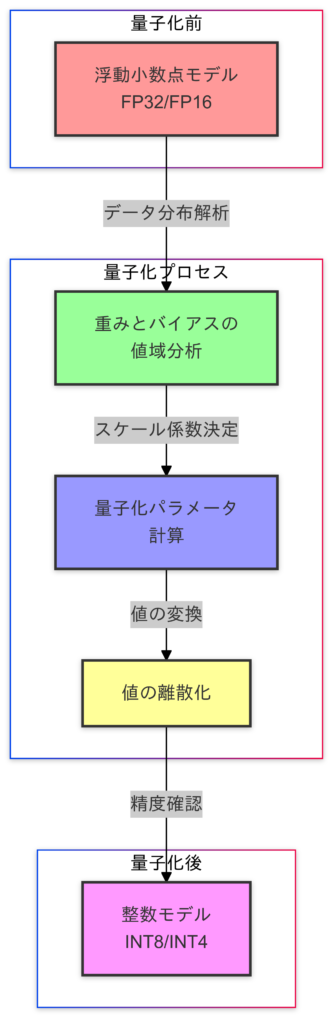

prune.remove(module, 'weight') # プルーニングのフックを削除- Quantization (量子化)

- 8bitや4bitの整数にモデルを変換して計算を軽量化。

- 効果:メモリ削減と推論の高速化。

量子化の方法については下記のブログに詳しく記載しておりますのでご確認ください。

量子化(PTQ)の実装例:

- GPUがCUDAの場合

import torch.quantization

model = torch.quantization.quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)このコードは PTQの「動的量子化(Dynamic Quantization)」 を実行しています。PTQは、トレーニング後にモデルを量子化する手法で、追加の学習が不要なため、簡単に適用できるのが特徴です。

- GPUがApplesilicon版(MPS)の場合

import torch.quantization

# 量子化バックエンドの設定

torch.backends.quantized.engine = 'qnnpack'

# デバイスの設定(トレーニングと推論はCPU上で行う)

device = torch.device("cpu")

model.to(device)

# モデルを評価モードに設定

model.eval()

# 量子化の適用

quantized_model = torch.quantization.quantize_dynamic(

model, {nn.Linear}, dtype=torch.qint8

)

quantized_model.to(device)モデルアーキテクチャの工夫

通常のTransformerは、自己注意機構(Self-Attention)を使用するため、入力シーケンスの長さ $N$ に対して $O(N^2)$ の計算量がかかります。これにより、シーケンスが長くなるほど計算コストやメモリ消費が急増し、長い時系列データ(Long-Sequence)の処理が難しくなるという課題があります。

Long-Sequence対応のTransformerとは?

この問題を解決するために、計算量を削減した新しいアーキテクチャのTransformerが登場し、長いシーケンスをより効率的に処理できるようになりました。具体的には、以下のような手法が採用されています。

| モデル | 特徴 | 計算量 |

|---|---|---|

| Longformer | スライディングウィンドウ注意機構 | O(N) |

| Linformer | 低次元の表現に圧縮 | O(N) |

| Performer | ランダム特徴写像を使用 | O(N) |

| Reformer | LSH (Locality-Sensitive Hashing) | O(N log N) |

Longformerモデル

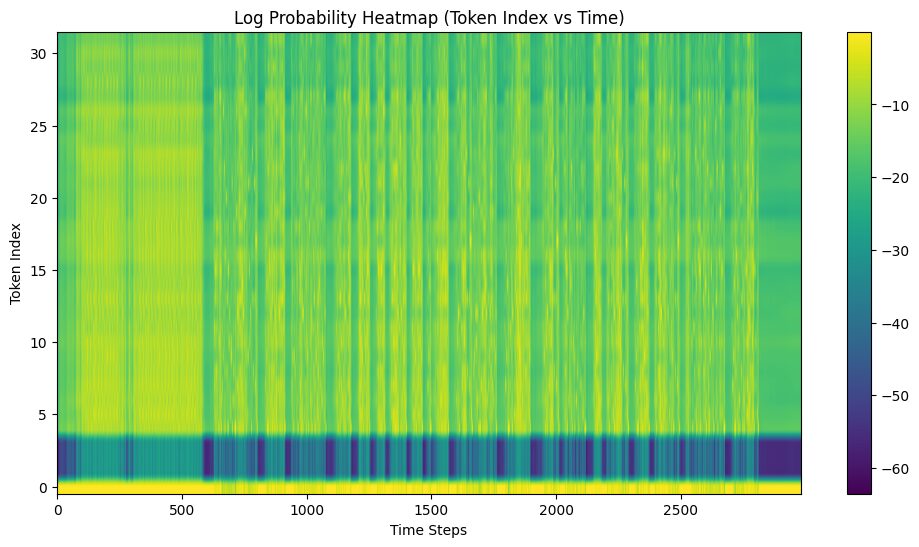

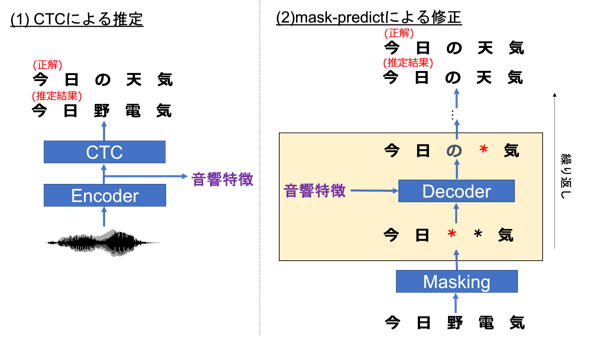

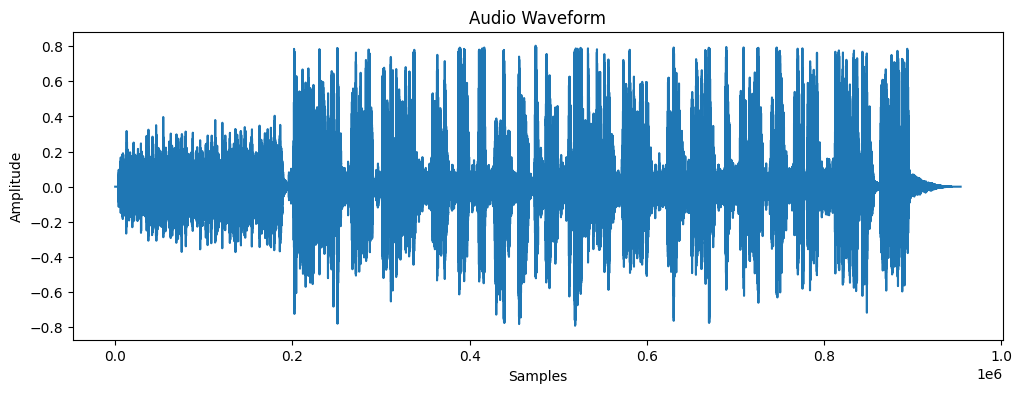

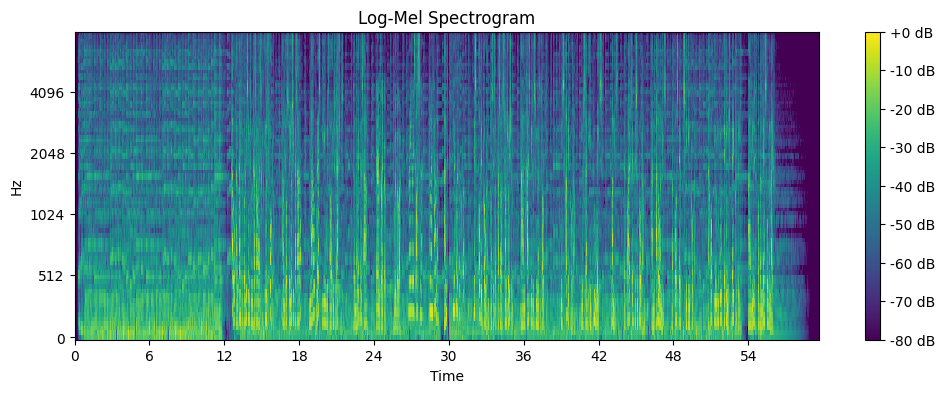

特徴: