Ring Attentionとは?

『Ring Attention with Blockwise Transformers』は、AIモデルで長いシーケンスを効率的に処理するために、ブロック単位のAttention機構とフィードフォワード操作のブロック単位の計算を活用する革新的な手法です。

このアルゴリズムにより、長いシーケンスを複数のデバイスに分散して処理し、キー・値ブロックの通信をブロック単位の注意の計算と完全に重複させることが可能となります。

これにより、「リングアテンション」は、以前のメモリ効率の高い「Transformer」では実現できなかった長いシーケンスでのトレーニングや推論を可能にし、近似の必要もなく、追加の通信や計算のオーバーヘッドも発生しなくなりました。

Ring Attentionを図解で説明

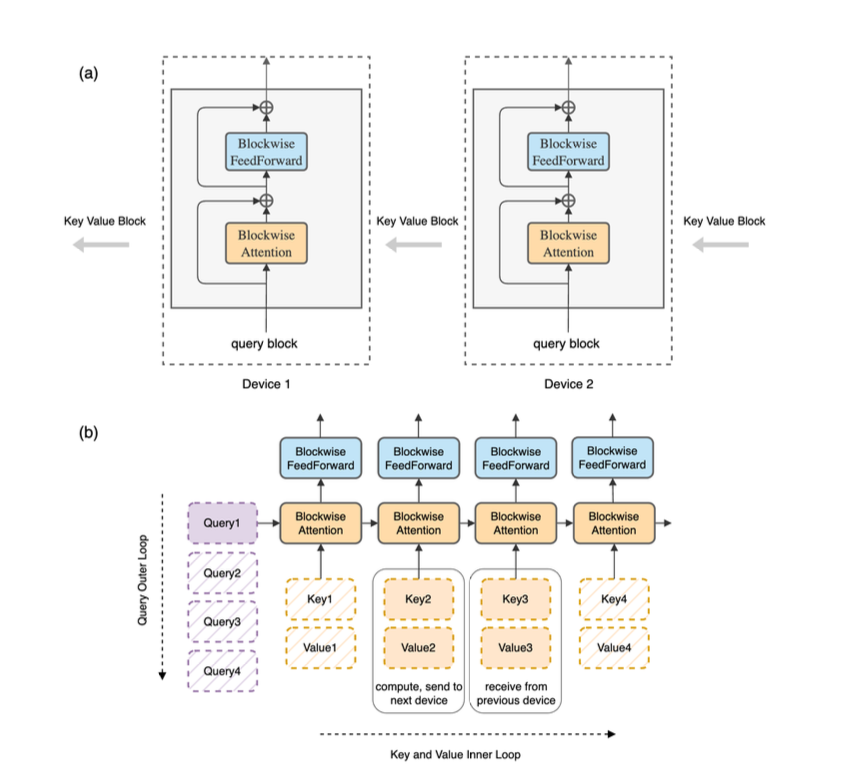

この図は「リングアテンション」の計算方法について説明されています。上の図(a)では、ホストのリング内でキー・値ブロックがブロック単位で移動し、注意とフィードフォワードの計算が重なるように行われます。下の図(b)では、元の「Transformer」をブロック単位で計算し、各ホストが特定のイテレーションを担当します。

Ring Attentionの特徴

効率的なメモリ使用

「リングアテンション」は、ブロック単位の注意とフィードフォワード操作をデバイス間で分散し、同時にキー・値ブロックの通信を重複させることで、メモリコストを大幅に削減します。これにより、トレーニングと推論の両方でゼロオーバーヘッドでコンテキストサイズをスケーリングし、著しく大きなコンテキストサイズを追加のオーバーヘッドなしに処理できます。

拡張性

ブロック単位の計算とホスト間の通信にリング構造を活用することで、「リングアテンション」は以前のメモリ効率の高いTransformerでは実現できなかった、デバイス数倍長いシーケンスのトレーニングと推論を可能にします。この拡張性は、複雑な環境で長いシーケンスを処理するために重要です。

性能の向上

言語モデリングや強化学習タスクでの幅広い実験は、「リングアテンション」の効果を示しています。数百万のトークンを含むコンテキストサイズを可能にし、全体的なパフォーマンスを向上させます。このアルゴリズムは、長いシーケンスを処理し、拡張されたコンテキスト長でも高い精度を維持する点で、以前の手法を上回ります。

ほぼ無限のコンテキスト

「リングアテンション」は、AIモデルでほぼ無限のコンテキストを実現する可能性を開き、大規模なビデオ・オーディオ・言語モデル、拡張されたフィードバックからの学習、コードベースの理解と生成、そして膨大なデータからの強力な推論など、魅力的な機会を提供します。

Ring Attentionの疑問点

質問1

Blockwise Transformerを使ったリングアテンションは、長いシーケンスを複数のデバイスにどのように分配するのですか?

回答

Ring Attention with Blockwise Transformersは、通信にリング構造を利用し、ブロック単位の注意とフィードフォワード操作の計算、およびキー・値ブロックの通信を重ね合わせることで、効率的なスケーリングとメモリ使用を実現し、長いシーケンスを複数のデバイスに分散します。

質問2

複雑な環境でビデオ、アクション、その他の長尺のシーケンスを処理するためにリングアテンションを使用する利点は何ですか?

効率的なメモリ使用

メモリコストを削減し、コンテキストサイズのスケーリングにゼロのオーバーヘッドを可能にすることで、「リングアテンション」は個々のデバイスによって通常課せられるメモリ制約なしに長いシーケンスを処理できます。これは、大規模なビデオやオーディオデータセットの処理に必要な広範なメモリリソースを処理するために重要です。

拡張性

「リングアテンション」が長いシーケンスを複数のデバイスに分散し、以前の手法よりもデバイス数倍長いシーケンスを処理できる能力は、複雑な環境でのスケーリングに適しています。この拡張性は、ビデオ解析、アクション認識、および他のデータ集約的なタスクでの長いシーケンスの処理に必須です。

性能の向上

幅広い実験で、「リングアテンション」が言語モデリングや強化学習タスクのパフォーマンスを向上させる効果が示されています。この改善されたパフォーマンスは、複雑な環境で長いシーケンスを処理する際に、より高い精度と効率をもたらします。

ほぼ無限のコンテキスト

「リングアテンション」がほぼ無限のコンテキストサイズを処理できる能力は、複雑な環境で大量のデータを処理する機会を提供します。これは、実世界のビデオ、オーディオ、または他のマルチモーダルデータの長いシーケンスを分析するタスクに特に有益です。

汎用性

「リングアテンション」の柔軟性は、長いシーケンスを分散し、通信を計算と重ね合わせることで、さまざまな種類のデータ、ビデオ、アクション、および他の長いシーケンスを処理するための多目的な解決策として役立ちます。異なるタイプの複雑な環境に適応できる柔軟性は、さまざまなアプリケーションにとって貴重なツールとなります。

質問に対する回答のまとめ

「リングアテンション」は、メモリ効率、拡張性、パフォーマンスの向上、ほぼ無限のコンテキストのサポート、および汎用性の点での利点があり、これらの利点によりビデオ、アクション、および他の長いシーケンスを複雑な環境で効率的に処理し、多様な実世界のシナリオでデータの処理と分析を可能にします。

質問3

リング・アテンションがパフォーマンスを向上させた言語モデリングや強化学習タスクの例を教えてください。

言語モデリング

- モデルのファインチューニング:「リングアテンション」は、LLaMAなどの言語モデルのファインチューニングに適用され、より長いコンテキスト長を可能にしました。数百万のコンテキストトークンでのトレーニングを実現することで、拡張されたコンテキスト長でも高い精度が示され、言語モデリングタスクの実験でも確認されました。

- ライン検索テスト:ライン検索タスクの文脈で、「リングアテンションモデル」はさまざまなコンテキスト長で高い精度を維持し、長いシーケンスを効果的に処理する能力を示しました。これは、長文書から情報を正確に取得するタスクにとって重要な性能向上です。

強化学習

- ベンチマーク:リングアテンションはExoRLベンチマークで評価され、さまざまなタスクで一貫して以前の手法を上回り、高い累積報酬を達成しました。これは、trial-and-error RL体験をTransformersで学習する際に「リングアテンションの利点」を示しています。

- 長距離ライン検索タスク:長距離ライン検索タスクなどのタスクでは、「リングアテンションモデル」が従来の最先端モデルよりも優れた性能を示しました。シーケンス長を拡張し、「リングアテンション」を活用することで、モデルは一貫して他の手法を上回り、強化学習シナリオでの「リングアテンションの効果」を示しました。

質問に対する回答のまとめ

言語モデリングや強化学習の両方のタスクで、「リングアテンション」は長いシーケンスを処理し、パフォーマンスを改善し、拡張されたコンテキスト長でも高い精度を実現するための貴重な技術であることが証明されています。リングアテンションの能力は、長いシーケンスを効率的に複数のデバイスに分散させながら、パフォーマンスを維持することができるため、幅広いAIアプリケーションにおいて強力なツールとなっています。

まとめ

『Ring Attention with Blockwise Transformers』は、AIモデルで長いシーケンスを効率的に処理し、以前の制限を超えたシーケンスのトレーニングと推論を可能にする、メモリ効率の高い、拡張性のある、高性能な解決策を提供します。これにより、精度を損なうことなく、追加のオーバーヘッドを発生させることなく、長いシーケンスを処理できます。

参考論文

『Ring Attention with Blockwise Transformers for Near-Infinite Context』

『World Model on Million-Length Video And Language With RingAttention』

コメント