【今回の主な内容】バッチ処理・最適化アルゴリズム

今回のテーマでは、「効率的な学習」を実現するために欠かせない バッチ処理 と 最適化アルゴリズム の基礎に焦点を当てます。これらは、ディープラーニングモデルが高次元で膨大なデータを効率よく処理し、実用的な性能を獲得するための土台です。学習プロセスを通じて、ニューロンの結合強度を意味する「重み」がどのように最適化されるかを理解することは、より精密で効果的なモデル構築に直結します。

今回の学習の目標

ディープラーニングモデルの学習プロセスを効果的に設計・実行するためのテクニックを深く理解し、実践に活用できるスキルを習得することを目指します。特に、モデルの性能や汎化能力を向上させる学習アルゴリズムやトレーニングテクニックを体系的に学びます。以下の4つのポイントを柱に、効率的かつ安定した学習方法を習得します。

- バッチ処理とバッチ正規化の活用

- ミニバッチ学習

- データを小さなバッチに分割し、計算リソースの効率的活用と学習の安定性を実現します。バッチサイズの選定がモデルの学習速度や性能に与える影響についても学びます。

- GPU並列処理

- GPUの高速並列処理能力を活用して、バッチ処理を効率化します。大規模データセットの学習時間短縮と計算資源の最適活用を目指します。

- バッチ正規化(Batch Normalization)

- 各バッチ内でデータを正規化することで、勾配消失問題を緩和し、学習速度と収束の安定性を向上させます。

- ミニバッチ学習

- 最適化アルゴリズムの選択と活用

- 確率的勾配降下法(SGD)とその派生手法

- SGDの基礎を学び、MomentumやAdamなどの派生手法が収束速度や勾配の安定性にどのように寄与するかを解説します。これらのアルゴリズムを実践的に選択し、適用する技術を身につけます。

- 学習率の調整

- 学習率の適切な設定が収束性やモデル性能に与える影響を理解し、ステップスケジューラーやコサインスケジューラーを用いた動的な調整手法を実践します。

- 確率的勾配降下法(SGD)とその派生手法

- データ拡張と正則化による汎化性能の向上

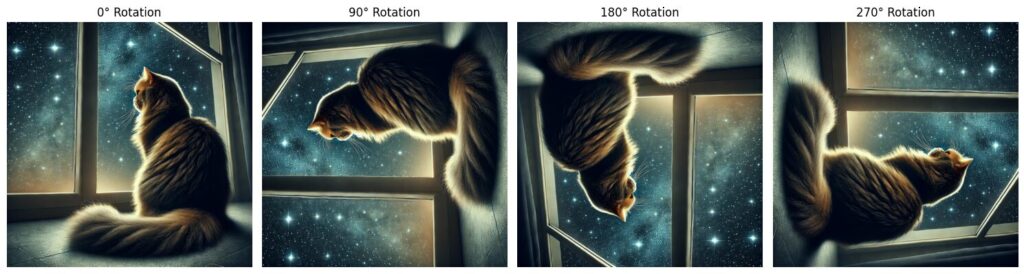

- データ拡張

- 画像の回転、平行移動、反転、ズームなどのテクニックを用いてデータセットを拡張し、モデルの過学習を防ぎます。

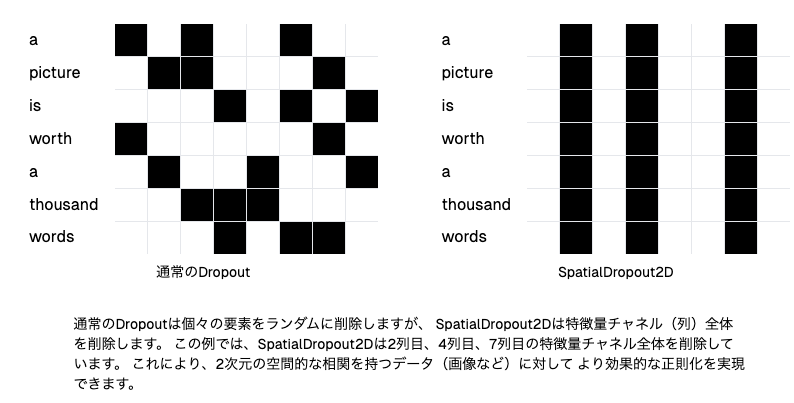

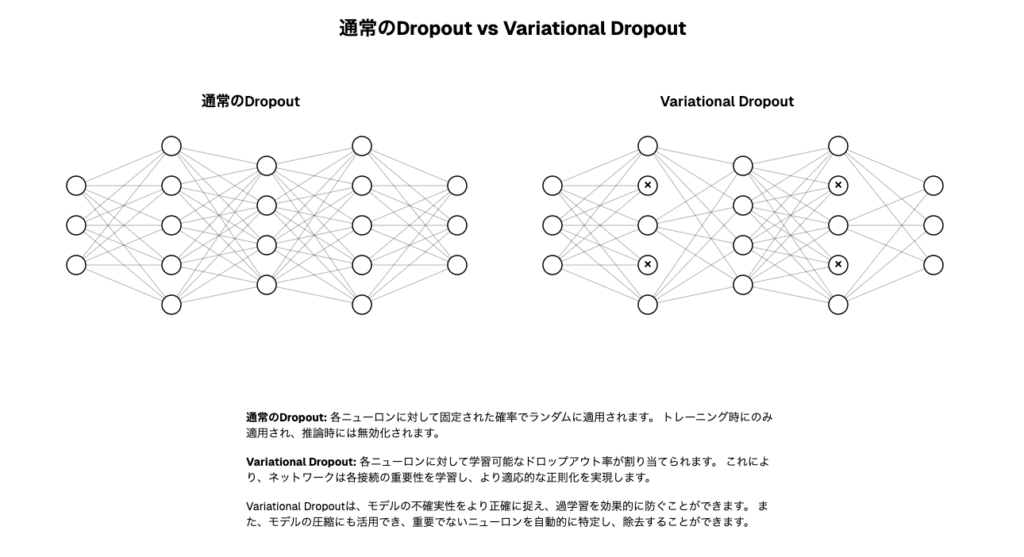

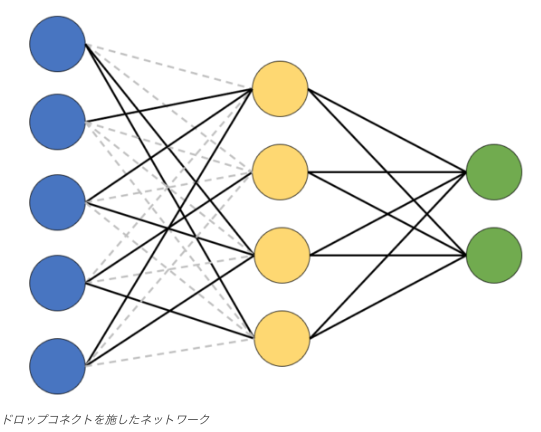

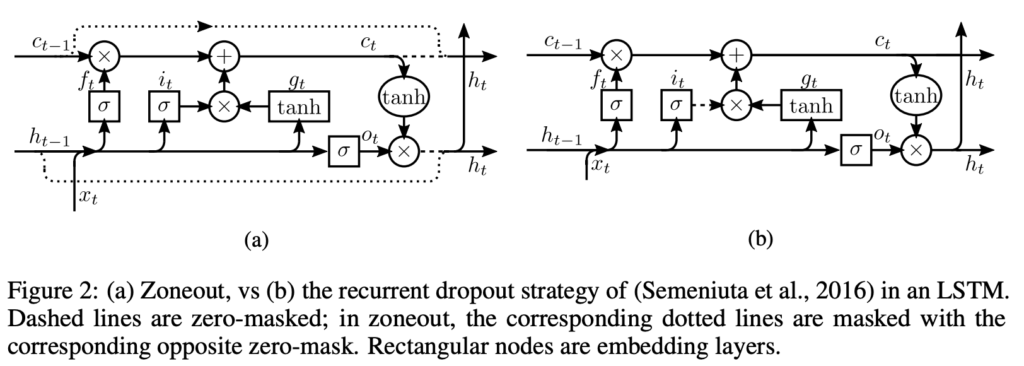

- 正則化手法

- L1/L2正則化やドロップアウトを活用して、モデルの複雑さを制御しつつ汎化性能を向上させる実践的なスキルを習得します。

- データ拡張

- 学習プロセスの制御と改善

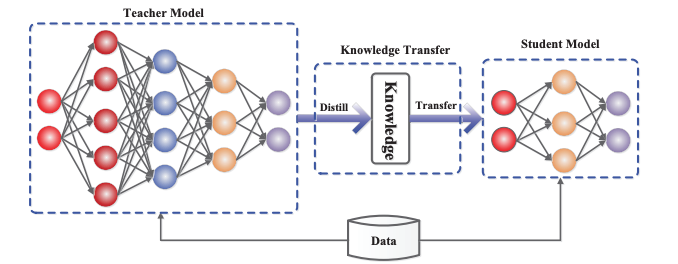

- 蒸留(Knowledge Distillation)

- 大規模なティーチャーモデルから小規模なスチューデントモデルへ知識を転移し、モデルの軽量化を図ります。

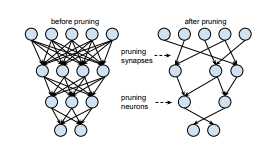

- 枝刈り(Pruning)

- 不要なパラメータや接続を削減して計算量を抑え、推論速度を向上させる手法を学びます。

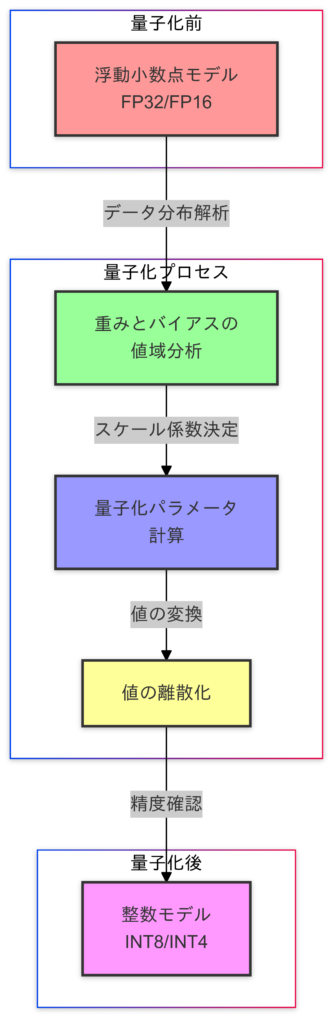

- 量子化(Quantization)

- モデルパラメータを低精度フォーマットに変換することで、メモリ使用量の削減と推論速度の向上を実現します。

- Early Stopping(早期終了)

- 検証データの損失が一定期間改善しない場合に学習を停止することで、過学習の防止と計算リソースの効率的利用を実現します。

- 蒸留(Knowledge Distillation)

ゴール

- 最適なトレーニングループ構築

- 最適化アルゴリズムやバッチ処理を活用して、効率的で安定した学習プロセスを設計します。

- 汎化性能の向上

- データ拡張や正則化手法を駆使し、未知データへの対応力を高めます。

- 計算効率の最適化

- GPU並列処理とモデルの軽量化技術を組み合わせて、トレーニングと推論の効率化を実現します。

- 過学習の防止

- Early Stoppingなどの手法を活用し、モデルの性能を最大化しつつ無駄なリソース消費を防ぎます。

- 次回の学びへの応用力強化

- 得られた知識を基盤として、さらなる高度なトレーニング手法やモデル設計に進む準備を整えます。

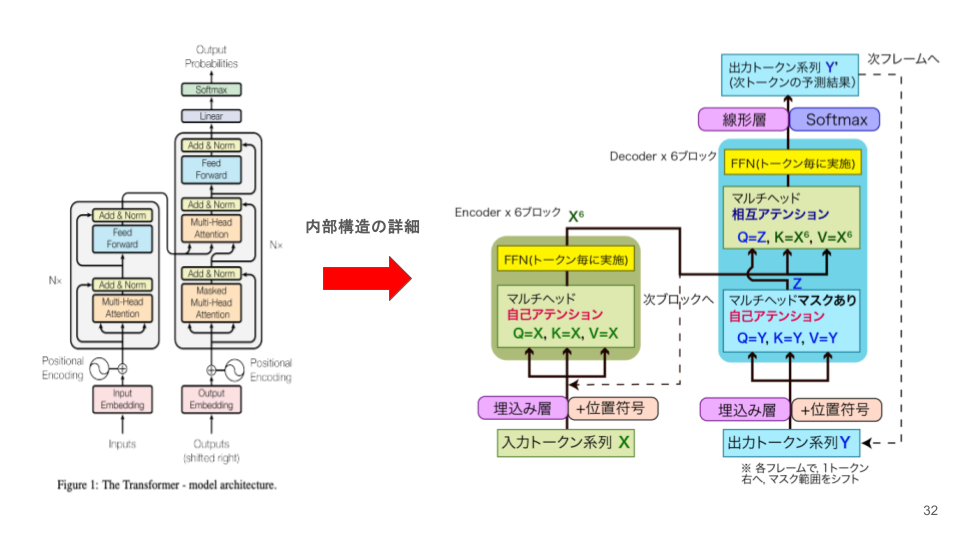

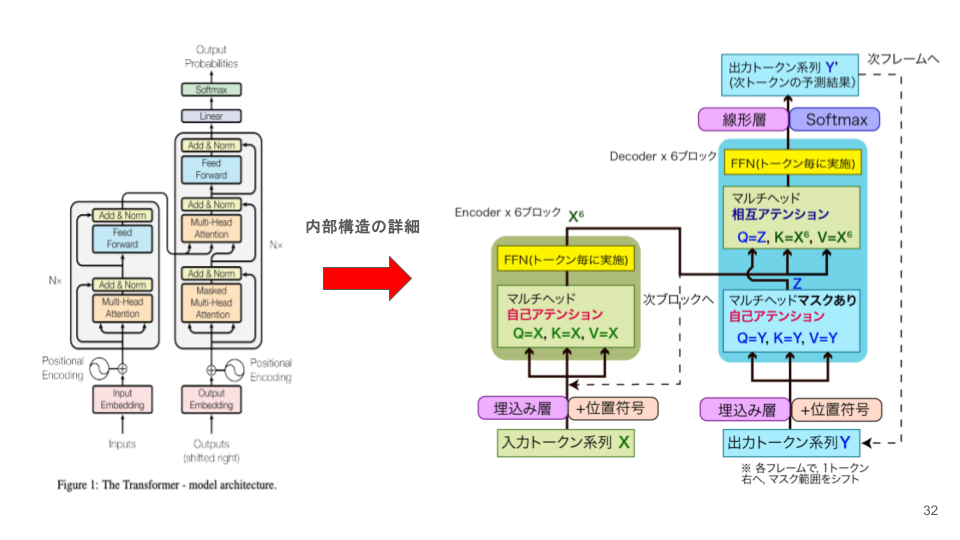

前回の振り返り

ディープラーニングは、私たちの脳のニューロンとその相互作用を模倣したニューラルネットワークを通じて、データから学び、複雑な問題を解決する技術です。これまでの学びでは、ディープラーニングの基本構造や、誤差逆伝播法による重みの調整の仕組みについて深く掘り下げました。そして前回は、損失関数と活性化関数がどのように学習を導く役割を果たすかを探りました。

【前回のブログ】

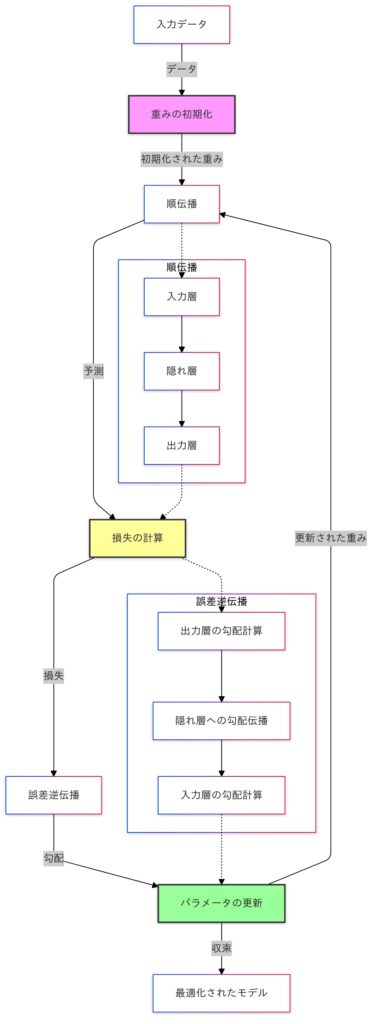

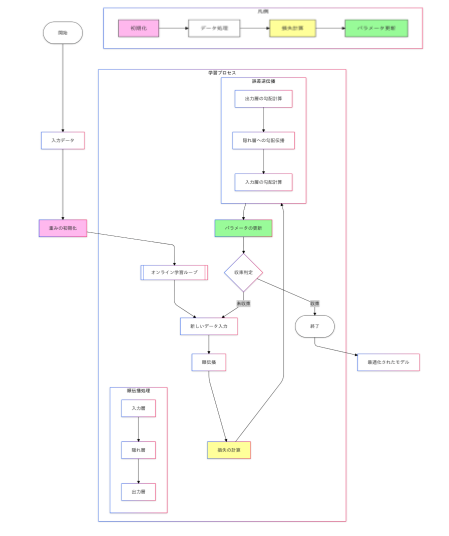

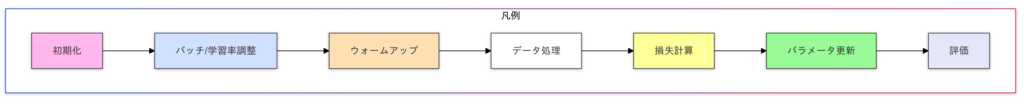

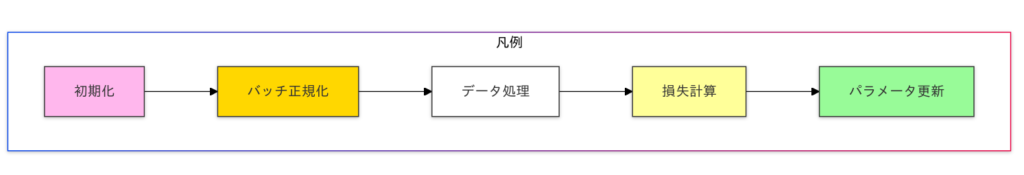

モデル学習の基本プロセス

- 入力データ: モデルのトレーニングは、入力データの提供から始まります。

- 重みの初期化: ネットワーク内のパラメータ(重みとバイアス)がランダムに初期化されます。

- 順伝播: データは、入力層から隠れ層、出力層へと伝播され、予測値が生成されます。

- 損失の計算: 予測値と実際の値との差異(損失)を計算します。

- 誤差逆伝播: 損失を基に勾配を計算し、誤差を出力層から入力層まで逆方向に伝播します。

- パラメータの更新: 勾配を用いて重みを更新し、モデルを最適化します。

このプロセスを繰り返すことで、モデルは徐々に精度を向上させ、最適化されたネットワークが得られます。この図は、ディープラーニングにおけるモデル学習の全体像を簡潔に示しています。

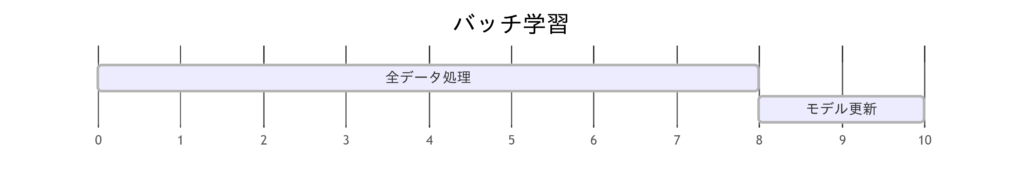

バッチ学習とオンライン学習

ディープラーニングモデルの学習を効率化し、精度を向上させる鍵となる技術に「バッチ処理」があります。膨大なデータを扱う場面で、すべてのデータを一度に処理するのではなく、バッチ(小分けのデータ)に分割することで、計算リソースを効率的に活用します。まずはそれぞれの学習方法と人間の脳の類似点について考えてみましょう。

オンライン学習と人間の脳の類似点

オンライン学習は、データを逐次処理し、新しい情報を学びながらモデルを更新する手法です。これは、人間の脳が日常生活で行う逐次学習と非常に似ています。たとえば、会話中に相手の意図を理解しながら新しい知識を得たり、仕事中に発生した問題を解決しながらスキルを学んだりするプロセスが該当します。脳は一度に全情報を学習するのではなく、得られる情報をリアルタイムで処理し、必要に応じて適応的に更新していきます。また、オンライン学習は過去のデータにとらわれず、新しいデータに基づいて柔軟に判断するため、環境の変化に対応する脳の適応力とも共通します。一方で、ノイズの多い情報に影響を受けやすい点は、人間の判断の揺らぎとも関連しています。

バッチ学習と人間の脳の類似点

バッチ学習は、大量のデータを一括処理して学習する手法であり、人間の脳が行う記憶統合や集中学習と似ています。たとえば、脳は睡眠中に日中の経験を整理し、重要な情報を長期記憶として保存します。この過程では、大量の情報を一度にまとめて処理し、全体のパターンや関係性を見出します。また、試験前に集中して学ぶような場面でも、大量の知識を短期間で吸収し、統合的に理解するプロセスはバッチ学習の一括処理と共通しています。ただし、バッチ学習はリアルタイム性がなく、計算リソースを大量に必要とするため、エネルギー効率に優れた脳の動きとは異なります。それでも、大局的な学習能力という点で、人間の脳とバッチ学習は共通性を持っています。

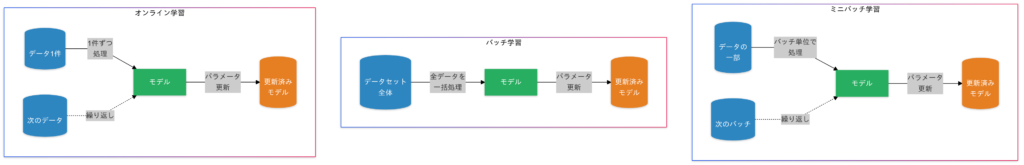

「オンライン学習」「バッチ学習」「ミニバッチ学習」の違い

まずはそれぞれの学習の違いを見ていきましょう。

| 手法 | 特徴 | 使用シナリオ | 数式 |

|---|---|---|---|

| オンライン学習 | データを逐次処理。リアルタイム性が高いが、勾配が不安定になる可能性。 | ストリーミングデータの処理(例:株価予測)。 | $ L = l(y_t, \hat{y}_t)$ |

| バッチ学習 | データ全体を一括で処理。計算精度が高いが、リソース消費が大きい。 | 画像分類タスクなど、大量のデータが事前に揃っている場合。 | $ L =$$ \frac{1}{N} \sum_{i=1}^{N} l(y_i, \hat{y}_i)$ |

| ミニバッチ学習 | バッチサイズでトレードオフを取りつつ処理を効率化。 | 一般的なディープラーニングのトレーニングで主流。 | $ L =$$ \frac{1}{B} \sum_{i=1}^{B} l(y_i, \hat{y}_i)$ |

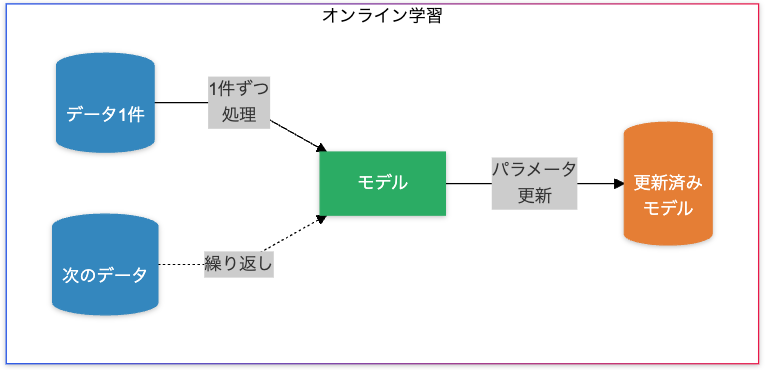

オンライン学習(Online Learning)

データ処理方法:

データが1つずつ(または少量ずつ)リアルタイムに与えられ、それに応じてモデルが逐次更新されます。

特徴:

- リアルタイム性

- 新しいデータが到着するたびにモデルを更新可能。

- リソース効率

- 一度に処理するデータ量が少ないため、メモリ消費が少ない。

- デメリット

- 勾配が不安定になりやすい。

- ノイズの多いデータに過剰適応(過学習)しやすい。

使用例:

- 株価予測システム

- ストリーミングデータを用い、次の瞬間の株価を予測。

- リアルタイムチャットボット

- 会話ログを使って即時にモデルを更新。

損失関数:オンライン学習の損失関数は単一データ点に基づいて計算されます。

$$ L = l(y_t, \hat{y}_t)$$

$y_t$は真のラベル。$\hat{y}_t$はモデルの予測。

利点と課題

- 利点

- データが随時到着するシステムに適している。

- リアルタイムでモデルを更新可能。

- 課題

- 勾配の不安定性が原因で、収束が遅くなる場合がある。

- 過去のデータ情報を効率的に保持する仕組みが必要(例: メモリ効率の良い勾配保存法)。

オンライン学習の実装例

PyTorchを使用して線形回帰モデルを使ってオンライン学習(逐次学習)でトレーニングする例を実装してみます。PyTorchを使った詳細説明も行いますので手を動かせる場合は手を動かして実際にコードを記述して学んでみてください。

データセットはカリフォルニア州の住宅価格に関するデータセットを使います。

ライブラリのインポート

import torch

import torch.nn as nn

import torch.optim as optim

import random

import numpy as np

import pandas as pd

from sklearn.datasets import fetch_california_housing

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import r2_score

from sklearn.model_selection import train_test_split非線形モデルの定義の定義

class NonLinearRegressionModel(nn.Module):

def __init__(self):

super(NonLinearRegressionModel, self).__init__()

self.fc1 = nn.Linear(8, 64) # 8入力、64出力

self.relu = nn.ReLU()

self.fc2 = nn.Linear(64, 1) # 64入力、1出力

def forward(self, x):

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return xここではnn.Module を継承することで、PyTorchのモデルとして動作するための基本的な機能を持つことができます。

super(LinearRegressionModel, self).__init__()は、親クラス(nn.Module)のコンストラクタを呼び出しています。これにより、親クラスの初期化処理が行われます。self.fc1 = nn.Linear(8, 64)は、8つの入力ユニットと64の出力ユニットを持つ全結合層(線形層)を定義しています。self.fc2 = nn.Linear(64, 1)は、64の入力ユニットと1つの出力ユニットを持つ全結合層(線形層)を定義しています。forwardメソッドは、順伝播(フォワードパス)を定義しています。このメソッドは、入力データxを受け取り、モデルの出力を計算します。

データセットの読み込みと前処理

# データセットの読み込み

housing = fetch_california_housing()

X, y = housing.data, housing.target

# データをpandasのDataFrameに変換

df = pd.DataFrame(X, columns=housing.feature_names)

df['target'] = y

# NaN値を削除

df = df.dropna()

# 特徴量とターゲットに分割

X = df.drop('target', axis=1).values

y = df['target'].values

# データの標準化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# データの分割

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)

# データをPyTorchのテンソルに変換

X_train = torch.tensor(X_train, dtype=torch.float32)

X_test = torch.tensor(X_test, dtype=torch.float32)

y_train = torch.tensor(y_train, dtype=torch.float32).view(-1, 1)

y_test = torch.tensor(y_test, dtype=torch.float32).view(-1, 1)このコードでは前処理を行い、PyTorchのテンソルに変換する一連の手順を示しています。データセットの読み込み、標準化、データの分割、テンソルへの変換を行うことで、モデルのトレーニングと評価に使用できるデータを準備します。これにより、PyTorchを使用して線形回帰モデルをオンライン学習でトレーニングする準備が整います。

PyTorchのテンソル変換の説明

torch.tensor関数を使用して、NumPy配列をPyTorchのテンソルに変換します。dtype=torch.float32は、データ型を32ビット浮動小数点数に指定します。view(-1, 1)は、ターゲットデータy_trainとy_testを2次元テンソルに変換します。ここで、-1は自動的に適切なサイズに調整されることを意味します。- つまり、

y_trainとy_testデータに対して.view(-1, 1)を使用して2次元テンソルに変換する理由は、PyTorchの線形回帰モデルが期待するターゲットデータの形状に合わせるためです。具体的には、PyTorchのnn.Linearレイヤーは、入力データとターゲットデータが特定の形状を持つことを期待しています。

- 入力データ (

X_train,X_test) の形状:X_trainとX_testは、各サンプルが複数の特徴量を持つ2次元テンソルです。例えば、X_trainの形状は(num_samples, num_features)です。ここで、num_samplesはサンプルの数、num_featuresは特徴量の数を示します。

- ターゲットデータ (

y_train,y_test) の形状:y_trainとy_testは、各サンプルに対して1つのターゲット値を持つ必要があります。これを2次元テンソルとして表現するために、形状を(num_samples, 1)に変換します。.view(-1, 1)を使用することで、1次元のターゲットデータを2次元テンソルに変換します。ここで、-1は自動的に適切なサイズに調整されることを意味し、1は各サンプルに対して1つのターゲット値を持つことを示します。

モデル、損失関数、最適化アルゴリズムの初期化

model = NonLinearRegressionModel()

criterion = nn.MSELoss() # 平均二乗誤差損失

optimizer = optim.SGD(model.parameters(), lr=0.01)LinearRegressionModelクラスは、PyTorchのnn.Moduleを継承しています。nn.MSELoss()は、予測値と実際の値の間の平均二乗誤差を計算するための損失関数です。optim.SGDは、PyTorchの最適化アルゴリズムの一つで、モデルのパラメータを更新するために使用されます。

オンライン学習ループ

# オンライン学習ループの開始

for step in range(1000): # 1000回更新を想定

# ランダムなデータポイントの選択

idx = random.randint(0, X_train.shape[0] - 1)

x, y = X_train[idx].view(1, -1), y_train[idx].view(1, -1)

# モデルの予測

y_pred = model(x)

# 損失の計算

loss = criterion(y_pred, y)

# 勾配のリセット

optimizer.zero_grad()

# バックプロパゲーション:勾配の計算とパラメータの更新

loss.backward()

# パラメータの更新

optimizer.step()

# ログ出力と評価

if step % 100 == 0: # 100ステップごとにログを出力

# 評価

model.eval() # 評価モード

with torch.no_grad():

Y_train_pred = model(X_train).view(-1).tolist()

Y_test_pred = model(X_test).view(-1).tolist()

# NaN値のチェック

if np.any(np.isnan(Y_train_pred)) or np.any(np.isnan(Y_test_pred)):

print(f"NaN values found at step {step}")

break

r2_train = r2_score(y_train, Y_train_pred)

r2_test = r2_score(y_test, Y_test_pred)

model.train() # 訓練モードに戻す

print(f"Step {step}: Loss = {loss.item()}, R-squared (Train) = {r2_train}, R-squared (Test) = {r2_test}")Step 0: Loss = 1.497462272644043, R-squared (Train) = -2.8930491520356845, R-squared (Test) = -2.8979675132366345

Step 100: Loss = 0.11681777238845825, R-squared (Train) = 0.2683064067169121, R-squared (Test) = 0.20201395903497776

...

Step 700: Loss = 0.38664156198501587, R-squared (Train) = 0.25707681839085983, R-squared (Test) = 0.10102724438822674

Step 800: Loss = 0.44846442341804504, R-squared (Train) = 0.6007633390263472, R-squared (Test) = 0.5709814493083019

Step 900: Loss = 1.531463384628296, R-squared (Train) = 0.5758513261169051, R-squared (Test) = 0.5419270109690251- オンライン学習ループの開始:

- 1000回の更新を想定してオンライン学習を行います。

range(1000)は、0から999までの整数を生成します。

- 1000回の更新を想定してオンライン学習を行います。

- ランダムなデータポイントの選択:

- トレーニングデータからランダムに1つのデータポイントを選択します。

random.randint(0, X_train.shape[0] - 1)は、トレーニングデータからランダムに1つのデータポイントのインデックスを選択し、選択されたインデックスに対応する入力データ(X_train[idx])とターゲットデータ(y_train[idx])を取得します。

- トレーニングデータからランダムに1つのデータポイントを選択します。

- モデルの予測:

- モデルを使用して、入力データ

xに対する予測値y_predを計算します。

- モデルを使用して、入力データ

- 損失の計算:

- 損失関数を使用して、予測値

y_predと実際の値yの間の損失lossを計算します。

- 損失関数を使用して、予測値

- 勾配のリセット:

- 前回の勾配をリセットします。これにより、前回の勾配が次の計算に影響を与えないようにします。

- バックプロパゲーション:

- 損失

lossに基づいて勾配を計算します。

- 損失

- パラメータの更新:

- 計算された勾配を使用して、モデルのパラメータを更新します。

- ログ出力と評価:

- 100ステップごとにログを出力し、モデルの性能を評価します。

model.eval()は、モデルを評価モードに切り替えます。これにより、ドロップアウトやバッチ正規化などのレイヤーが評価モードで動作します。with torch.no_grad()ブロック内では、勾配計算を無効にします。これにより、評価時の計算が効率的になります。r2_score(y_test, Y_pred)を使用して、決定係数(R-squared)を計算します。R-squared は、モデルの予測性能を評価する指標です。np.any(np.isnan(Y_train_pred))とnp.any(np.isnan(Y_test_pred))を使用して、予測値にNaN値が含まれているかどうかをチェックします。NaN値が含まれている場合、エラーメッセージを出力し、ループを終了します。- import pandas as pd

model.train()は、モデルを訓練モードに戻します。print(f"Step {step}: Loss = {loss.item()}, R-squared (Train) = {r2_train}, R-squared (Test) = {r2_test}")は、現在のステップ、損失、トレーニングデータとテストデータの決定係数をログに出力します。

- 決定係数について

| 状況 | 説明 | 判断基準 |

|---|---|---|

| トレーニングデータの決定係数が高く、テストデータの決定係数が低い | 過学習が発生している可能性が高い。 | モデルがトレーニングデータに過度に適合しており、テストデータでの汎化性能が低い。 |

| トレーニングデータとテストデータの決定係数がほぼ同じ | 過学習が発生していないと考えられる。 | モデルがデータ全体の分散を適切に説明しており、汎化性能が高い。 |

| トレーニングデータとテストデータの決定係数がどちらも低い | モデルがデータを十分に学習できていない可能性がある(アンダーフィットの可能性)。 | モデルの容量不足、特徴量不足、または不適切なハイパーパラメータが原因。 |

最終的なモデルのパラメータを出力

for name, param in model.named_parameters():

print(f"{name}: {param.data}")fc1.weight: tensor([[ 0.1038, -0.2549, -0.2534, -0.2532, -0.2381, -0.0308, -0.2129, -0.0486],

[-0.2793, 0.0695, -0.1803, 0.3256, -0.2593, 0.3121, -0.1401, -0.2626],

[ 0.0227, -0.2128, 0.0705, -0.2593, 0.3119, -0.0848, 0.3080, 0.2504],

...

0.1933, 0.4457, -0.2168, 0.3370, -0.1079, 0.1026, 0.2219, 0.1265,

0.0422, 0.0718, -0.1204, -0.0770, -0.0084, 0.1158, -0.0554, 0.1743,

0.0972, -0.0305, -0.0323, 0.0205, -0.0200, -0.1119, 0.1084, 0.0947]])

fc2.bias: tensor([0.9751])8つの入力値の重みとバイアスはオンライン学習を経て更新され、最終的な値が出力されます。

model.named_parameters()は、モデルの全てのパラメータ(重みとバイアス)とその名前を取得します。param.dataは、パラメータの値を取得します。paramはPyTorchのテンソルであり、data 属性を使用してその値を取得します。

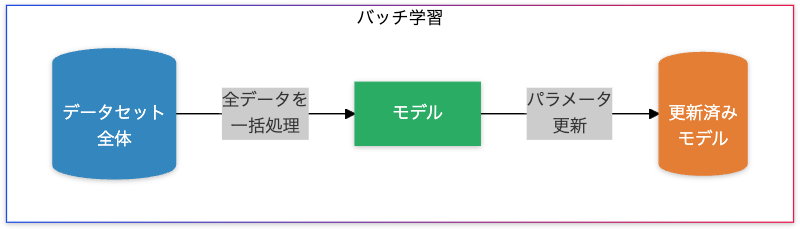

バッチ学習(Batch Learning)

データ処理方法:

全データを一括で処理し、損失を計算してからパラメータを更新します。

特徴

- 精度が高い勾配計算

- 全データを使用するため、勾配の推定が正確。

- デメリット

- 必要なメモリ量が膨大。

- データ量が増えると計算コストが急増。

使用例:

- 画像分類タスク

- データセット全体を使い、精密な分類モデルを構築。

- 文書分類

- 固定された大量のデータセットを一括で学習。

損失関数:バッチ学習では、データ全体にわたる平均損失が計算されます。

$$ L = \frac{1}{N} \sum_{i=1}^{N} l(y_i, \hat{y}_i)$$

$N$:データの総数。

利点と課題

- 利点

- 正確な勾配計算により、安定した収束が期待できる。

- 課題

- 計算資源の制約が大きく、リアルタイム性には適さない。

- データセット全体を収集しておく必要がある。

バッチ学習の実装例

今回はIrisのデータセットを使ってバッチ学習の実装を行います。Irisのデータセットは150サンプルしかなく、非常に小さいデータセットであるため、全てのデータを一度にメモリにロードして処理することが容易であり、バッチ学習が適していると言えます。

ライブラリのインポート

import torch

import torch.nn as nn

import torch.optim as optim

from sklearn.datasets import load_iris

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_splitシンプルな非線形分類モデル(多層パーセプトロン)の定義

class NeuralNetworkModel(nn.Module):

def __init__(self, input_dim):

super(NeuralNetworkModel, self).__init__()

self.model = nn.Sequential(

nn.Linear(input_dim, 64), # 入力層から隠れ層1

nn.ReLU(), # 活性化関数

nn.Linear(64, 32), # 隠れ層1から隠れ層2

nn.ReLU(), # 活性化関数

nn.Linear(32, 3) # 隠れ層2から出力層(3クラス分類)

)

def forward(self, x):

return self.model(x)super(NeuralNetworkModel, self).__init__()は、親クラス(nn.Module)のコンストラクタを呼び出しています。これにより、親クラスの初期化処理が行われます。self.model = nn.Sequential(...)は、モデルの層を順番に定義するためのコンテナです。nn.Sequentialを使用することで、層を順番に適用することができます。nn.Linear(input_dim, 64)は、入力層から最初の隠れ層への全結合層(線形層)を定義しています。input_dimは入力の次元数、64は隠れ層のユニット数です。nn.ReLU()は、ReLU(Rectified Linear Unit)活性化関数を定義しています。これは、非線形性を導入するために使用されます。nn.Linear(64, 32)は、最初の隠れ層から次の隠れ層への全結合層を定義しています。64は前の層のユニット数、32は次の隠れ層のユニット数です。nn.Linear(32, 3)は、最後の隠れ層から出力層への全結合層を定義しています。32は前の層のユニット数、3は出力のクラス数です(Irisデータセットの場合、3クラス分類)。

データの読み込みと前処理

アイリスのデータセットを読み込み、データの標準化、データの分割を行います。

iris = load_iris()

X = iris.data

y = iris.target

# データの標準化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# データの分割

X_train, X_test, y_train, y_test = train_test_split(

X_scaled, y, test_size=0.2, random_state=42, stratify=y

)データをPyTorchのテンソルに変換

X_train = torch.tensor(X_train, dtype=torch.float32)

X_test = torch.tensor(X_test, dtype=torch.float32)

y_train = torch.tensor(y_train, dtype=torch.long)

y_test = torch.tensor(y_test, dtype=torch.long)デバイスの設定

GPUが利用可能な場合はGPUを使用し、そうでない場合はCPUを使用します。

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f'Using device: {device}')モデル、損失関数、最適化アルゴリズムの初期化

このコードは、モデル、損失関数、および最適化アルゴリズムの初期化を行っています。

input_dim = X_train.shape[1]

model = NeuralNetworkModel(input_dim).to(device)

criterion = nn.CrossEntropyLoss() # クロスエントロピー損失

optimizer = optim.Adam(model.parameters(), lr=0.001) # AdamオプティマイザX_train.shape[1]は、トレーニングデータの特徴量の数を取得します。input_dimには、Irisデータセットの特徴量の数(4)が格納されます。NeuralNetworkModelクラスのインスタンスを作成します。input_dimは入力層の次元数を指定します。nn.CrossEntropyLossは、分類タスクにおいてよく使用される損失関数です。クロスエントロピー損失は、モデルの予測と実際のラベルとの間の誤差を計算します。- この損失関数は、ソフトマックス関数と負の対数尤度損失を組み合わせたもので、多クラス分類タスクに適しています。https://shion.blog/the-9th-machine-learning-workshop_1/#toc43

データをデバイスに転送

このコードは、トレーニングデータとテストデータを指定されたデバイス(GPUまたはCPU)に転送する処理を行っています。これにより、データがモデルと同じデバイス上で処理されるようになります。

X_train = X_train.to(device)

y_train = y_train.to(device)

X_test = X_test.to(device)

y_test = y_test.to(device)バッチ学習ループ

このコードは、Irisデータセットを使用してシンプルな多層パーセプトロン(MLP)モデルをバッチ学習でトレーニングする部分です。

# バッチ学習ループ

num_epochs = 100 # エポック数

for epoch in range(num_epochs):

model.train() # 訓練モード

# 勾配をリセット

optimizer.zero_grad()

# モデルの予測

outputs = model(X_train)

# 損失の計算

loss = criterion(outputs, y_train)

# 勾配の計算とパラメータの更新

loss.backward()

optimizer.step()

# ログ出力と評価

if (epoch + 1) % 10 == 0: # 10エポックごとにログを出力

model.eval() # 評価モード

with torch.no_grad():

# 訓練データの予測

train_outputs = model(X_train)

_, train_preds = torch.max(train_outputs, 1)

accuracy_train = (train_preds == y_train).sum().item() / y_train.size(0)

# テストデータの予測

test_outputs = model(X_test)

_, test_preds = torch.max(test_outputs, 1)

accuracy_test = (test_preds == y_test).sum().item() / y_test.size(0)

print(f"Epoch {epoch + 1}: Loss = {loss.item():.4f}, "

f"Accuracy (Train) = {accuracy_train:.4f}, "

f"Accuracy (Test) = {accuracy_test:.4f}")Using device: cpu

Epoch 10: Loss = 0.9473, Accuracy (Train) = 0.8083, Accuracy (Test) = 0.8000

Epoch 20: Loss = 0.7984, Accuracy (Train) = 0.8583, Accuracy (Test) = 0.8000

Epoch 30: Loss = 0.6504, Accuracy (Train) = 0.8833, Accuracy (Test) = 0.7667

Epoch 40: Loss = 0.5238, Accuracy (Train) = 0.8667, Accuracy (Test) = 0.8000

Epoch 50: Loss = 0.4285, Accuracy (Train) = 0.8750, Accuracy (Test) = 0.8000

Epoch 60: Loss = 0.3594, Accuracy (Train) = 0.8917, Accuracy (Test) = 0.7667

Epoch 70: Loss = 0.3056, Accuracy (Train) = 0.9250, Accuracy (Test) = 0.8333

Epoch 80: Loss = 0.2603, Accuracy (Train) = 0.9250, Accuracy (Test) = 0.8667

Epoch 90: Loss = 0.2193, Accuracy (Train) = 0.9250, Accuracy (Test) = 0.9000

Epoch 100: Loss = 0.1821, Accuracy (Train) = 0.9583, Accuracy (Test) = 0.9000最終的なモデルのパラメータを出力

for name, param in model.named_parameters():

print(f"{name}: {param.data}")model.0.weight: tensor([[ 5.3092e-01, 3.0507e-01, -3.2453e-01, 4.1645e-01],

[-4.3171e-01, 3.9466e-01, 2.6941e-01, 2.2325e-01],

[ 3.3881e-01, -5.1786e-01, 3.6361e-01, -3.1159e-01],

[ 4.9230e-01, -1.9013e-01, 3.0597e-03, -3.6174e-01],

...

0.2088, -0.0961, 0.1437, 0.1756, -0.1813, -0.2467, -0.1940, -0.0985,

0.1204, 0.2737, -0.1081, -0.1735, 0.1655, 0.0301, 0.1918, 0.0942,

-0.1395, -0.0965, -0.1541, 0.1781, -0.0656, 0.0986, 0.1466, -0.2550]])

model.4.bias: tensor([-0.1315, 0.1318, -0.1750])ミニバッチ学習

ミニバッチ学習と人間の脳の類似点

ミニバッチ学習は、大量のデータを一度に処理するバッチ学習と、逐次処理を行うオンライン学習の中間的な手法です。人間の脳においては、段階的な学習や反復的なトレーニングに似ています。たとえば、スポーツや音楽の練習では、全体のスキルを一度に学ぶのではなく、部分的な動作を繰り返し練習して統合するアプローチがとられます。このように、分割された情報を効率的に処理し、それを統合的な理解に結びつけるプロセスが、ミニバッチ学習の分割処理と類似しています。また、ミニバッチ学習ではデータのランダム性を利用して多様なパターンを学ぶため、人間が異なる状況で知識を応用しながら学ぶ「経験の蓄積」にも対応します。一方で、バッチサイズ(学習単位)の選択による効果の違いは、人間の注意力や集中時間の変化と関連付けて考えられます。ミニバッチ学習は効率性と柔軟性を両立した学習法として、脳の段階的適応をうまく模倣しています。

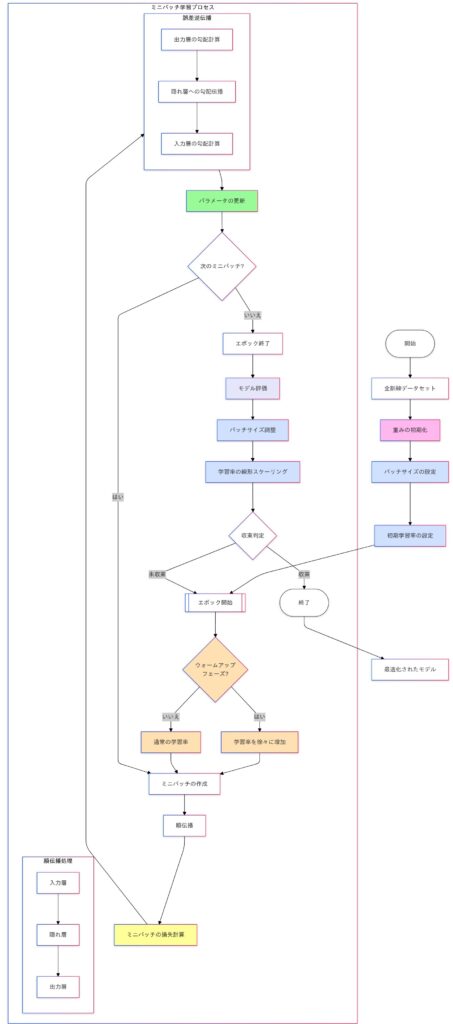

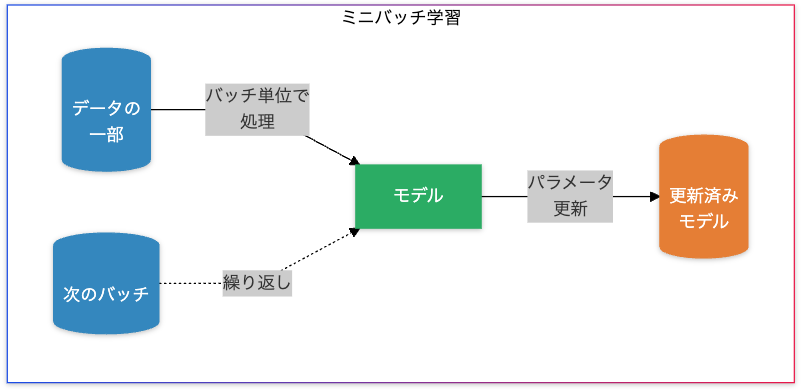

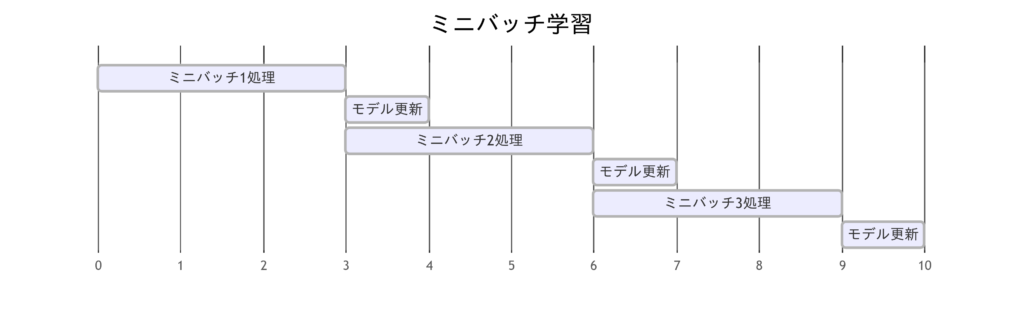

ミニバッチ学習(Mini-Batch Learning)

データ処理方法:

データを小さなバッチ(部分集合)に分割し、各バッチごとに損失を計算・更新します。

特徴:

- トレードオフの優位性

- バッチ学習とオンライン学習の中間的な方法。

- 安定性と効率性

- 小さなバッチにより、勾配計算の安定性と計算効率を両立。

使用例:

- 一般的なディープラーニング:GPUの並列処理を活用する。

- 大規模データセット:全体を処理せずとも学習可能。

損失関数:ミニバッチサイズ $B$ を用いた場合の損失関数は次のように表されます。

$$ L = \frac{1}{B} \sum_{i=1}^{B} l(y_i, \hat{y}_i)$$

$B$:バッチサイズ。

利点と課題

- 利点

- バッチサイズに応じた柔軟性。

- 計算リソースの効率的利用。

- 課題

- 適切なバッチサイズの選択が必要(小さすぎると収束が不安定、大きすぎると一般化性能が低下)

バッチサイズの調整方法

実験的にバッチサイズを調整

| バッチサイズ | 特徴 | メリット | デメリット | 適用シナリオ |

|---|---|---|---|---|

| 小さいサイズ(例: 16, 32) | 勾配ノイズが多く、モデル更新が頻繁。メモリ使用量が少ない。 | – メモリ効率が良い – ロバスト性が向上する可能性- 小型GPUで処理可能 |

– 勾配ノイズが大きく、収束が不安定になる場合がある- 訓練時間が長くなる場合がある | – 小型データセット – モバイル環境や軽量モデルの訓練 |

| 中程度サイズ(例: 64, 128) | 小さすぎず、大きすぎないバランス。勾配のばらつきを抑えながらもメモリ使用量を節約。 | – トレードオフが最適化されやすい – 訓練の安定性と速度のバランスが良い |

– 最適化に調整が必要な場合がある | – 一般的な設定 – モデルの検証段階 |

| 大きいサイズ(例: 256, 512) | 勾配のばらつきが少なく、計算効率が高い。ただし、メモリ消費が多い。 | – 計算効率が向上 – 勾配が安定し、収束がスムーズ |

– 大型メモリが必要 – 局所解に陥るリスク – 汎化性能が低下する場合がある |

– 大型データセット – ハイパフォーマンスGPU環境 |

| 非常に大きいサイズ(例: 1024以上) | ほぼ完全なバッチ学習に近く、計算効率は最大。ただし汎化性能が大幅に低下するリスクがある。 | – 安定した勾配 – 効率的なGPU利用 |

– 過剰なメモリ使用量 – 過学習のリスクが高まる |

– バッチ学習を意図した特殊なシナリオ – 高性能サーバー環境 |

実験プロセス

- 小さいバッチサイズで開始:

- 初期の収束挙動と勾配ノイズの影響を評価。

- 訓練時間の長短を記録し、損失曲線の安定性を観察。

- 中程度のサイズを試す:

- トレードオフのバランスを評価。

- 初期学習率を調整し、収束の速度を観察。

- 大きいサイズでテスト:

- 訓練の高速化を目指し、汎化性能を評価。

- 訓練後、検証データで過学習がないかチェック。

- 性能の比較と最適化:

- 損失曲線、収束速度、検証精度を比較して最適なサイズを選択。

学習率とバッチサイズのスケーリング

バッチサイズが大きくなるほど、学習率を適切に増加させる必要があります。これは、大きなバッチサイズでは計算される勾配がより安定するためです。

- 線形スケーリングルール

$$\eta_{\text{new}} = \eta_{\text{original}} \times \frac{\text{batch size}_{\text{new}}}{\text{batch size}_{\text{original}}}$$

$η_{new}$:新しい学習率、$η_{original}$:元の学習率

実装例)

- 元の学習率が 0.01 で、元のバッチサイズが 32、新しいバッチサイズが 128 の場合

$$\eta_{\text{new}} = 0.01 \times \frac{128}{32} = 0.04$$

# 学習率とバッチサイズをスケーリングする関数

def scale_learning_rate(original_lr, original_batch_size, new_batch_size):

"""

学習率をバッチサイズに応じてスケーリングします。

Parameters:

original_lr (float): 元の学習率

original_batch_size (int): 元のバッチサイズ

new_batch_size (int): 新しいバッチサイズ

Returns:

float: 新しい学習率

"""

return original_lr * (new_batch_size / original_batch_size)

# 元の学習率とバッチサイズ

original_lr = 0.01 # 元の学習率

original_batch_size = 32 # 元のバッチサイズ

# 新しいバッチサイズ

new_batch_size = 128

# 新しい学習率の計算

new_lr = scale_learning_rate(original_lr, original_batch_size, new_batch_size)

# 結果の表示

print(f"元の学習率: {original_lr}")

print(f"新しい学習率: {new_lr}")結果の例)

元の学習率: 0.01

新しい学習率: 0.04- ウォームアップスケジュール

- 最初は学習率を小さく設定し、一定エポックごとに学習率を増加させて安定化を図る。

実装例)

import matplotlib.pyplot as plt

# ウォームアップスケジュールを定義する関数

def warmup_schedule(total_epochs, base_lr, max_lr, warmup_epochs):

"""

ウォームアップスケジュールを生成します。

Parameters:

total_epochs (int): 総エポック数

base_lr (float): 初期学習率

max_lr (float): 最大学習率

warmup_epochs (int): ウォームアップ期間(エポック数)

Returns:

list: 各エポックの学習率

"""

learning_rates = []

for epoch in range(1, total_epochs + 1):

if epoch <= warmup_epochs:

# 線形増加

lr = base_lr + (max_lr - base_lr) * (epoch / warmup_epochs)

else:

# ウォームアップ後は一定

lr = max_lr

learning_rates.append(lr)

return learning_rates

# パラメータ設定

total_epochs = 20 # 総エポック数

base_lr = 0.001 # 初期学習率

max_lr = 0.01 # 最大学習率

warmup_epochs = 5 # ウォームアップ期間(エポック数)

# 学習率スケジュールの生成

learning_rates = warmup_schedule(total_epochs, base_lr, max_lr, warmup_epochs)

# 結果の表示

print("各エポックの学習率:")

for epoch, lr in enumerate(learning_rates, start=1):

print(f"Epoch {epoch}: {lr:.6f}")

# 学習率スケジュールをプロット

plt.plot(range(1, total_epochs + 1), learning_rates, marker='o')

plt.title("Learning Rate Warmup Schedule")

plt.xlabel("Epoch")

plt.ylabel("Learning Rate")

plt.grid()

plt.show()結果の例)

各エポックの学習率:

Epoch 1: 0.002800

Epoch 2: 0.004600

Epoch 3: 0.006400

Epoch 4: 0.008200

Epoch 5: 0.010000

Epoch 6: 0.010000

バッチサイズが学習に与える影響

| バッチサイズ | 特徴 | 影響 | メリット | デメリット |

|---|---|---|---|---|

| 小バッチサイズ | – 学習ノイズが多い – 勾配が多様に変化 |

– 収束速度が遅くなる可能性 – モデルの一般化性能が向上 |

– 過学習を抑制- モデルの汎化性能向上 – メモリ効率が良い |

– 学習が不安定になる場合がある |

| 大バッチサイズ | – 勾配の計算が正確 – 収束が安定 |

– 局所的最適解に陥りやすい – 一般化性能が低下する場合がある |

– 収束速度が速い – 損失が滑らかに減少 – GPU効率が高い |

– 過剰なメモリ使用 – 汎化性能が低下するリスク |

ミニバッチ学習の実装例

今回は比較的大きなデータである、CIFAR-10データセットを使用してシンプルなCNN(畳み込みニューラルネットワーク)モデルをバッチ学習で実装します。

ライブラリのインポート

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

from torch.utils.data import DataLoaderシンプルなCNNモデルの定義

ここではまだ説明を行なっていませんが、CNNモデルを用いてモデルの定義を行います。CNNは次回のブログで詳細の説明を行います。

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2, padding=0)

self.fc1 = nn.Linear(64 * 8 * 8, 512)

self.fc2 = nn.Linear(512, 10)

self.relu = nn.ReLU()

self.dropout = nn.Dropout(0.5)

def forward(self, x):

x = self.pool(self.relu(self.conv1(x)))

x = self.pool(self.relu(self.conv2(x)))

x = x.view(-1, 64 * 8 * 8)

x = self.relu(self.fc1(x))

x = self.dropout(x)

x = self.fc2(x)

return xデータの前処理

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])- transforms.Compose

- transforms.Composeは、複数の変換を順番に適用するためのコンテナです。この場合、2つの変換(transforms.ToTensor と transforms.Normalize)を順番に適用します。

- transforms.ToTensor

- transforms.ToTensorは、PIL画像またはNumPy配列をPyTorchのテンソルに変換します。つまり画像のピクセル値を

[0, 255]の範囲から[0.0, 1.0]の範囲にスケーリングを行なっています。

- transforms.ToTensorは、PIL画像またはNumPy配列をPyTorchのテンソルに変換します。つまり画像のピクセル値を

- transforms.Normalize

- transforms.Normalizeは、テンソルの各チャンネル(RGB)を正規化します。この場合、各チャンネルの平均を

0.5、標準偏差を0.5として正規化します。

- transforms.Normalizeは、テンソルの各チャンネル(RGB)を正規化します。この場合、各チャンネルの平均を

CIFAR-10データセットの読み込み

torchvision.datasets.CIFAR10を使用して、CIFAR-10データセットを読み込みます。DataLoaderを使用して、トレーニングデータとテストデータのバッチを作成します。

trainset = torchvision.datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

trainloader = DataLoader(trainset, batch_size=64, shuffle=True, num_workers=2)

testset = torchvision.datasets.CIFAR10(root='./data', train=False,

download=True, transform=transform)

testloader = DataLoader(testset, batch_size=64, shuffle=False, num_workers=2)デバイスの設定

GPUが利用可能な場合はGPUを使用し、そうでない場合はCPUを使用します。

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f'Using device: {device}')モデル、損失関数、最適化アルゴリズムの初期化

シンプルなCNNモデルのインスタンスを作成し、損失関数と最適化アルゴリズムを設定します。

model = SimpleCNN().to(device)

criterion = nn.CrossEntropyLoss() # クロスエントロピー損失

optimizer = optim.Adam(model.parameters(), lr=0.001) # Adamオプティマイザミニバッチ学習ループ

num_epochs = 10 # エポック数

for epoch in range(num_epochs):

model.train() # 訓練モード

# ミニバッチごとのトレーニングループ

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

inputs, labels = inputs.to(device), labels.to(device)

# 勾配をリセット

optimizer.zero_grad()

# 順伝播

outputs = model(inputs)

# 損失の計算

loss = criterion(outputs, labels)

# 勾配の計算とパラメータの更新

loss.backward()

optimizer.step()

# 損失の累積

running_loss += loss.item()

if i % 100 == 99: # 100ミニバッチごとにログを出力

print(f'[Epoch {epoch + 1}, Batch {i + 1}] loss: {running_loss / 100:.3f}')

running_loss = 0.0

# テストデータでの評価

model.eval() # 評価モード

correct = 0

total = 0

with torch.no_grad():

for data in testloader:

images, labels = data

images, labels = images.to(device), labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total:.2f}%')

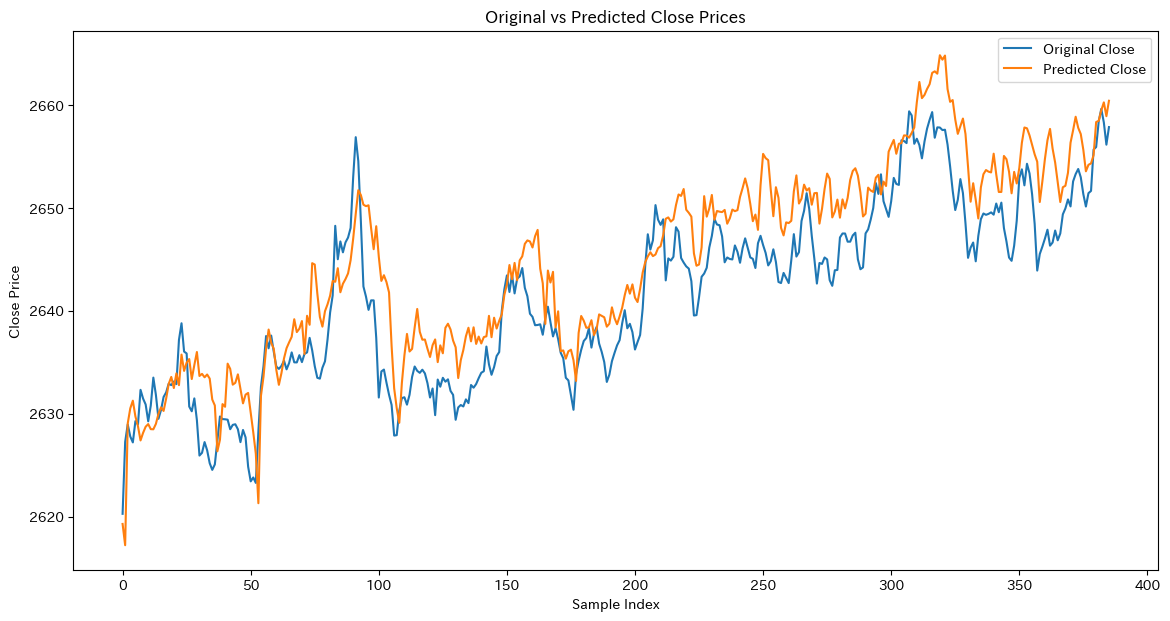

print('Finished Training')トレーニング損失の減少

・各エポックごとにトレーニング損失が減少していることがわかります。

Using device: cpu

[Epoch 1, Batch 100] loss: 1.906

[Epoch 1, Batch 200] loss: 1.554

[Epoch 1, Batch 300] loss: 1.465

Accuracy of the network on the 10000 test images: 59.92%

[Epoch 2, Batch 100] loss: 1.110

[Epoch 2, Batch 200] loss: 1.082

[Epoch 2, Batch 300] loss: 1.080

テストデータの精度の向上

・各エポックの終わりにテストデータでの精度が計算され、精度が向上していることがわかります。

・モデルがトレーニングデータだけでなく、テストデータに対しても良い性能を示していることがわかります。

Accuracy of the network on the 10000 test images: 66.54%

[Epoch 3, Batch 100] loss: 0.912

[Epoch 3, Batch 200] loss: 0.895

[Epoch 3, Batch 300] loss: 0.931- エポックごとのトレーニングループ:

- 各エポックの開始時にモデルを訓練モードに設定します。

- ミニバッチごとのトレーニングループ:

- trainloader からミニバッチを取得し、入力データとラベルに分け、デバイスに転送します。

- 勾配をリセットし、順伝播、損失の計算、勾配の計算とパラメータの更新を行います。

- 各ミニバッチの損失を累積し、100ミニバッチごとに平均損失をログに出力します。

- テストデータでの評価:

- 各エポックの終わりにモデルを評価モードに設定し、テストデータでモデルを評価します。

torch.no_grad()ブロック内で勾配計算を無効にし、テストデータでモデルを評価します。- テストデータの予測値

outputsを計算し、正解数correctと総数totalを累積します。 - テストデータの精度を計算し、ログに出力します。

- トレーニングの終了:

- トレーニングが終了したことをログに出力します。

GPU並列処理の活用術

GPU並列処理とバッチ学習は、効率的なモデルトレーニングにおいて密接に関連しています。バッチ学習はデータを一括で処理するため、行列演算が中心となります。この行列演算はGPUが得意とする大量の並列計算に最適化されており、計算速度を大幅に向上させます。また、大きなバッチサイズを選択することでGPUのリソースを最大限に活用でき、トレーニングの効率がさらに高まります。その結果、大規模データセットや複雑なモデルでも短時間での学習が可能になります。

GPU並列処理の仕組み

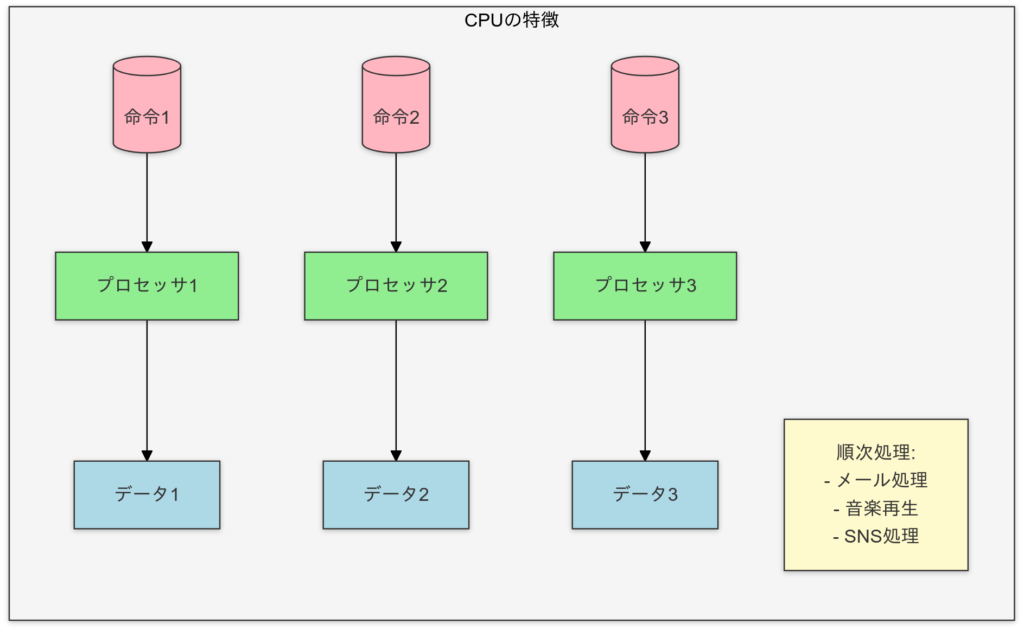

CPUとGPUの違い

- CPU (Central Processing Unit)

- 少数の強力なコアを持つ。

- シリアルタスク(逐次処理)に優れる。

CPUの特徴

CPUは人間の脳で例えると「論理的な思考を行う部分」に相当します。少数の強力な「ニューロン」(コア)が存在し、複雑な計算や意思決定を順序立てて処理します。たとえば、難しい数学問題をじっくり解くような作業が得意です。計算処理では、逐次的なタスク(シングルスレッド処理)を素早く正確にこなします。ただし、同時に多くのタスクを処理する場合は限界があります。そのため、タスクが分散される並列処理には不向きです。

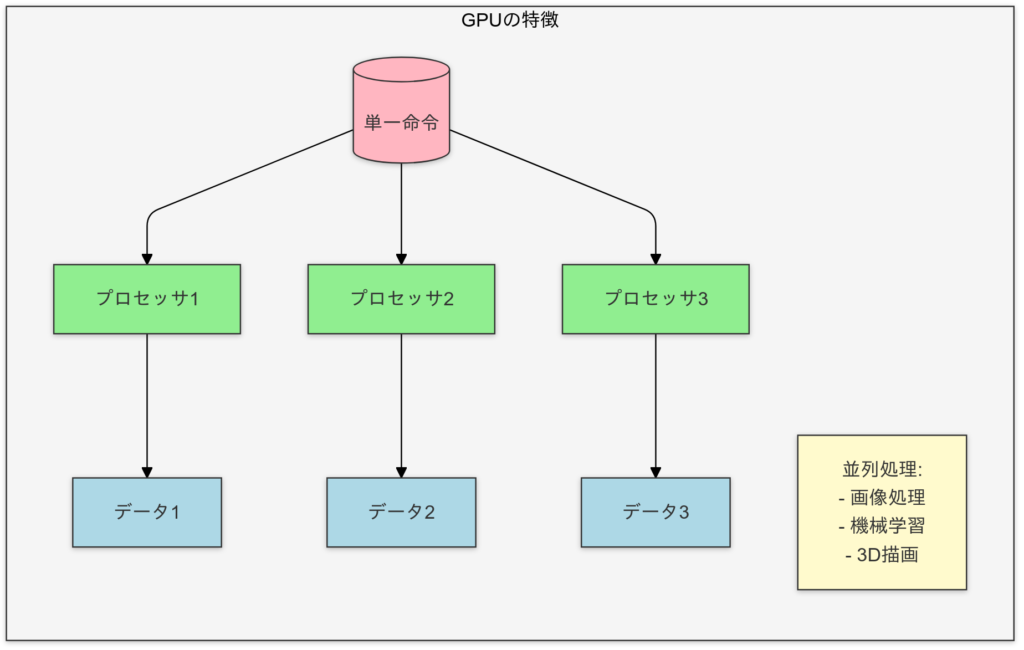

- GPU(Graphics Processing Unit)

- 数千のシンプルなコアを持つ。

- 行列演算のようなデータ並列タスクに最適。

GPUの特徴

GPUは脳で例えると「視覚処理やパターン認識を行う部分」に相当します。多数の単純な「ニューロン」(コア)が並列に配置され、シンプルなタスクを一斉に処理します。計算処理では、行列演算や画像処理など、大量のデータを同時に計算する並列タスクが得意です。これは、人間が視覚情報を短時間で処理する働きに似ています。ただし、複雑で順序が必要な処理は苦手です。

GPUは、大量の数値演算を同時に実行できるため、ディープラーニングの行列演算(例: フォワード/バックプロパゲーション)において特に有利です。

GPU並列処理の概要

- データを小さな計算単位(スレッド)に分割し、それぞれを並列処理。

- 高速なビデオメモリ(VRAM)にアクセスし、データ転送を効率化。

- 行列の掛け算や畳み込み演算を専用のハードウェアで加速。

GPUを使うメリット

| メリット | 詳細 | 効果 |

|---|---|---|

| 高速化 | – 大規模データセットを短時間で処理可能- 複雑なモデル(例: トランスフォーマー)の学習時間を短縮 | – モデル学習の効率化 – 計算速度の向上 |

| メモリ効率 | – VRAMを活用して大量データを保持可能- バッチサイズを増加させて学習効率を向上 | – メモリ制約を軽減- バッチ処理のスループット向上 |

| 柔軟性 | – モデルやデータをGPUに割り当てて並列実行可能 | – 複数のタスクを同時に実行 – ハードウェアの最大利用 |

GPUの有効化と設定

NVIDIA GPUの有効化と設定

NVIDIAのGPUはディープラーニングの主要な選択肢で、CUDA (Compute Unified Device Architecture) を利用します。CUDAはGPUを計算タスクに特化させたAPIとライブラリを提供します。

前提条件

- 対応ハードウェア:NVIDIA製のGPU。

- OS:Windows、Linux。

- ソフトウェア:

- NVIDIAドライバ

- CUDA Toolkit

- cuDNN (NVIDIAのディープラーニング向けライブラリ)

設定手順

- NVIDIAドライバのインストール

- NVIDIA公式サイト から、使用するGPUに対応する最新ドライバをダウンロードしてインストール。

- CUDA Toolkitのインストール

- CUDA Toolkit公式サイト から適切なバージョンをダウンロード。

- ダウンロードしたファイルをCUDAインストールディレクトリに展開。

- cuDNNのインストール

- cuDNN公式サイト からCUDAバージョンに対応するcuDNNをダウンロード。

- ダウンロードしたファイルをCUDAインストールディレクトリに展開。

PyTorchでの設定

import torch

print(torch.cuda.is_available()) # Trueなら有効macの場合はこうなります。

GPUデバイスの使用

モデルやデータをGPUに転送して計算。GPUを使用するには、モデルとテンソル(データ)をGPUに移動する必要があります。

# デバイスの設定

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# モデルをデバイスに転送

model = model.to(device)

# データをデバイスに転送

data = data.to(device)pin_memory=True でデータ転送を高速化

pin_memory=True オプションを使用してデータの転送を高速化が可能です。以下はその例です。

# データローダーの作成

batch_size = 16

pin_memory = device.type == 'cuda' # CUDAが利用可能な場合にのみpin_memory=Trueを設定

train_dataset = TensorDataset(X_train, y_train)

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True, pin_memory=pin_memory)複数GPUの活用(データ並列化)

- データ並列処理

- 複数GPUを用いる場合、

torch.nn.DataParallelまたはtorch.nn.parallel.DistributedDataParallelを使用します。

これにより、データを複数のGPUに分散して処理可能です。

- 複数GPUを用いる場合、

# DataParallelを使用した例

model = nn.DataParallel(model)

model.to(device)Apple Silicon GPUの有効化と設定

Apple Silicon (M1、M2) のGPUはMetal APIを活用し、Metal Performance Shaders (MPS) がPyTorch 1.12以降でサポートされています。

前提条件

- 対応ハードウェア: M1、M2チップを搭載したMac。

- OS:macOS Monterey 12.3以降。

- ソフトウェア:

- PyTorch 1.12以降

- macOSに組み込まれたMetal API(別途インストール不要)

設定手順

- PyTorchのインストール

- Metalバックエンド対応のPyTorchをインストール。

pip install torch torchvision torchaudioGPUデバイスの確認

- Metalバックエンドが有効か確認。

import torch

print(torch.backends.mps.is_available()) # Trueなら有効

GPUデバイスの使用

- Metal GPU (mps) を指定して計算。GPUを使用するには、モデルとテンソル(データ)をGPUに移動する必要があります。

# デバイスの設定

device = torch.device('mps' if torch.backends.mps.is_available() else 'cpu')

# モデルをデバイスに転送

model = model.to(device)

# データをデバイスに転送

data = data.to(device)pin_memory=True でデータ転送を高速化

pin_memory=True オプションを使用してデータの転送を高速化が可能です。以下はその例です。

# データローダーの作成

batch_size = 16

train_dataset = TensorDataset(X_train, y_train)

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True, pin_memory=True)注意点

- 現在の所、Apple Silicon GPUでは複数GPUの活用は未対応でした。

Intel GPUの有効化と設定

Intel GPUは、OpenCLまたはoneAPIによって計算に利用できます。Intelは近年、oneAPIを推進しており、ディープラーニング向けライブラリとしてIntel Extension for PyTorchを提供しています。

前提条件

- 対応ハードウェア:Intel製統合GPU(Iris Xeなど)。

- OS:Windows、Linux。

- ソフトウェア:

- Intel oneAPI Base Toolkit

- Intel Extension for PyTorch

設定手順

- Intel oneAPI Base Toolkitのインストール

- Intel oneAPI Base Toolkit をインストールします。

- Intel Extension for PyTorchのインストール

- oneAPI GPUで動作するPyTorch拡張をインストール。

pip install intel-extension-for-pytorchPyTorchでの設定

- Intel GPUを利用可能か確認します。GPUを使用するには、モデルとテンソル(データ)をGPUに移動する必要があります。

# デバイスの設定

device = torch.device('opencl' if torch.backends.opencl.is_available() else 'cpu')

# モデルをデバイスに転送

model = model.to(device)

# データをデバイスに転送

data = data.to(device)最適化

- Intel Extension for PyTorchを使用してモデルを最適化。

model = ipex.optimize(model)それぞれのGPUの比較

| GPUプラットフォーム | API / ライブラリ | 利点 | 注意点 |

|---|---|---|---|

| NVIDIA | CUDA, cuDNN | 高速・安定した性能、豊富なライブラリ | 対応GPUが必要、ドライバの管理が必要 |

| Apple Silicon | Metal, MPS | 統合メモリによる効率的なデータ転送 | 一部未対応のPyTorch機能がある |

| Intel | oneAPI, OpenCL | 手軽に統合GPUが利用可能、oneAPIによる最適化 | 性能はNVIDIAやAppleに劣る場合がある |

Kaggle NotebookでのGPU有効化

- Kaggle Notebookでは、GPUを有効にするために「Accelerator」を「GPU」に設定します。その後、

torch.device('cuda')でデバイスを指定します。

GPU活用のベストプラクティス(Apple Silicon)

import torch

import torch.nn as nn

import torch.optim as optim

from sklearn.datasets import load_wine

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from torch.utils.data import DataLoader, TensorDataset

# シンプルな非線形分類モデル(多層パーセプトロン)

class NeuralNetworkModel(nn.Module):

def __init__(self, input_dim):

super(NeuralNetworkModel, self).__init__()

self.model = nn.Sequential(

nn.Linear(input_dim, 64), # 入力層から隠れ層1

nn.ReLU(), # 活性化関数

nn.Linear(64, 32), # 隠れ層1から隠れ層2

nn.ReLU(), # 活性化関数

nn.Linear(32, 3) # 隠れ層2から出力層(3クラス分類)

)

def forward(self, x):

return self.model(x)

# データの読み込み

wine = load_wine()

X = wine.data

y = wine.target

# データの標準化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# データの分割

X_train, X_test, y_train, y_test = train_test_split(

X_scaled, y, test_size=0.2, random_state=42, stratify=y

)

# データをPyTorchのテンソルに変換

X_train = torch.tensor(X_train, dtype=torch.float32)

X_test = torch.tensor(X_test, dtype=torch.float32)

y_train = torch.tensor(y_train, dtype=torch.long)

y_test = torch.tensor(y_test, dtype=torch.long)

# デバイスの設定(Metalが利用可能ならMetalを使用)

device = torch.device('mps' if torch.backends.mps.is_available() else 'cpu')

print(f'Using device: {device}')

# モデルをデバイスに転送

model = NeuralNetworkModel(X_train.shape[1]).to(device)

# データをデバイスに転送

X_train = X_train.to(device)

y_train = y_train.to(device)

X_test = X_test.to(device)

y_test = y_test.to(device)

# モデル、損失関数、最適化アルゴリズムの初期化

criterion = nn.CrossEntropyLoss() # クロスエントロピー損失

optimizer = optim.Adam(model.parameters(), lr=0.001) # 学習率を0.001に設定

# データローダーの作成

batch_size = 16

train_dataset = TensorDataset(X_train, y_train)

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True, pin_memory=True)

# ミニバッチ学習ループ

num_epochs = 100 # エポック数

for epoch in range(num_epochs):

model.train() # 訓練モード

for X_batch, y_batch in train_loader:

X_batch, y_batch = X_batch.to(device), y_batch.to(device)

# 勾配をリセット

optimizer.zero_grad()

# モデルの予測

outputs = model(X_batch)

# 損失の計算

loss = criterion(outputs, y_batch)

# 勾配の計算とパラメータの更新

loss.backward()

optimizer.step()

# ログ出力と評価

if (epoch + 1) % 10 == 0: # 10エポックごとにログを出力

model.eval() # 評価モード

with torch.no_grad():

# 訓練データの予測

train_outputs = model(X_train)

_, train_preds = torch.max(train_outputs, 1)

accuracy_train = (train_preds == y_train).sum().item() / y_train.size(0)

# テストデータの予測

test_outputs = model(X_test)

_, test_preds = torch.max(test_outputs, 1)

accuracy_test = (test_preds == y_test).sum().item() / y_test.size(0)

print(f"Epoch {epoch + 1}: Loss = {loss.item():.4f}, "

f"Accuracy (Train) = {accuracy_train:.4f}, "

f"Accuracy (Test) = {accuracy_test:.4f}")

# 最終的なモデルのパラメータを出力

for name, param in model.named_parameters():

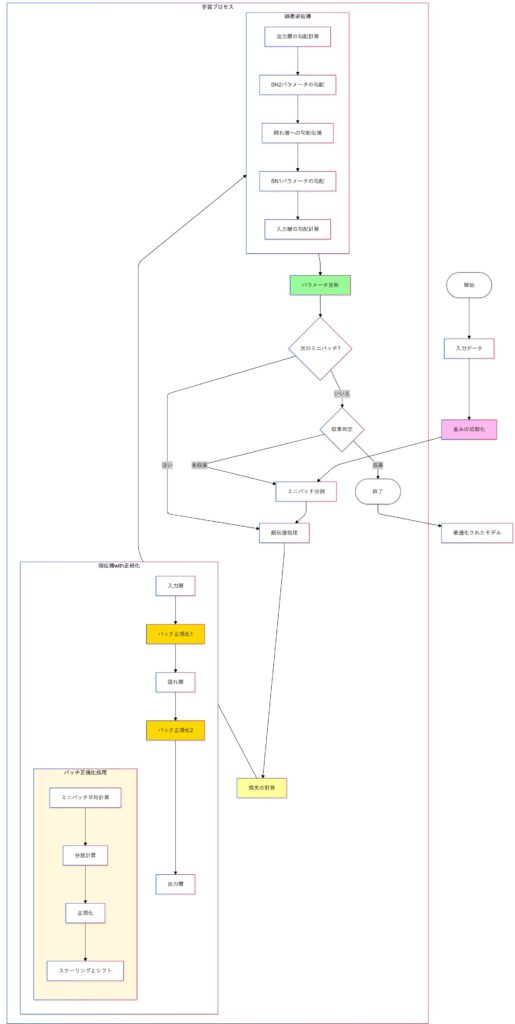

print(f"{name}: {param.data}")バッチ正規化 (Batch Normalization)

バッチ正規化 (Batch Normalization, BN) は、ディープラーニングにおいて学習を安定化し、収束速度を向上させる手法です。

バッチ正規化の背景と目的

ニューラルネットワークの学習時、各層の入力分布が変動する現象を「内部共変量シフト」と呼びます。この現象は、モデルの収束速度を低下させたり、勾配消失・爆発を引き起こす原因となります。

バッチ正規化の目的

バッチ正規化は、各バッチ内で入力特徴量を正規化することで、以下を実現します。

- 各層の入力分布を一定に保つ。

- 学習率を高く設定しても安定性を維持。

- 勾配消失や爆発を防止。

バッチ正規化の処理ステップと数式

ミニバッチ内の平均と分散を計算

- 入力特徴量 $x_i$ に対し、バッチ統計量を計算します。

$$\mu_B = \frac{1}{m} \sum_{i=1}^{m} x_i, \quad \sigma_B^2 = \frac{1}{m} \sum_{i=1}^{m} (x_i – \mu_B)^2$$

$m$:バッチサイズ。$x_i$:バッチ内の $i$-番目のサンプル。

入力特徴量の正規化

バッチ内の特徴量を正規化して、平均0・分散1に調整します。

$$\hat{x}_i = \frac{x_i – \mu_B}{\sqrt{\sigma_B^2 + \epsilon}}$$

$ϵ$ は、分母がゼロになるのを防ぐための小さな定数です。

スケールとシフト

正規化された特徴量に学習可能なパラメータ $γ$(スケール)と $β$(シフト)を適用します。

$$y_i = \gamma \hat{x}_i + \beta$$

これにより、モデルが特徴量の分布を再調整可能になります。

バッチ正規化のメリット

| メリット | 詳細 |

|---|---|

| 収束速度の向上 | 学習率を高く設定可能になり、収束が速くなる。 |

| 勾配消失・爆発の緩和 | 層間の勾配が安定し、深いネットワークでも学習が可能。 |

| 汎化性能の向上 | 過学習の抑制効果も観察される。 |

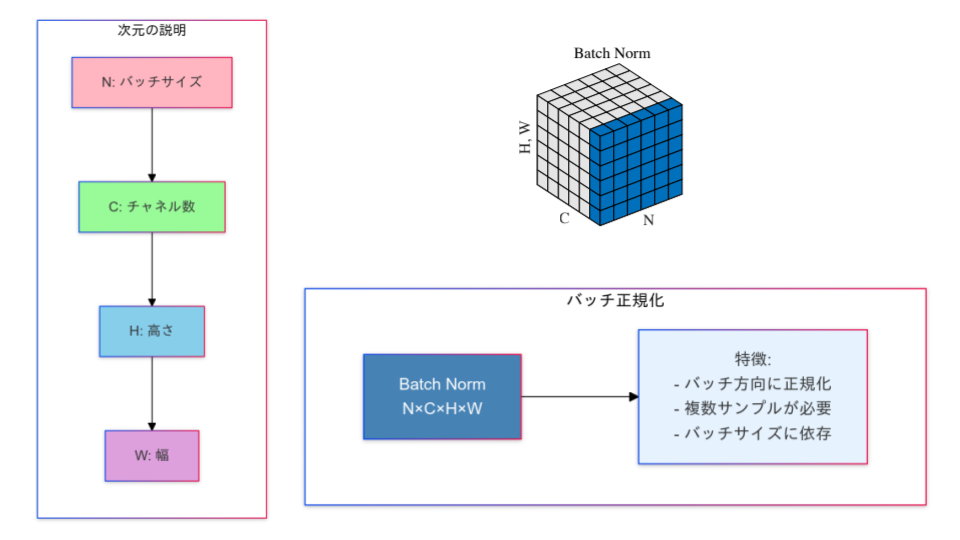

バッチ正規化の図解

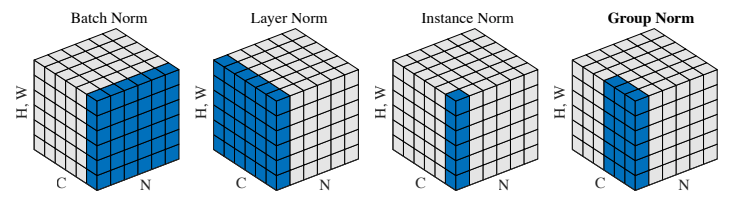

他の正規化手法との違い

バッチ正規化は、特にCNNにおいて広く使われる標準的な手法で、高速な収束と学習の安定性をもたらします。一方で、他の正規化手法には、それぞれ特定のタスクやモデル要件に適した特性があります。例えば、データの構造やバッチサイズの制約、モデルの設計に応じて適切な手法を選ぶことで、モデルの性能を最大限に引き出すことができます。そのため、使用する正規化手法を柔軟に選び分けることが、より効果的な学習を実現する鍵となります。

バッチ正規化

| 正規化手法 | 正規化単位 | 特徴 | 適用例 |

|---|---|---|---|

| バッチ正規化 (BN) | バッチ全体の特徴ごと | – バッチ内の統計を利用し、学習の安定性と収束速度を向上。 – 高い学習率を許容。 – バッチサイズに依存。 |

CNNや大規模データセットの学習。 |

| 正規化手法 | メリット | デメリット |

|---|---|---|

| バッチ正規化 (BN) | – 高い学習率を許容し、収束速度が速い。 – 深いネットワークでも勾配が安定。 – 過学習の抑制効果。 |

– バッチサイズが小さい場合、統計が不安定。 – トレーニングと推論で異なる統計を使用する複雑さ。 |

PyTorchによる正規化手法の実装例

import torch.nn as nn

# バッチ正規化層

bn_layer = nn.BatchNorm2d(32) # 入力チャネル数を指定 (例: 32)レイヤー正規化

| 正規化手法 | 正規化単位 | 特徴 | 適用例 |

|---|---|---|---|

| レイヤー正規化 (LN) | 各サンプルの層全体の特徴量 | – 各サンプルを独立に正規化。 – バッチサイズに依存しないため、小さなバッチサイズやシーケンシャルデータに適合。 |

NLPや時系列データ(RNN, Transformer)。 |

| 正規化手法 | メリット | デメリット |

|---|---|---|

| レイヤー正規化 (LN) | – バッチサイズに依存せず、小さなバッチサイズでの学習が可能。 – シーケンシャルデータやNLPに適合。 |

– CNNのような空間的な特徴を扱うタスクでは効果が限定的。 |

PyTorchによる正規化手法の実装例

# レイヤー正規化層

ln_layer = nn.LayerNorm([64, 64]) # 入力特徴量の形状 (例: 64x64)インスタンス正規化

| 正規化手法 | 正規化単位 | 特徴 | 適用例 |

|---|---|---|---|

| インスタンス正規化 (IN) | 各サンプルのチャネルごと | – 各サンプルのチャネルを独立に正規化。 – バッチ間の依存なし。 – 特にスタイル転移や画像生成タスクに適合。 |

画像生成やスタイル変換。 |

| 正規化手法 | メリット | デメリット |

|---|---|---|

| インスタンス正規化 (IN) | – 各サンプルを独立に正規化するため、スタイル転移や画像生成タスクに効果的。 | – 汎化性能が他の手法に劣る場合がある。 – バッチ間の特徴共有がないため、大規模データでの性能は限定的。 |

PyTorchによる正規化手法の実装例

# インスタンス正規化層

in_layer = nn.InstanceNorm2d(32) # 入力チャネル数を指定 (例: 32)グループ正規化

| 正規化手法 | 正規化単位 | 特徴 | 適用例 |

|---|---|---|---|

| グループ正規化 (GN) | チャネルをいくつかのグループに分割 | – バッチサイズに依存せず、チャネルをグループ単位で正規化。 – 小バッチ環境や3D CNNで有用。 |

小バッチサイズや3Dデータの学習。 |

| 正規化手法 | メリット | デメリット |

|---|---|---|

| グループ正規化 (GN) | – 小バッチサイズや3Dデータで安定性を提供。 – バッチサイズに依存せず、CNNで高い性能を発揮。 |

– グループ数やチャネル数の選択に敏感で、モデル設計時に調整が必要。 |

PyTorchによる正規化手法の実装例

# グループ正規化層

gn_layer = nn.GroupNorm(num_groups=8, num_channels=32) # グループ数とチャネル数を指定最適化アルゴリズムの選択と活用

最適化アルゴリズムとは?

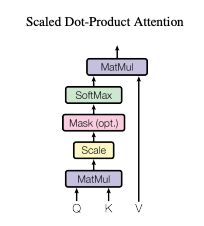

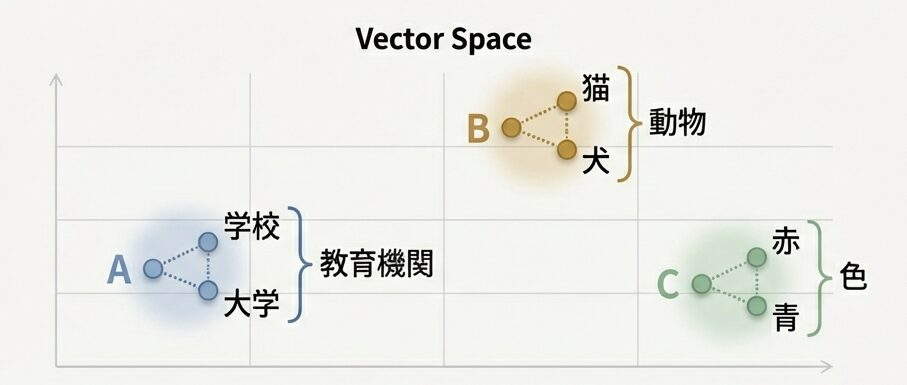

最適化アルゴリズムは、誤差逆伝播法(バックプロパゲーション)と連動して機械学習モデルの学習を支えています。この仕組みは、脳のニューロンがシナプスを通じて信号を伝達し、その強度を経験に基づいて調整するプロセスを模倣しています。誤差逆伝播法では、損失関数の勾配を計算し、その情報を最適化アルゴリズム(例: 勾配降下法やAdam)に渡してパラメータを更新します。ニューロンの学習のように、この反復的な更新によりモデルはデータのパターンを効率的に学習し、精度を高めていきます。この結びつきにより、誤差の伝達と最適化が一体となって機械学習の効果を発揮しています。

最適化アルゴリズムの紹介(最急降下法・SGD)

【第6回】線形回帰とロジスティック回帰の実装と最急降下法の役割で最適化アルゴリズムを紹介しましたが、今回はKaggleなどの実践的なデータサイエンスやディープラーニングのタスクで活用される最適化アルゴリズムを紹介してみようと思います。最急降下法やSGDについては【第6回】のブログを参照して下さい。

最急降下法:

https://shion.blog/the-6th-machine-learning-workshop/#toc8

SGD:

Momentum

Momentumは、勾配降下法の収束速度を向上させるために考案されたアルゴリズムで、過去の勾配を考慮に入れながらパラメータ更新を行います。これにより、振動を抑えつつ効率的に収束することが可能になります。

更新式:

- モーメントの計算:

$$v_t = \beta v_{t-1} + (1 – \beta) g_t$$

- $v_t$: 時刻 $t$ のモーメント(速度)。

- $g_t$: 現在の勾配。

- $β$: モーメントの減衰率(通常 $\beta = 0.9$)。

パラメータの更新:

$$w_{t+1} = w_t – \alpha v_t$$

- $w_t$: 時刻 $t$ のパラメータ。

- $α$: 学習率。

特徴:

| 項目 | 内容 |

|---|---|

| 速度(モーメント)の利用 | 過去の勾配方向を蓄積して「慣性」を持たせ、更新方向をスムーズに調整。局所的な振動(例: 谷間での左右の揺れ)を抑制。 |

| 効率的な収束 | 勾配が一貫した方向に向いている場合、モーメントによる加速効果で収束速度が向上。 |

| スケーラブル | 簡単に計算可能で、さまざまなタスクに適用できる。 |

利点:

| 項目 | 内容 |

|---|---|

| 振動の抑制 | 勾配が急峻な谷の周辺(特に縦に急で横に緩い場合)での振動を低減。 |

| 収束の加速 | 勾配が一貫して変化する場合、より高速に収束。 |

欠点:

| 項目 | 内容 |

|---|---|

| 局所最適解の探索が難しい | 慣性が働きすぎると、細かい最適解を逃す可能性がある。 |

| 学習率の調整が必要 | モーメント係数(β)や学習率(α)の適切な設定が必要。 |

適用例:

- 単純な勾配降下法が振動する場合:

- 非対称なコスト関数(例: 長く狭い谷)において、収束速度を向上。

- CNNや一般的なMLPモデル:

- 深層学習モデルのトレーニングで広く使用。

動作イメージ

Momentumは、物理学の慣性運動を模倣しています。現在の勾配だけでなく、過去の勾配も考慮することで、最適解に向かってスムーズに進むよう設計されています。山や谷の形状に応じて加速や減速を調整しながら、効率的に最適化します。

import numpy as np

import matplotlib.pyplot as plt

def func(x, y):

"""二次関数(楕円形状)の定義"""

return 0.1 * x**2 + y**2

def grad_func(x, y):

"""関数の勾配を計算"""

grad_x = 0.2 * x

grad_y = 2 * y

return np.array([grad_x, grad_y])

def momentum_optimization(x_init, y_init, learning_rate=0.1, momentum=0.9, steps=50):

"""モメンタム最適化の実行"""

x, y = x_init, y_init

v = np.array([0.0, 0.0])

trajectory = [(x, y)]

velocity_history = [v.copy()]

for _ in range(steps):

grad = grad_func(x, y)

v = momentum * v - learning_rate * grad # モメンタム更新式

x, y = x + v[0], y + v[1]

trajectory.append((x, y))

velocity_history.append(v.copy())

return np.array(trajectory), np.array(velocity_history)

def plot_contour_with_trajectory(func, trajectory, velocity_history, levels=20):

"""等高線と最適化の軌跡をプロット"""

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = func(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=levels, cmap="cool")

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

plt.plot(trajectory[:, 0], trajectory[:, 1], 'ro-', markersize=5, label="Momentum Path")

# 初期点と最終点のマーカー

plt.scatter(trajectory[0, 0], trajectory[0, 1], color='green', s=100, label='Start')

plt.scatter(trajectory[-1, 0], trajectory[-1, 1], color='blue', s=100, label='End')

# 矢印を追加して速度ベクトルを示す(間引いて表示)

for i in range(0, len(trajectory), 5):

plt.arrow(trajectory[i, 0], trajectory[i, 1],

velocity_history[i, 0], velocity_history[i, 1],

head_width=0.3, head_length=0.3, fc='k', ec='k')

plt.title("Momentum Optimization Trajectory")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.grid(True)

plt.show()

# パラメータの設定

learning_rate = 0.1

momentum = 0.9

steps = 50

x_init, y_init = -8.0, 4.0

# 最適化の実行

trajectory, velocity_history = momentum_optimization(x_init, y_init, learning_rate, momentum, steps)

# プロットの作成

plot_contour_with_trajectory(func, trajectory, velocity_history)

モメンタムのコーディング例(PyTorch)

モメンタムはPyTorchのtorch.optim.SGD(確率的勾配降下法)オプティマイザに対する設定として使用できます。モメンタムを利用することで、勾配の過去の情報を考慮に入れたパラメータの更新が可能となり、最適化の収束速度を向上させたり、局所的な振動を抑えたりする効果があります。

import torch.optim as optim

# モメンタム付きSGDオプティマイザの設定

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)AdaGrad

AdaGrad は、学習率を各パラメータに適応させる最適化アルゴリズムで、過去の勾配の履歴を利用してパラメータごとの学習率を動的に調整します。この手法は、スパースなデータや特徴量に基づくタスク(例: 自然言語処理)で特に効果的です。

更新式:

- 勾配の累積平方和の計算:

$$r_t = r_{t-1} + g_t^2$$

- $r_t$:時刻 $t$ における累積勾配の平方和。

- $g_t$:現在の勾配。

パラメータの更新:

$$w_{t+1} = w_t – \frac{\alpha}{\sqrt{{r_t} + \epsilon}} g_t$$

- $\epsilon$: ゼロ割りを防ぐための小さな値(通常 $10^{-8}$)。

特徴:

| 項目 | 内容 |

|---|---|

| パラメータごとの適応学習率 | 過去の勾配の累積に基づき、各パラメータに個別の学習率を割り当て。頻繁に更新されるパラメータは学習率が減少し、スパースなパラメータは学習率が維持される。 |

| スパースなデータへの適応性 | 自然言語処理やスパースなデータが多い状況で優れた性能を発揮。 |

利点:

| 項目 | 内容 |

|---|---|

| スパースデータでの有効性 | 更新頻度の少ないパラメータに大きな学習率を適用するため、スパースなデータセットに適している。 |

| 簡単な計算 | 累積平方和と勾配の更新だけで動作するため、計算コストが低い。 |

欠点:

| 項目 | 内容 |

|---|---|

| 学習率の極端な減少 | 勾配の累積平方和が増加し、学習率が極端に小さくなることでモデルの収束が遅くなる可能性がある。 |

| 適応力の制限 | 長期間の学習で更新が進まなくなる「停滞問題」が発生することがある。 |

適用例

- 自然言語処理

- 単語埋め込み(word embedding)やテキスト分類など、スパースな特徴量を持つタスク。

- スパースデータのトレーニング

- 行列分解、協調フィルタリング、レコメンデーションシステムなど。

動作イメージ

AdaGradは、学習の初期段階で大きな学習率を適用してパラメータを大まかに調整し、学習が進むにつれて頻繁に更新されるパラメータには小さな学習率を適用して微調整を行います。この仕組みにより、スパースな特徴を持つタスクでも、あまり更新されないパラメータが学習から取り残されるのを防ぎます。

import numpy as np

import matplotlib.pyplot as plt

def func(x, y):

"""二次関数(楕円形状)の定義"""

return 0.1 * x**2 + y**2

def grad_func(x, y):

"""関数の勾配を計算"""

grad_x = 0.2 * x

grad_y = 2 * y

return np.array([grad_x, grad_y])

def adagrad_optimization(x_init, y_init, learning_rate=0.1, epsilon=1e-8, steps=50):

"""AdaGrad最適化の実行"""

x, y = x_init, y_init

G = np.array([0.0, 0.0]) # 勾配の累積二乗和

trajectory = [(x, y)]

update_history = []

for t in range(1, steps + 1):

grad = grad_func(x, y)

# 勾配の累積二乗和の更新

G += grad ** 2

# パラメータの更新

adjusted_lr = learning_rate / (np.sqrt(G) + epsilon)

update = adjusted_lr * grad

x = x - update[0]

y = y - update[1]

# 経路と更新量の記録

trajectory.append((x, y))

update_history.append(update.copy())

return np.array(trajectory), np.array(update_history)

def plot_contour_with_trajectory(func, trajectory, update_history, levels=20):

"""等高線と最適化の軌跡をプロット"""

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = func(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=levels, cmap="cool")

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

plt.plot(trajectory[:, 0], trajectory[:, 1], 'mo-', markersize=5, label="AdaGrad Path")

# 初期点と最終点のマーカー

plt.scatter(trajectory[0, 0], trajectory[0, 1], color='green', s=100, label='Start')

plt.scatter(trajectory[-1, 0], trajectory[-1, 1], color='blue', s=100, label='End')

# 矢印を追加して更新ベクトルを示す(間引いて表示)

for i in range(0, len(trajectory) - 1, 5):

plt.arrow(trajectory[i, 0], trajectory[i, 1],

update_history[i, 0], update_history[i, 1],

head_width=0.3, head_length=0.3, fc='k', ec='k')

plt.title("AdaGrad Optimization Trajectory")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.grid(True)

plt.show()

# パラメータの設定

learning_rate = 1.0 # AdaGradでは比較的大きな学習率が使用されることが多い

epsilon = 1e-8

steps = 50

x_init, y_init = -8.0, 4.0

# 最適化の実行

trajectory, update_history = adagrad_optimization(

x_init, y_init,

learning_rate=learning_rate,

epsilon=epsilon,

steps=steps

)

# プロットの作成

plot_contour_with_trajectory(func, trajectory, update_history)

AdaGradのコーディング例(PyTorch)

import torch.optim as optim

# AdaGradオプティマイザの設定

optimizer = optim.Adagrad(model.parameters(), lr=0.01, lr_decay=0, weight_decay=0, eps=1e-10)RMSprop

RMSprop は、AdaGradの改良版として提案された最適化アルゴリズムで、勾配の累積平方和が時間とともに増大し、学習率が極端に減少する問題を解決します。この手法は、オンライン学習やリカレントニューラルネットワーク(RNN)のトレーニングで特に効果的です。

更新式:

- 指数移動平均による勾配の二乗の累積:

$$r_t = \beta r_{t-1} + (1 – \beta) g_t^2$$

- $r_t$:時刻 $t$ における勾配の二乗の移動平均。

- $β$: 減衰率(通常 0.9)。

- パラメータの更新

$$w_{t+1} = w_t – \frac{\alpha}{\sqrt{r_t} + \epsilon} g_t$$

特徴:

| 項目 | 内容 |

|---|---|

| 移動平均の利用 | 勾配の二乗の累積に指数移動平均を採用し、学習率の極端な減少を防止。古い勾配の影響を徐々に減少させる。 |

| 適応学習率 | 勾配の大きさに基づいて各パラメータの学習率を調整。勾配が大きい場合は学習率を減少させ、小さい場合は学習率を増加。 |

利点:

| 項目 | 内容 |

|---|---|

| 安定した学習 | 勾配の変動が激しい場合でも安定した更新を提供。 |

| 長期学習への対応 | AdaGradで発生する学習率の極端な減少を解決し、長期間の学習でも効果を維持。 |

| スパースデータへの有効性 | スパースな特徴量を持つタスクでも効果的に対応可能。 |

欠点:

| 項目 | 内容 |

|---|---|

| ハイパーパラメータ調整の必要性 | 減衰率 $β$ や学習率 $α$ の適切な設定が重要で、パフォーマンスに大きく影響する。 |

| 局所最適解の探索が難しい | 学習率が小さくなりすぎる場合、収束が遅くなり、局所最適解の探索が困難になることがある。 |

適用例:

- リカレントニューラルネットワーク (RNN)

- 時系列データや自然言語処理での学習。

- オンライン学習

- ストリーミングデータや継続的なデータ処理。

動作イメージ

RMSpropは、勾配の変動が大きい場合でも安定した学習を可能にします。勾配の移動平均を利用して各パラメータの学習率を調整するため、スパースデータや連続データを扱うタスクで特に効果を発揮します。

import numpy as np

import matplotlib.pyplot as plt

def func(x, y):

"""二次関数(楕円形状)の定義"""

return 0.1 * x**2 + y**2

def grad_func(x, y):

"""関数の勾配を計算"""

grad_x = 0.2 * x

grad_y = 2 * y

return np.array([grad_x, grad_y])

def rmsprop_optimization(x_init, y_init, learning_rate=0.1, beta=0.9, epsilon=1e-8, steps=100):

"""RMSprop最適化の実行"""

x, y = x_init, y_init

Eg = np.array([0.0, 0.0]) # 勾配の二乗の移動平均

trajectory = [(x, y)]

update_history = []

for t in range(1, steps + 1):

grad = grad_func(x, y)

# 勾配の二乗の移動平均を更新

Eg = beta * Eg + (1 - beta) * grad ** 2

# パラメータの更新

update = (learning_rate / (np.sqrt(Eg) + epsilon)) * grad

x = x - update[0]

y = y - update[1]

# 経路と更新量の記録

trajectory.append((x, y))

update_history.append(update.copy())

return np.array(trajectory), np.array(update_history)

def plot_contour_with_trajectory(func, trajectory, update_history, levels=20):

"""等高線と最適化の軌跡をプロット"""

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = func(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=levels, cmap="cool")

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

plt.plot(trajectory[:, 0], trajectory[:, 1], 'co-', markersize=3, label="RMSprop Path")

# 初期点と最終点のマーカー

plt.scatter(trajectory[0, 0], trajectory[0, 1], color='green', s=100, label='Start')

plt.scatter(trajectory[-1, 0], trajectory[-1, 1], color='blue', s=100, label='End')

# 矢印を追加して更新ベクトルを示す(間引いて表示)

for i in range(0, len(trajectory) - 1, 10):

plt.arrow(trajectory[i, 0], trajectory[i, 1],

update_history[i, 0], update_history[i, 1],

head_width=0.3, head_length=0.3, fc='k', ec='k')

plt.title("RMSprop Optimization Trajectory")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.grid(True)

plt.show()

# パラメータの設定

learning_rate = 0.1 # 学習率を0.1に増加

beta = 0.9

epsilon = 1e-8

steps = 100 # ステップ数を100に増加

x_init, y_init = -8.0, 4.0

# 最適化の実行

trajectory, update_history = rmsprop_optimization(

x_init, y_init,

learning_rate=learning_rate,

beta=beta,

epsilon=epsilon,

steps=steps

)

# プロットの作成

plot_contour_with_trajectory(func, trajectory, update_history)

RMSpropのコーディング例(PyTorch)

import torch.optim as optim

# RMSpropオプティマイザの設定

optimizer = optim.RMSprop(model.parameters(), lr=0.001, alpha=0.9, eps=1e-8, weight_decay=0, momentum=0)Adam

Adamは、勾配降下法を拡張したアルゴリズムで、学習率を各パラメータごとに調整します。過去の勾配を考慮し、勾配の一次モーメント(平均)と二次モーメント(分散)を利用します。

一次モーメントの更新式:

$$m_t = \beta_1 m_{t-1} + (1 – \beta_1) g_t$$

バイアス補正された一次モーメント:

$$\hat{m}_t = \frac{m_t}{1 – \beta_1^t}$$

二次モーメントの推定値:

$$v_t = \beta_2 v_{t-1} + (1 – \beta_2) g_t^2$$

バイアス補正を考慮した推定値:

$$\hat{v}_t = \frac{v_t}{1 – \beta_2^t}$$

重みの更新式

$$w_{t+1} = w_t – \alpha \frac{\hat{m}}{\sqrt{\hat{v} + \epsilon}}$$

| 特徴 | 表記 | 説明 |

|---|---|---|

| 勾配の一次モーメント | $m_t$ | 勾配の一次モーメント |

| 勾配の二次モーメント | $v_t$ | 勾配の二次モーメント |

| 現在の勾配 | $g_t$ | 現在の勾配 |

| モーメントの減衰率 | $\beta_1, \beta_2$ | モーメントの減衰率(通常 ($\beta_1 = 0.9,$ $\beta_2 = 0.999$)) |

| ゼロ割りを防ぐための小さな値 | $\epsilon$ | ゼロ割りを防ぐための小さな値(通常 ($1 \times 10^{-8})$) |

このようにして、Adam最適化アルゴリズムでは、勾配の一次および二次モーメントを更新し、バイアス補正を行うことで、各パラメータに対する適応的な学習率を計算します。これにより、学習の安定性と効率が向上します。

利点:

| 特徴 | 内容 |

|---|---|

| 自動的な学習率調整 | 各パラメータに対する学習率を適応的に調整するため、収束が速く、安定性が向上します。 |

| 効果的な収束 | Adamは多くのデータセットで良い結果を得やすく、特に非定常な目的関数に対して効果的です。 |

適用例:

- 幅広いディープラーニングタスク(例: CNN、RNN、NLP)での標準的な選択肢。

- 画像認識、時系列データ処理、自然言語処理タスク(NLP)など汎用的。

動作イメージ

- Adamでは、等高線プロット上で滑らかに最小値へ収束する経路が観察されます。各ステップの更新量は矢印で示され、パラメータの移動方向と大きさが視覚的に理解できます。一次および二次モーメントを利用し、各パラメータごとに適応的な学習率を調整することで、安定した収束が期待できます。

- 平均的な道を進む車の運転。道路の凹凸や急カーブがあっても、ある程度一定の速度で進む。

import numpy as np

import matplotlib.pyplot as plt

def func(x, y):

"""二次関数(楕円形状)の定義"""

return 0.1 * x**2 + y**2

def grad_func(x, y):

"""関数の勾配を計算"""

grad_x = 0.2 * x

grad_y = 2 * y

return np.array([grad_x, grad_y])

def adam_optimization(x_init, y_init, learning_rate=0.1, beta1=0.9, beta2=0.999, epsilon=1e-8, steps=50):

"""Adam最適化の実行"""

x, y = x_init, y_init

m = np.array([0.0, 0.0]) # 一階モーメント (First Moment)

v = np.array([0.0, 0.0]) # 二階モーメント (Second Moment)

trajectory = [(x, y)]

update_history = []

for t in range(1, steps + 1):

grad = grad_func(x, y)

# モーメントの更新

m = beta1 * m + (1 - beta1) * grad

v = beta2 * v + (1 - beta2) * (grad ** 2)

# バイアス補正

m_hat = m / (1 - beta1 ** t)

v_hat = v / (1 - beta2 ** t)

# パラメータの更新

update = learning_rate * m_hat / (np.sqrt(v_hat) + epsilon)

x = x - update[0]

y = y - update[1]

# 軌跡と更新量の記録

trajectory.append((x, y))

update_history.append(update.copy())

return np.array(trajectory), np.array(update_history)

def plot_contour_with_trajectory(func, trajectory, update_history, levels=20):

"""等高線と最適化の軌跡をプロット"""

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = func(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=levels, cmap="cool")

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

plt.plot(trajectory[:, 0], trajectory[:, 1], 'mo-', markersize=5, label="Adam Path")

# 初期点と最終点のマーカー

plt.scatter(trajectory[0, 0], trajectory[0, 1], color='green', s=100, label='Start')

plt.scatter(trajectory[-1, 0], trajectory[-1, 1], color='blue', s=100, label='End')

# 矢印を追加して更新ベクトルを示す(間引いて表示)

for i in range(0, len(trajectory) - 1, 5):

plt.arrow(trajectory[i, 0], trajectory[i, 1],

update_history[i, 0], update_history[i, 1],

head_width=0.3, head_length=0.3, fc='k', ec='k')

plt.title("Adam Optimization Trajectory")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.grid(True)

plt.show()

# パラメータの設定

learning_rate = 0.1

beta1 = 0.9

beta2 = 0.999

epsilon = 1e-8

steps = 50

x_init, y_init = -8.0, 4.0

# 最適化の実行

trajectory, update_history = adam_optimization(

x_init, y_init,

learning_rate=learning_rate,

beta1=beta1,

beta2=beta2,

epsilon=epsilon,

steps=steps

)

# プロットの作成

plot_contour_with_trajectory(func, trajectory, update_history)

Adamのコーディング例(PyTorch):

import torch.optim as optim

# Adamオプティマイザの設定

optimizer = optim.Adam(model.parameters(), lr=0.01)AdamW

AdamW は、Adam最適化アルゴリズムの改良版であり、重み減衰 (Weight Decay) を正則化の手法として適切に導入したものです。重み減衰を「勾配更新」と独立して扱うことで、過学習を防ぎつつ、Adamの性能を保持しています。

Adamの元々の重み減衰問題:

- 標準的なAdamでは、重み減衰を「L2正則化」として導入しますが、モーメントのスケーリングに影響されるため、理想的な正則化効果が得られない場合がありました。

解決策:

- AdamWでは、重み減衰を勾配のモーメント計算に組み込まず、「パラメータ更新のステップ」において別途適用することで、この問題を解消しました。

アルゴリズムの詳細

- 勾配のモーメント計算

- Adamと同様に、一次モーメントと二次モーメントを計算します。

$$m_t = \beta_1 m_{t-1} + (1 – \beta_1) g_t$$

$$v_t = \beta_2 v_{t-1} + (1 – \beta_2) g_t^2$$

- バイアス補正

- モーメントのバイアス補正を行います。

$$\hat{m}_t = \frac{m_t}{1 – \beta_1^t}$$

$$\hat{v}_t = \frac{v_t}{1 – \beta_2^t}$$

- 重み減衰 (Weight Decay)

- AdamWでは、重み減衰をモーメント計算に含めず、更新式に直接加えます。

$$w_{t+1} = w_t – \alpha \frac{\hat{m}_t}{\sqrt{\hat{v}_t} + \epsilon} – \eta \cdot \lambda \cdot w_t$$

特徴:

| 項目 | 内容 |

|---|---|

| 重み減衰の分離 | 正則化項を勾配計算と分離することで、理想的な正則化効果を実現。 |

| 汎化性能の向上 | 過学習を抑制し、モデルの汎化性能を向上させます。 |

| 計算コストはAdamとほぼ同じ | 重み減衰の計算は単純なスケーリングであり、追加の計算コストがほとんど発生しません。 |

欠点:

- 学習率と重み減衰係数の調整が必要

- タスクに応じて適切な値を設定しないと、性能が十分に発揮されない可能性がある。

適用例:

- Transformerベースのモデル

- BERTやGPTなどの自然言語処理(NLP)の大規模モデル。

- 画像認識タスク

- CNNを用いた分類やセグメンテーションタスク。

- 一般的なディープラーニングタスク

- 汎化性能が重要な場合に有効。

論文:

- 従来のL2正則化では難しかった「学習率」と「重み減衰係数」を独立して調整できる手法として、分離型重み減衰を提案しました。この手法により、特にAdamのような適応型最適化手法でパフォーマンスが大幅に向上します。

- 画像分類タスク(CIFAR-10やImageNet32x32)で、AdamWは従来のAdamより高いテスト精度を達成し、SGDとも互角に競える結果を示しました。特に、コサインアニーリングを併用することで汎化性能がさらに強化されました。

- 提案された分離型重み減衰手法は、AdaGradやAMSGradなどの他の適応型最適化手法にも適用可能です。

動作イメージ

- AdamWの動作イメージは、勾配更新(学習)と重み減衰(正則化)を分離して適用する点にあります。この設計により、パラメータが過剰に増大することを防ぎつつ、正確な学習を可能にします。

- AdamWの役割

- 勾配更新は「目的地に向かう最短ルートを計算する」作業。

- 重み減衰は「荷物の重さを減らして動きやすくする」役割。

- 両者を独立して処理することで、効率的かつ安定した移動が可能になります。

import numpy as np

import matplotlib.pyplot as plt

import torch

# 損失関数(例:楕円形)

def loss_function(x, y):

return 0.1 * x**2 + y**2

# 損失関数の勾配

def gradient(x, y):

return np.array([0.2 * x, 2 * y])

# AdamWのパラメータ更新関数

def adamw_update(x, y, m, v, m_hat, v_hat, grad, t, learning_rate, beta1, beta2, epsilon, weight_decay):

m = beta1 * m + (1 - beta1) * grad

v = beta2 * v + (1 - beta2) * (grad ** 2)

m_hat = m / (1 - beta1 ** t)

v_hat = v / (1 - beta2 ** t)

x -= learning_rate * (m_hat[0] / (np.sqrt(v_hat[0]) + epsilon) + weight_decay * x)

y -= learning_rate * (m_hat[1] / (np.sqrt(v_hat[1]) + epsilon) + weight_decay * y)

return x, y, m, v, m_hat, v_hat

# パラメータ

x_start = -8

y_start = 9

learning_rate = 0.5 # 学習率

beta1 = 0.9 # 一次モーメントの減衰率

beta2 = 0.999 # 二次モーメントの減衰率

epsilon = 1e-8 # ゼロ除算を防ぐための小さな値

weight_decay = 0.1 # 重み減衰

# 初期位置

x = x_start

y = y_start

# モーメントの初期化

m = np.array([0.0, 0.0])

v = np.array([0.0, 0.0])

m_hat = np.array([0.0, 0.0])

v_hat = np.array([0.0, 0.0])

# 軌跡を保存するリスト

trajectory = [(x, y)]

# AdamWによる最適化

for t in range(1, 51):

grad = gradient(x, y)

x, y, m, v, m_hat, v_hat = adamw_update(x, y, m, v, m_hat, v_hat, grad, t, learning_rate, beta1, beta2, epsilon, weight_decay)

trajectory.append((x, y))

# 等高線図の作成

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = loss_function(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=20, cmap='viridis')

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

trajectory = np.array(trajectory)

plt.plot(trajectory[:, 0], trajectory[:, 1], 'ro-', label='AdamW Path')

# 始点と終点をマーク

plt.plot(x_start, y_start, 'go', markersize=10, label='Start')

plt.plot(trajectory[-1, 0], trajectory[-1, 1], 'mo', markersize=10, label='End')

plt.title('AdamW Optimizer Behavior')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.grid(True)

plt.show()

AdamWのコーディング例(PyTorch):

import torch.optim as optim

# AdamWオプティマイザ

optimizer = optim.AdamW(

net.parameters(),

lr=1e-3,

weight_decay=0.01, # 重み減衰

betas=(0.9, 0.999),

eps=1e-8

)AdaBelief (2020)

AdaBelief は、Adamのモーメント推定を改良し、勾配の分布をより厳密に反映することで性能を向上させたアルゴリズムです。

一次モーメントの更新式:

$$m_t = \beta_1 m_{t-1} + (1 – \beta_1) g_t$$

二次モーメントの更新式(勾配の差分ベース):

$$s_t = \beta_2 s_{t-1} + (1 – \beta_2)(g_t – m_t)^2$$

正規化された更新:

$$w_{t+1} = w_t – \alpha \frac{m_t}{\sqrt{s_t} + \epsilon}$$

特徴:

| 項目 | 内容 |

|---|---|

| 精密なモーメント計算 | 勾配とその期待値との差分を活用し、標準的な勾配分散よりも勾配の変動を正確に捉える。 |

| 汎化性能の向上 | 勾配の過剰適応(過学習)を抑制し、モデルの汎化性能を高める。 |

| 安定性 | Adamと同様の形式で簡単に利用可能であり、トレーニングの安定性を提供。 |

利点:

| 項目 | 内容 |

|---|---|

| 過学習の抑制 | 過剰適応を防ぎ、トレーニングデータに依存しすぎないモデルを構築。 |

| 適用範囲の広さ | CNNやRNNなど、多様なタスクに適用可能であり、幅広い応用分野で利用できる。 |

欠点:

- AdaBeliefの欠点として、他の手法に比べて計算負荷が若干高く、タスクによってはAdamと同等または劣る場合がある点が挙げられます。また、ハイパーパラメータ調整が必要です。

適用例:

- ディープラーニングでの使用

- CNN、RNNに使用可能。

- その他の特徴

- 汎化性能を重視したタスク(例: 画像分類、テキスト分類)やスパースデータの学習に最適。

- 過学習のリスクが高いタスクで効果的。

- 勾配の変動を精密に捉えるため、安定性が求められるモデルで有用。

論文

- AdaBeliefは、勾配の予測値(EMA)と実際の値のズレを「信頼度」として評価し、その信頼度に応じてステップサイズを調整する新しい仕組みを提案しています。この方法により、Adamの速い収束性、SGDの優れた汎化性能、安定した学習の3つを同時に実現する画期的な手法です。

- AdaBeliefは、Adamと比較して追加のハイパーパラメータを導入せず、計算コストもほぼ同等です。

- AdaBeliefは、画像分類、言語モデリング、GANトレーニングなど幅広いタスクで優れた性能を発揮しました。特にGANの学習では、従来の手法に比べて高い安定性と生成品質を実現し、既存の課題を効果的に克服しています。

動作イメージ

- AdaBeliefの動作イメージは、「勾配の変化を信頼度(Belief)として捉え、それに基づいて更新量を調整する」というものです。これにより、過学習を抑制しつつ、適応的で効率的な学習が可能になります。特に勾配の変化が多い不安定なタスクで効果を発揮します。

- 凹凸や急カーブが多い道では慎重に、直線の滑らかな道ではスピードを上げる車の運転。環境の状況に応じて速度を調整をするようなイメージ

import numpy as np

import matplotlib.pyplot as plt

def func(x, y):

"""二次関数(楕円形状)の定義"""

return 0.1 * x**2 + y**2

def grad_func(x, y):

"""関数の勾配を計算"""

grad_x = 0.2 * x

grad_y = 2 * y

return np.array([grad_x, grad_y])

def adabelief_optimization(x_init, y_init, learning_rate=0.1, beta1=0.9, beta2=0.999, epsilon=1e-8, steps=50):

"""AdaBelief最適化の実行"""

x, y = x_init, y_init

m = np.array([0.0, 0.0]) # 一階モーメント

s = np.array([0.0, 0.0]) # 二階モーメント

trajectory = [(x, y)]

update_history = []

for t in range(1, steps + 1):

grad = grad_func(x, y)

# モーメントの更新

m = beta1 * m + (1 - beta1) * grad

s = beta2 * s + (1 - beta2) * (grad - m) ** 2

# バイアス補正

m_hat = m / (1 - beta1 ** t)

s_hat = s / (1 - beta2 ** t)

# パラメータの更新

update = learning_rate * m_hat / (np.sqrt(s_hat) + epsilon)

x = x - update[0]

y = y - update[1]

# 軌跡の記録

trajectory.append((x, y))

update_history.append(update.copy())

return np.array(trajectory), np.array(update_history)

def plot_contour_with_trajectory(func, trajectory, update_history, levels=20):

"""等高線と最適化の軌跡をプロット"""

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = func(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=levels, cmap="cool")

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

plt.plot(trajectory[:, 0], trajectory[:, 1], 'mo-', markersize=5, label="AdaBelief Path")

# 初期点と最終点のマーカー

plt.scatter(trajectory[0, 0], trajectory[0, 1], color='green', s=100, label='Start')

plt.scatter(trajectory[-1, 0], trajectory[-1, 1], color='blue', s=100, label='End')

# 矢印を追加して更新ベクトルを示す(間引いて表示)

for i in range(0, len(trajectory) - 1, 5):

plt.arrow(trajectory[i, 0], trajectory[i, 1],

update_history[i, 0], update_history[i, 1],

head_width=0.3, head_length=0.3, fc='k', ec='k')

plt.title("AdaBelief Optimization Trajectory")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.grid(True)

plt.show()

# パラメータの設定

learning_rate = 0.1

beta1 = 0.9

beta2 = 0.999

epsilon = 1e-8

steps = 50

x_init, y_init = -8.0, 4.0

# 最適化の実行

trajectory, update_history = adabelief_optimization(

x_init, y_init,

learning_rate=learning_rate,

beta1=beta1,

beta2=beta2,

epsilon=epsilon,

steps=steps

)

# プロットの作成

plot_contour_with_trajectory(func, trajectory, update_history)

AdaBeliefのコーディング例(PyTorch):

pip install adabelief-pytorch# AdaBeliefオプティマイザの設定

optimizer = AdaBelief(model.parameters(), lr=0.01)AdaBeliefのコーディング例_2)

rangerとadabeliefを使うことができます。

pip install ranger-adabelieffrom ranger_adabelief import Ranger, AdaBelief

# AdaBeliefの初期化

optimizer = AdaBelief(model.parameters(), lr=0.01, eps=1e-16, weight_decay=1e-4, rectify=False)RAdam (2019)

RAdam は、Adamの適応的学習率を改良し、初期段階での学習の安定性を向上させた手法です。

学習率補正:

$$\rho_t = \frac{2}{1 – \beta_2} – 2t + 2$$

$$\text{修正学習率} = \alpha \sqrt{\frac{\rho_t – 4}{\rho_t (\rho_t – 2)}}$$

更新式:

$$w_{t+1} = w_t – \text{修正学習率} \cdot \frac{m_t}{\sqrt{v_t} + \epsilon}$$

特徴と利点:

| 項目 | 内容 |

|---|---|

| 初期段階の安定性 | 小さなバッチや不安定な学習初期段階でも収束を安定化し、勾配の不安定さを低減。 |

| 汎用性 | Adamを使用するタスクに容易に適用でき、深いネットワークにも効果的に適用可能。 |

欠点:

- RAdamの欠点は、初期の学習安定化に特化しているため、収束速度が他の手法に劣る場合がある点です。また、大規模モデルでは性能改善が限定的な場合があります。

適用例:

- ディープラーニングでの使用

- CNN、RNNに使用可能。

- その他の特徴

- 深いネットワークや勾配の不安定性が課題となるモデル(例: GAN、BERTなどのNLPタスク)に適用。

- 特に学習初期段階の不安定性を解消し、収束速度を向上させる。

論文:

- 本論文は、Adamなどの適応的最適化アルゴリズムが学習の初期段階で分散の大きさにより収束が不安定になる問題を明らかにしました。そして、ウォームアップがこの分散を抑える効果を持つことを理論と実験を通じて示しています。

- 著者らは、適応学習率の分散を補正する新しい手法「RAdam」を提案しました。この手法はウォームアップを使わずに学習の安定性を確保し、言語モデリングや画像分類などの多様なタスクで従来のAdamを上回る成果を示しました。

- RAdamは、他の学習安定化技術(例: 勾配クリッピング、学習率平滑化)とも組み合わせて使用可能です。

動作イメージ

- RAdamの動作イメージは、「初期段階で慎重に進み、安定した段階でスムーズに加速する」最適化手法です。これにより、深いネットワークや不安定なタスクでも安定した収束を実現します。

import numpy as np

import matplotlib.pyplot as plt

# 損失関数(例:楕円形)

def loss_function(x, y):

return 0.1 * x**2 + y**2

# 損失関数の勾配

def gradient(x, y):

return np.array([0.2 * x, 2 * y])

# RAdamのパラメータ更新関数

def radam_update(x, y, m, v, m_hat, v_hat, grad, t, learning_rate, beta1, beta2, epsilon, weight_decay):

# 重み減衰を適用した勾配

grad_wd = grad + weight_decay * np.array([x, y])

# 一次モーメントの更新

m = beta1 * m + (1 - beta1) * grad_wd

# 二次モーメントの更新

v = beta2 * v + (1 - beta2) * (grad_wd ** 2)

# バイアス補正

m_hat = m / (1 - beta1 ** t)

v_hat = v / (1 - beta2 ** t)

# SMA計算

rho_inf = 2 / (1 - beta2) - 1

rho_t = rho_inf - 2 * t * beta2 ** t / (1 - beta2 ** t)

# 更新量の計算

if rho_t > 4:

r = np.sqrt(((rho_t - 4) * (rho_t - 2) * rho_inf) / ((rho_inf - 4) * (rho_inf - 2) * rho_t))

update = r * m_hat / (np.sqrt(v_hat) + epsilon)

else:

update = m_hat

# パラメータの更新

x -= learning_rate * update[0]

y -= learning_rate * update[1]

return x, y, m, v, m_hat, v_hat

# パラメータ

x_start = -8

y_start = 9

learning_rate = 0.5 # 学習率

beta1 = 0.9 # 一次モーメントの減衰率

beta2 = 0.999 # 二次モーメントの減衰率

epsilon = 1e-8 # ゼロ除算を防ぐための小さな値

weight_decay = 0.01 # 重み減衰

# 初期位置

x = x_start

y = y_start

# モーメントの初期化

m = np.array([0.0, 0.0])

v = np.array([0.0, 0.0])

m_hat = np.array([0.0, 0.0])

v_hat = np.array([0.0, 0.0])

# 軌跡を保存するリスト

trajectory = [(x, y)]

# RAdamによる最適化

for t in range(1, 51):

grad = gradient(x, y)

x, y, m, v, m_hat, v_hat = radam_update(x, y, m, v, m_hat, v_hat, grad, t, learning_rate, beta1, beta2, epsilon, weight_decay)

trajectory.append((x, y))

# 等高線図の作成

x_range = np.linspace(-10, 10, 400)

y_range = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x_range, y_range)

Z = loss_function(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=20, cmap='viridis')

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

trajectory = np.array(trajectory)

plt.plot(trajectory[:, 0], trajectory[:, 1], 'ro-', label='RAdam Path')

# 始点と終点をマーク

plt.plot(x_start, y_start, 'go', markersize=10, label='Start')

plt.plot(trajectory[-1, 0], trajectory[-1, 1], 'mo', markersize=10, label='End')

plt.title('RAdam Optimizer Behavior')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.grid(True)

plt.show()

RAdamのコーディング例(PyTorch):

radam はPyTorchの標準ライブラリには含まれていないため、サードパーティの実装を使用する必要があります。まず、RAdamオプティマイザを自分で実装します。

別ファイルにradam.pyを作成し、from radam import RAdamを使用してradam.pyからRAdamクラスをインポートします。

- radam.py

import torch

from torch.optim.optimizer import Optimizer

import math

class RAdam(Optimizer):

def __init__(self, params, lr=1e-3, betas=(0.9, 0.999), eps=1e-8, weight_decay=0, degenerated_to_sgd=True):

if not 0.0 <= lr:

raise ValueError("Invalid learning rate: {}".format(lr))

if not 0.0 <= eps:

raise ValueError("Invalid epsilon value: {}".format(eps))

if not 0.0 <= betas[0] < 1.0:

raise ValueError("Invalid beta parameter at index 0: {}".format(betas[0]))

if not 0.0 <= betas[1] < 1.0:

raise ValueError("Invalid beta parameter at index 1: {}".format(betas[1]))

self.degenerated_to_sgd = degenerated_to_sgd

if isinstance(params, (list, tuple)) and len(params) > 0 and isinstance(params[0], dict):

for param in params:

if 'betas' in param and (param['betas'][0] != betas[0] or param['betas'][1] != betas[1]):

param['buffer'] = [[None, None, None] for _ in range(10)]

defaults = dict(lr=lr, betas=betas, eps=eps, weight_decay=weight_decay, buffer=[[None, None, None] for _ in range(10)])

super(RAdam, self).__init__(params, defaults)

def __setstate__(self, state):

super(RAdam, self).__setstate__(state)

def step(self, closure=None):

loss = None

if closure is not None:

loss = closure()

for group in self.param_groups:

for p in group['params']:

if p.grad is None:

continue

grad = p.grad.data.float()

if grad.is_sparse:

raise RuntimeError('RAdam does not support sparse gradients')

p_data_fp32 = p.data.float()

state = self.state[p]

if len(state) == 0:

state['step'] = 0

state['exp_avg'] = torch.zeros_like(p_data_fp32)

state['exp_avg_sq'] = torch.zeros_like(p_data_fp32)

else:

state['exp_avg'] = state['exp_avg'].type_as(p_data_fp32)

state['exp_avg_sq'] = state['exp_avg_sq'].type_as(p_data_fp32)

exp_avg, exp_avg_sq = state['exp_avg'], state['exp_avg_sq']

beta1, beta2 = group['betas']

exp_avg_sq.mul_(beta2).addcmul_(grad, grad, value=1 - beta2)

exp_avg.mul_(beta1).add_(grad, alpha=1 - beta1)

state['step'] += 1

buffered = group['buffer'][int(state['step'] % 10)]

if state['step'] == buffered[0]:

N_sma, step_size = buffered[1], buffered[2]

else:

buffered[0] = state['step']

beta2_t = beta2 ** state['step']

N_sma_max = 2 / (1 - beta2) - 1

N_sma = N_sma_max - 2 * state['step'] * beta2_t / (1 - beta2_t)

buffered[1] = N_sma

# more conservative since it's an approximated value

if N_sma >= 5:

step_size = math.sqrt((1 - beta2_t) * (N_sma - 4) / (N_sma_max - 4) * (N_sma - 2) / N_sma * N_sma_max / (N_sma_max - 2)) / (1 - beta1 ** state['step'])

elif self.degenerated_to_sgd:

step_size = 1.0 / (1 - beta1 ** state['step'])

else:

step_size = -1

buffered[2] = step_size

# more conservative since it's an approximated value

if N_sma >= 5:

if group['weight_decay'] != 0:

p_data_fp32.add_(p_data_fp32, alpha=-group['weight_decay'] * group['lr'])

denom = exp_avg_sq.sqrt().add_(group['eps'])

p_data_fp32.addcdiv_(exp_avg, denom, value=-step_size * group['lr'])

p.data.copy_(p_data_fp32)

elif step_size > 0:

if group['weight_decay'] != 0:

p_data_fp32.add_(p_data_fp32, alpha=-group['weight_decay'] * group['lr'])

p_data_fp32.add_(exp_avg, alpha=-step_size * group['lr'])

p.data.copy_(p_data_fp32)

return lossfrom radam import RAdam # radam.pyからRAdamクラスをインポート

optimizer = RAdam(model.parameters(), lr=0.001)その他の方法としてサードパーティのライブラリを使用することでRAdamをインポートし、使用することが可能です。

torch-optimizer:

pip install torch_optimizerimport torch_optimizer as optim

# RAdamオプティマイザ

radam = RAdam(net.parameters(), lr=0.01)LookAhead Optimizer(2019)

LookAhead Optimizerは、パラメータの更新に「現在の進行方向」と「過去の位置」の関係を取り入れることで、安定性と収束速度を向上させた最適化手法です。他の最適化アルゴリズム(例: Adam、RAdam)と組み合わせて使用することで、長期的な方向性を取り入れた更新が可能になります。

内側の更新式 (Inner Update):

- 内側の最適化アルゴリズム(例: Adam)を用いて $k$ ステップ進行。

$$w_{\text{interim}} = w_t + \Delta w \quad (\text{通常の最適化アルゴリズムによる更新})$$

外側の更新式 (Outer Update):

- 過去の位置 $w_t$ と内側の更新結果 $w_{\text{interim}}$ を組み合わせて最終的な更新を行います。

$$w_{t+1} = w_t + \alpha (w_{\text{interim}} – w_t)$$

- $α$: LookAheadのステップサイズ(一般的には $\alpha = 0.5$ が使用される)。

- $w_{\text{interim}}$:内側の更新結果(複数ステップ分のパラメータ更新の累積)。

特徴:

| 項目 | 内容 |

|---|---|

| 長期的な方向性の活用 | 短期的な更新だけでなく、過去の位置との比較を通じて方向性を安定化し、より効率的な更新を実現。 |

| 組み合わせ可能 | AdamやRAdam、SGDなど、他の最適化アルゴリズムに追加して使用することが可能。 |

| 安定性の向上 | 局所的な振動を抑え、安定した収束を実現。 |

利点:

| 項目 | 内容 |

|---|---|

| 収束速度の向上 | 長期的な視点での更新により、より効率的に最適解へ到達。 |

| 安定性 | 局所的な最適解に陥りにくく、勾配のばらつきを抑える効果がある。 |

| 汎用性 | 他のアルゴリズムと簡単に統合可能で、幅広いタスクに適用できる。 |

欠点:

- LookAhead Optimizerの欠点は、計算コストの増加、ハイパーパラメータ調整の難しさ、内側の最適化アルゴリズムへの依存、効果が限定的な場合があることです。

適用例:

- ディープラーニングでの使用

- 他の最適化手法(例: Adam、RAdam)と組み合わせてCNN、RNNで使用可能。

- その他の特徴

- 局所的な勾配の振動を抑え、収束を安定化させる。

- 強化学習(RL)や不安定なタスク(例: GAN)で効果を発揮。

- 長期的な学習方向を修正する手法として、より安定した学習を提供。

論文:

- Lookaheadは、2種類の重み(高速重みと低速重み)を使い分けることで、既存の最適化アルゴリズムの分散を抑え、学習を安定させる新しい手法です。既存の手法と組み合わせることで、収束速度も向上します。

- Lookaheadは、SGDやAdamといった従来のアルゴリズムに適用できる汎用性の高い手法です。CIFARやImageNetなどのデータセットで、収束の速さと精度の向上が実証されており、ハイパーパラメータの調整が簡単で、実装コストも低いのが特徴です。

- SWA(Stochastic Weight Averaging)やPolyak平均化といった手法よりも高速な収束と優れた汎化性能を実現しました。

- ResNet-50やResNet-152などのさまざまなアーキテクチャおよびデータセットでテストされ、わずかな調整でパフォーマンス向上を達成しました。

動作イメージ

- LookAhead Optimizerの動作イメージは、「内側の更新で進み、外側の更新で方向性を見直す」というものです。この2段階の更新により、収束速度と安定性が向上し、多くのタスクで性能を改善できます。他の最適化手法との併用が可能である点も、大きな利点です。

- 登山者が時々振り返り、全体の進行方向を確認しながら進む。これにより、より効率的に目標に近づく。

- 短期的な進行(内側の更新): 局所的な勾配を利用してパラメータを更新。

- 長期的な方向性の見直し(外側の更新): 過去の位置を基に大局的な進行方向を調整。

import numpy as np

import matplotlib.pyplot as plt

def loss_function(x, y):

"""損失関数(例:楕円形)"""

return 0.1 * x**2 + y**2

def gradient(x, y):

"""損失関数の勾配"""

return np.array([0.2 * x, 2 * y])

def fast_optimizer_step(x, y, learning_rate):

"""高速オプティマイザのステップ(例:Adam)"""

grad = gradient(x, y)

# 簡略化のため、Adamの完全な実装ではなく、単純な勾配降下法を使用

return x - learning_rate * grad[0], y - learning_rate * grad[1]

def slow_optimizer_step(x_fast, x_slow, alpha):

"""低速オプティマイザのステップ"""

return x_slow + alpha * (x_fast - x_slow)

# パラメータ

x_start = -8

y_start = 9

learning_rate = 0.5 # 高速オプティマイザの学習率

alpha = 0.8 # 低速オプティマイザの更新率

k = 5 # 高速オプティマイザのステップ数

# 初期位置

x_slow = x_start

y_slow = y_start

x_fast = x_start

y_fast = y_start

# 軌跡を保存するリスト

slow_trajectory = [(x_slow, y_slow)]

fast_trajectory = [(x_fast, y_fast)]

# Lookaheadの動作

for i in range(20): # Lookaheadの反復回数

# 高速オプティマイザのステップをk回実行

for _ in range(k):

x_fast, y_fast = fast_optimizer_step(x_fast, y_fast, learning_rate)

fast_trajectory.append((x_fast, y_fast))

# 低速オプティマイザのステップを1回実行

x_slow = slow_optimizer_step(x_fast, x_slow, alpha)

y_slow = slow_optimizer_step(y_fast, y_slow, alpha)

slow_trajectory.append((x_slow, y_slow))

# 高速オプティマイザの位置を低速オプティマイザの位置にリセット

x_fast = x_slow

y_fast = y_slow

# 等高線図の作成

x = np.linspace(-10, 10, 400)

y = np.linspace(-10, 10, 400)

X, Y = np.meshgrid(x, y)

Z = loss_function(X, Y)

plt.figure(figsize=(10, 8))

contour = plt.contour(X, Y, Z, levels=20, cmap='viridis')

plt.clabel(contour, inline=True, fontsize=8)

# 軌跡のプロット

slow_trajectory = np.array(slow_trajectory)

fast_trajectory = np.array(fast_trajectory)

plt.plot(slow_trajectory[:, 0], slow_trajectory[:, 1], 'bo-', label='Slow Weights (Lookahead Path)')

plt.plot(fast_trajectory[:, 0], fast_trajectory[:, 1], 'ro-', label='Fast Weights (Inner Loop)', alpha=0.5)

# 矢印で方向を表示(低速オプティマイザのみ)

for i in range(len(slow_trajectory) - 1):

plt.arrow(slow_trajectory[i, 0], slow_trajectory[i, 1],

slow_trajectory[i+1, 0] - slow_trajectory[i, 0],

slow_trajectory[i+1, 1] - slow_trajectory[i, 1],

head_width=0.3, head_length=0.3, fc='b', ec='b')

# 始点と終点をマーク

plt.plot(x_start, y_start, 'go', markersize=10, label='Start')

plt.plot(slow_trajectory[-1, 0], slow_trajectory[-1, 1], 'mo', markersize=10, label='End')

plt.title('Lookahead Optimizer Behavior')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.grid(True)

plt.show()

LookAheadのコーディング例(PyTorch):

LookAheadの場合もRAdam同様、サードパーティライブラリを使うか自分で実装するかです。今回はサードパーティライブラリを使います。

torch-optimizer:

pip install torch_optimizerimport torch_optimizer as optim

# RAdamオプティマイザ

radam = RAdam(net.parameters(), lr=0.01)

# Lookaheadオプティマイザ (torch_optimizerを使用)

optimizer = optim.Lookahead(radam, k=5, alpha=0.5)Ranger (2019)