「gpt-ossモデル」をChatGPT形式で使用する手順

- GithubのopenwebuiのページのREADME.mdから「Open WebUIのインストールする手順」通りにOpen WebUIのインストールを行う

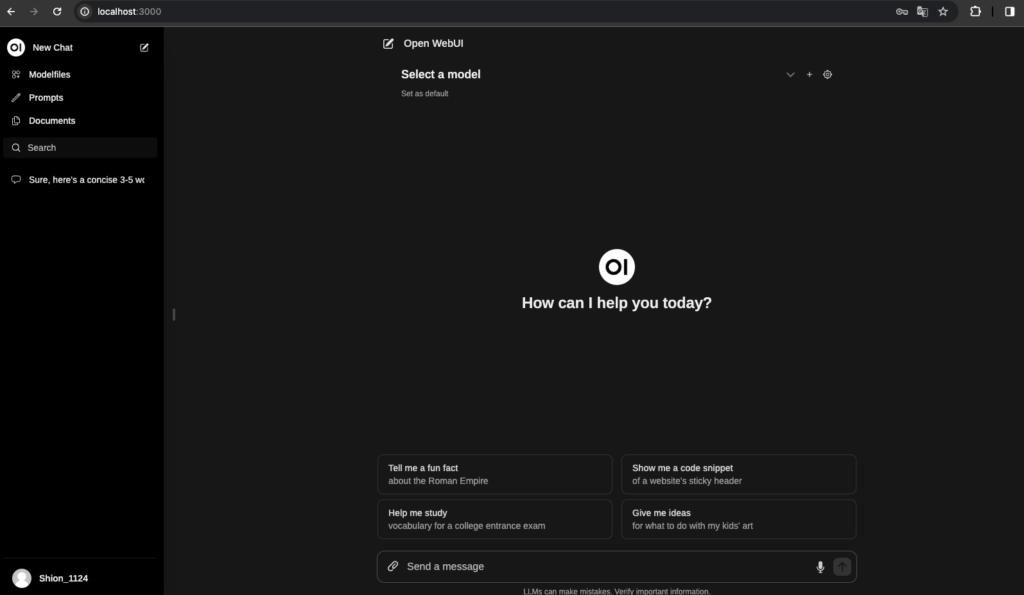

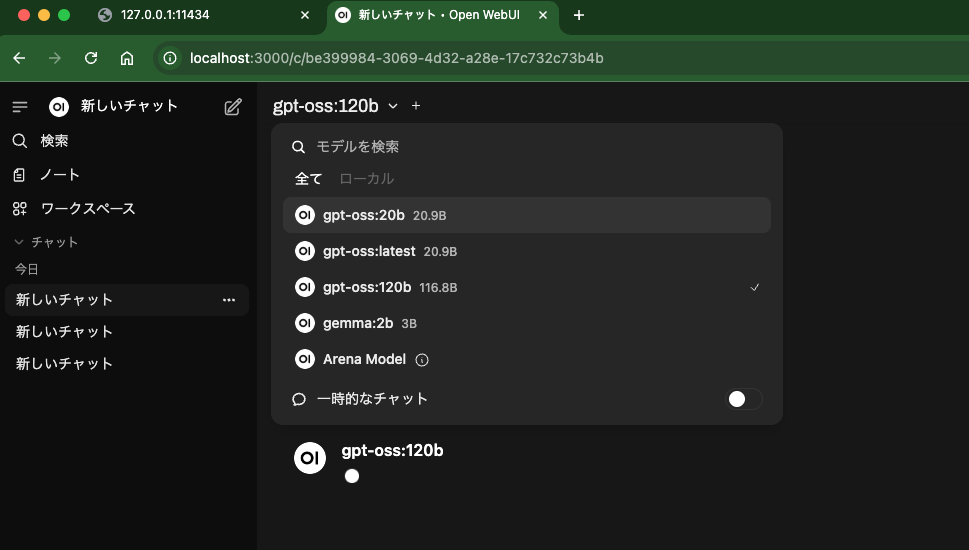

- Open WebUIとOllamaのインストールができたら、「http://localhost:3000/」へアクセスする

- Open WebUIにアクセスするための必要情報を入力してOpen WebUIにアクセスする

- Open WebUIのmodelに「gpt-ossモデル」をダウンロードする。

gpt-ossモデルとは?

OpenAIから、発表された新しいオープンウェイトモデルで「gpt-oss-120b」と「gpt-oss-20b」として発表されました。単に文章を生成するだけでなく、自律的に思考し、ツールを使いこなす「AIエージェント」の開発を強く意識した、画期的な特徴を持っています。

gpt-ossは従来の言語モデルと比べて何が、どのように違うのか?

gpt-ossの論文を読んでモデルの特徴を確認してみましょう。

https://cdn.openai.com/pdf/419b6906-9da6-406c-a19d-1bb078ac7637/oai_gpt-oss_model_card.pdf

思考と実行を分離する「Harmony Chat Format」

- 従来の多くのモデルでは、ユーザーからの指示とモデルの応答は、単純なテキストの往復で完結していました。モデルの内部的な思考(なぜその結論に至ったか)は、最終的な回答に混じって出力されるか、あるいは全く見えませんでした。

- 【ここが違う】

gpt-ossが採用する「Harmony Chat Format」は、モデルの内部プロセスを明確に分離して扱います。- 役割(Role)の階層化:

-

System(システム全体の設定) >Developer(開発者の指示) >User(エンドユーザーの入力)という明確な優先順位があります。これにより、開発者はユーザーの予期せぬ指示によってAIエージェントの基本ルールが破られるのを防ぐ、強固なガードレールを設計できます。

-

- チャネル(Channel)による出力の分離:

analysis:モデルの思考過程(CoT: Chain of Thought)が出力されるチャネル。commentary:Web検索やコード実行といった「ツール使用」のログが出力されるチャネル。final:ユーザーに最終的に見せる回答が出力されるチャネル。

- 役割(Role)の階層化:

- 【開発者にとってのメリット】

- これにより、「AIが今、何(What)を考えて、なぜ(Why)そのツールを使おうとしているのか」を、ユーザーに見せることなく裏側で正確に監視できます。エージェントが意図通りに動かない場合のデバッグが格段に容易になり、安全性の確保にも直結します。これは、複雑なエージェントを開発する上で非常に強力な武器となります。

性能とコストを両立する「混合エキスパート(MoE)アーキテクチャ」

- 高性能なモデルは通常、すべての計算ユニット(パラメータ)を常にフル稼働させる「密な(Dense)」アーキテクチャを採用しており、莫大な計算コストがかかります。

- 【ここが違う】

gpt-ossは、特定のタスクに応じて最適な専門家(エキスパート)のグループだけを呼び出して処理する「混合エキスパート(MoE)」アーキテクチャを採用しています。- これにより

gpt-oss-120bは全体で1168億という巨大なパラメータを持ちながら、実際に推論で稼働するのはその一部(51億)のみです。

- これにより

- 【開発者にとってのメリット】

- これにより、巨大モデルならではの高い性能を維持しつつ、推論(実行)にかかる計算コストとメモリ使用量を劇的に削減できます。オープンソースモデルでありながら、個人や小規模なチームでも比較的手の届きやすいハードウェアで動かせる、という現実的なメリットがあります。

タスクに応じて思考の深さを変える「可変労力推論」

- 従来のモデルは、簡単な質問にも複雑な質問にも、ほぼ同じ「思考量」で答えようとするのが一般的でした。

- 【ここが違う】

gpt-ossでは、開発者がシステムプロンプトを通じて、モデルの推論レベルを「low」「medium」「high」の3段階から意図的に選択できます。- high:より長く、深く思考します。複雑な数学の問題やコーディングなど、高い精度が求められるタスクで威力を発揮します。

- low:思考を簡略化し、速度とコストを優先します。単純な応答で十分なタスクに適しています。

- 【開発者にとってのメリット】

- アプリケーションの要件に応じて、「精度」と「コスト・速度」のバランスを柔軟にチューニングできます。「この機能は精度最優先」「こちらの機能は速度重視」といった使い分けが、一つのモデルで可能になります。

パフォーマンスと安全性

- 性能:

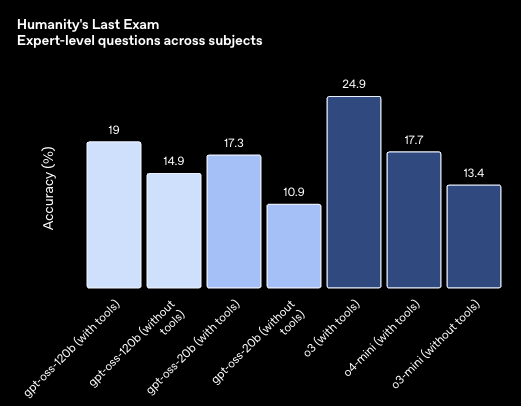

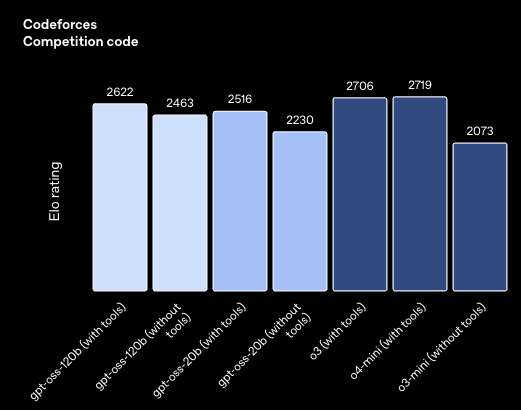

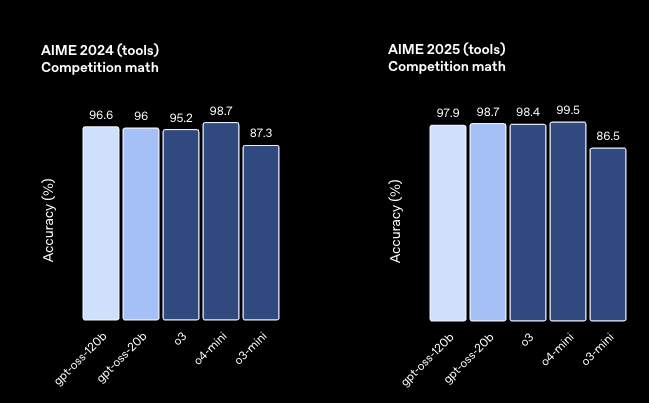

gpt-oss-120bは、OpenAIの高性能クローズドモデルo4-miniに匹敵する性能を持ち、特に数学、コーディング、ツール利用といった、論理的な思考過程が重要となるタスクでその強みを発揮します。

- 安全性:

- OpenAIは、このモデルを公開するにあたり、「悪意ある第三者がこのモデルを危険な目的にファインチューニングしたらどうなるか」という、一歩踏み込んだストレステストを自ら実施しています。その結果、生物・化学兵器やサイバー攻撃に関する能力を意図的に高めようとしても、OpenAIが定める危険なレベルには到達しなかったと報告しており、オープン化に伴うリスクを深く考慮している点が伺えます。

gpt-ossは誰のためのモデルか?

gpt-ossは、単に文章を作るAIが欲しいユーザーよりも、次世代のAIアプリケーション、特に自律的に動作するAIエージェントを本気で作りたい開発者にとって、最高のツールとなり得るモデルです。

| 特徴 | 一般的なLLM | gpt-oss |

|---|---|---|

| 思考プロセスの可視性 | 不可視、または回答と混合 | 明確に分離・監視可能 |

| 開発者の制御権 | 限定的(プロンプトのみ) | 指示階層により強力に制御 |

| 性能とコスト | 性能を求めるとコストが急増 | MoEにより両立 |

| 思考の深さ | ほぼ一定 | 3段階で調整可能 |

思考の過程を覗き込み、その振る舞いを精密にコントロールできるgpt-ossは、AIエージェント開発の可能性を大きく広げるモデルと言えるでしょう。

WebUI (旧 Ollama WebUI) を開く

Open WebUI をインストールする手順

Githubでopenwebuiのページを開いて、README.mdから「Open WebUIのインストールする手順」の通り、Dockerを使って環境構築を行います。

MacとWindowsでインストール手順が違いますので、OSに沿ったインストール手順で進めてみてください。

Dockerのインストール

まずはDockerを公式サイトからインストールします。インストールの手順に従ってDockerをインストールします。

Docker Desktopにサインインするための情報を入力してサインしてください。

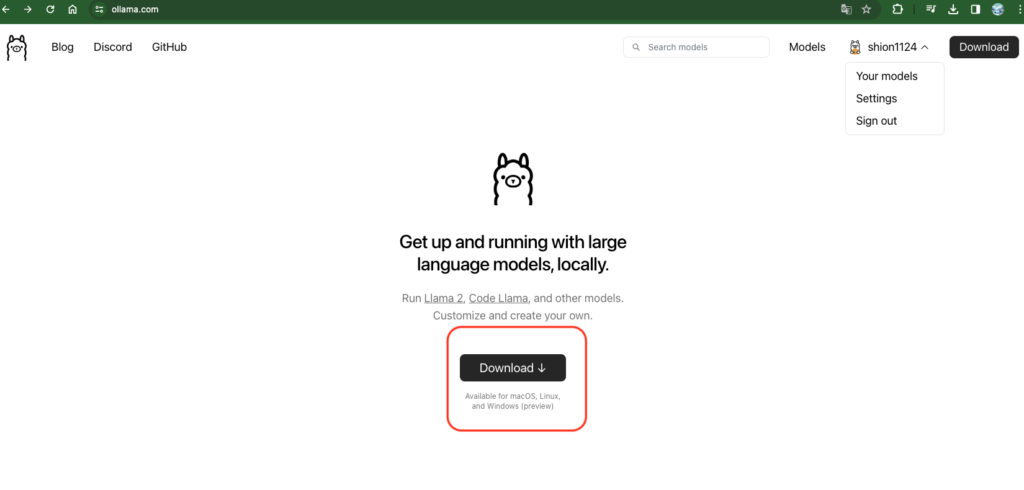

Ollamaのインストール

Ollamaとは?

Ollamaは、LLama3やLLava、vicunaやPhiなどのオープンに公開されているモデルを手元のPCやサーバーで動かすことの出来るツールです。 OllamaはCLI又はAPIで使うことができ、そのAPIを使ってオープンソースでOllama WebUIも開発されています。

Ollamaのダウンロード

まずはOllamaをダウンロードします。

ダウンロードしたファイルを解凍し、アプリケーション内で実行します。

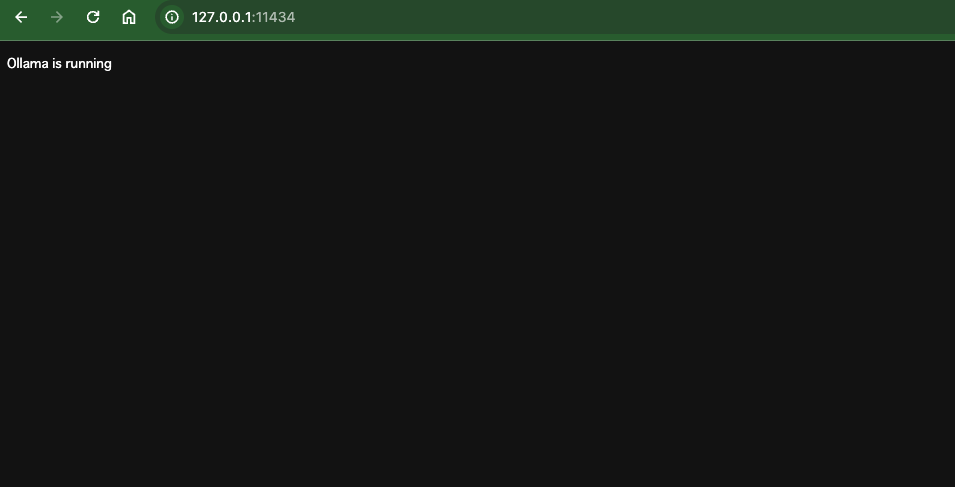

Ollamaのインストールの確認

アプリケーション実行後に下記へアクセスすると「Ollama is running」と表示されます。

http://127.0.0.1:11434/

Open WebUI のインストール

ターミナルでDockerDesktopにログインします。

$ docker logingithubのopenwebuiからファイルをダウンロードする。

$ git clone git@github.com:open-webui/open-webui.gitファイルへ移動します。

$ cd open-webuiOpen WebUI をインストールします。

$ docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainコンテナを自分で構築する場合(上を実行した場合は必要ありません)

$ docker build -t open-webui .

$ docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always open-webui

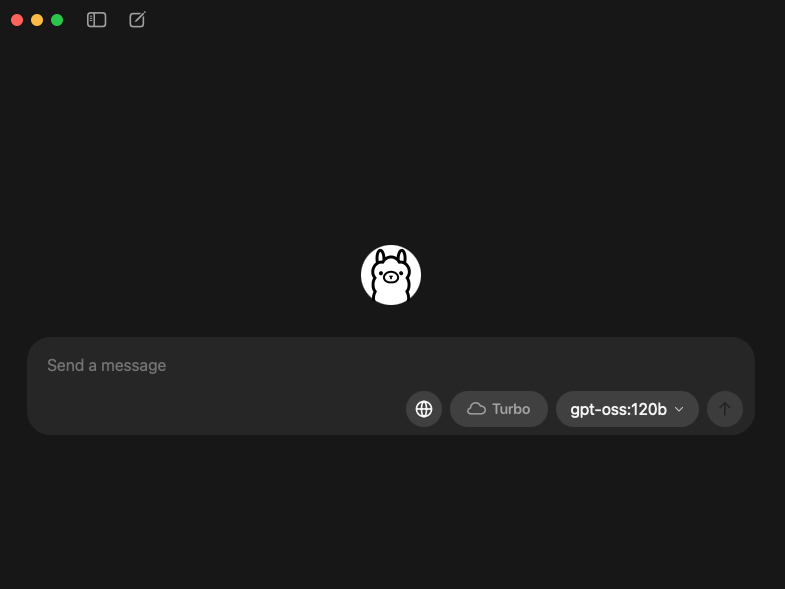

http://localhost:3000で Open WebUI にアクセスできます。

必要情報を入力してOpen WebUIのチャット画面を表示します。アカウントを持っていない方はアカウントを作ってからアクセスしてください。

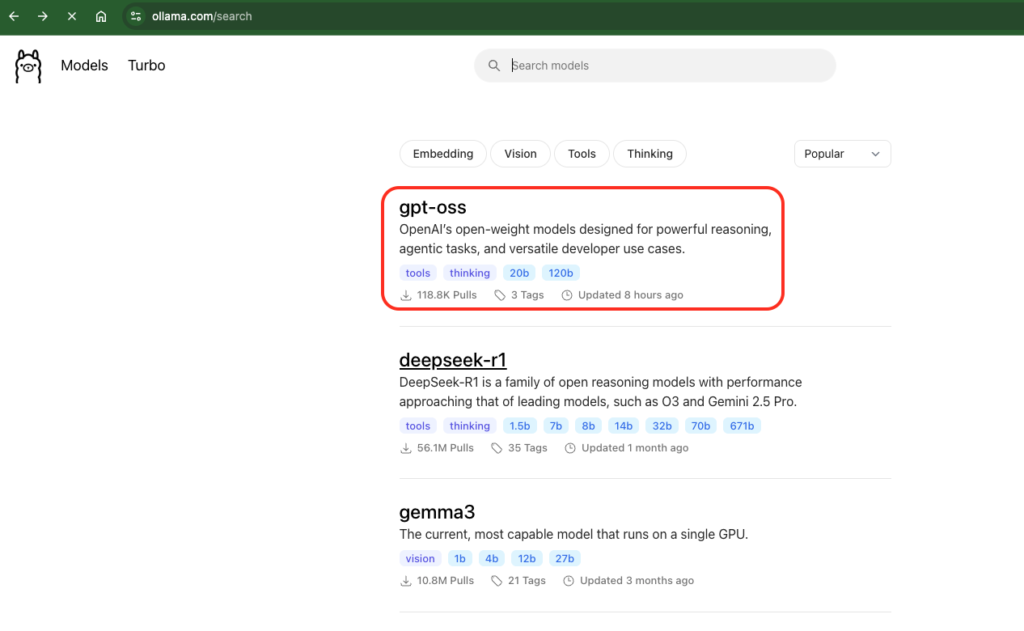

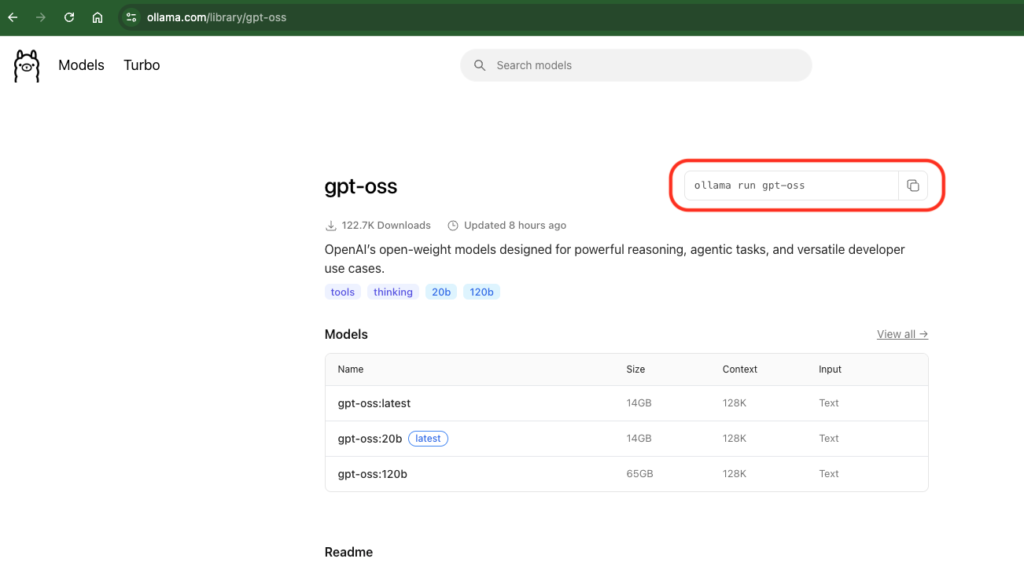

次にOpen WebUIのWebサイトから「model」をクリックし、「gpt-oss」を選択します。

次に「ollama run gpt-oss」をコピーペーストし、ターミナルでコマンドを実行し、「gpt-ossモデル」をダウンロードします。

gpt-ossがダウンロードできたらOpen WebUIのチャット画面に戻り、モデルを選択し、使用することができます。

またollamaのアプリを起動してモデルを選択し、アプリでモデルを使うことも可能です。

これで「gpt-ossモデル」をChatGPT形式で使うことができます。

最後に

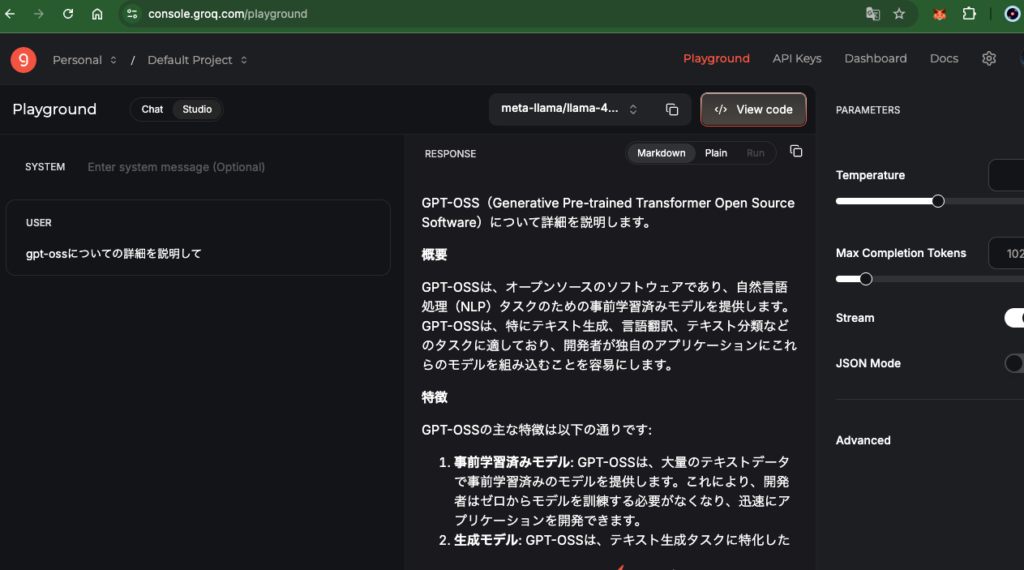

gpt-ossはgrokのplaygroundでもチャット形式で利用することができます。

論文であるmodelcardによると「GPT-OSS」は、サイバーセキュリティや説得・欺瞞といった分野で特に優れた性能を発揮し、指示の実行やコーディング、安全性の面でも高い評価を受けています。一方で、バイオセキュリティに関しては他のオープンソースモデル(「DeepSeek R1-0528」「Qwen 3 Thinking」「Kimi K2」)と大きな差はなく、リスクを特段高めるものではないとされています。全体として、特定分野に強みを持ちながらも、他の分野では他モデルと同程度のバランスの取れた性能を持つモデルと評価されています。

| 評価項目 | GPT-OSSの性能 | 他モデルとの比較 | 備考 |

|---|---|---|---|

| サイバーセキュリティ | 非常に高い | 他モデルを大幅に上回る | 最先端レベルの能力と評価 |

| 説得・欺瞞能力 | 非常に高い | 他モデルを上回る | 説得・欺瞞関連のタスクに強み |

| 一般的な指示追従能力 | 高い | 同等またはやや上 | 幅広い指示に対して高い実行性能を示す |

| 安全性(一般的) | 高い | 同等またはやや上 | 化学・生物・サイバーセキュリティを除く領域 |

| コーディング能力 | 非常に高い | 上回る | 他モデルと比べて優れたコーディングスキルを持つ |

| バイオセキュリティ能力 | 高いが突出していない | 大差なし/一部で劣る可能性あり | Qwen 3 Thinking や Kimi K2 なども高性能で競合多数 |

コメント